在人工智能技术飞速发展的今天,学习资源和实践机会已成为从业者最宝贵的资产。DeepLearning.AI近日推出的Pro会员计划,正是为了满足这一需求而生,为AI学习者提供了一条从理论到实践的完整学习路径。本文将深入分析这一会员计划的核心价值、课程体系、实践工具及其对AI教育生态的深远影响。

AI时代的变革:从构想到实现的跨越

"在人类历史上,从未有过一个时刻,从构想到实现的距离如此之短。"这句话精准地概括了当前AI技术带来的变革。过去需要研究团队、开发人员和工程师数月才能完成的工作,如今借助AI技术,小型团队甚至个人在几天内就能实现。这种变革不仅加速了创新进程,也降低了AI技术的入门门槛。

DeepLearning.AI Pro会员计划正是基于这一洞察而设计。它不仅提供理论知识,更强调实践能力的培养,让学习者能够真正将AI技术应用于实际项目中。这种"学以致用"的理念,正是Pro会员计划的核心价值所在。

Pro会员计划的核心优势

全面的课程资源库

Pro会员计划提供150+个专业课程,涵盖AI领域的多个关键方向。这些课程不仅包括Andrew Ng最新推出的Agentic AI课程,还有Sharon Zhou主讲的LLM后训练课程,以及Laurence Moroney开发的PyTorch专业证书课程。这些课程代表了AI领域的最新发展和技术前沿。

值得注意的是,DeepLearning.AI的所有课程视频仍可在平台上免费观看。Pro会员计划在此基础上增加了关键的实践学习环节,包括从零开始构建工作系统的实验室、巩固理解的练习问题,以及展示技能的证书。这种"免费理论+付费实践"的模式,既保证了知识的普及性,又提供了深入的实践机会。

个性化的学习体验

Pro会员计划注重个性化学习体验的打造。每个学习者可以根据自己的兴趣和职业规划,选择适合自己的课程组合。无论是初学者希望建立AI基础知识,还是专业人士希望深入特定领域,都能在Pro会员计划中找到合适的学习路径。

此外,Pro会员计划还提供学习进度跟踪、技能评估和个性化推荐等功能,帮助学习者高效规划学习路径,及时调整学习策略。这些功能使得学习过程更加科学、系统,避免了盲目学习的弊端。

课程体系详解

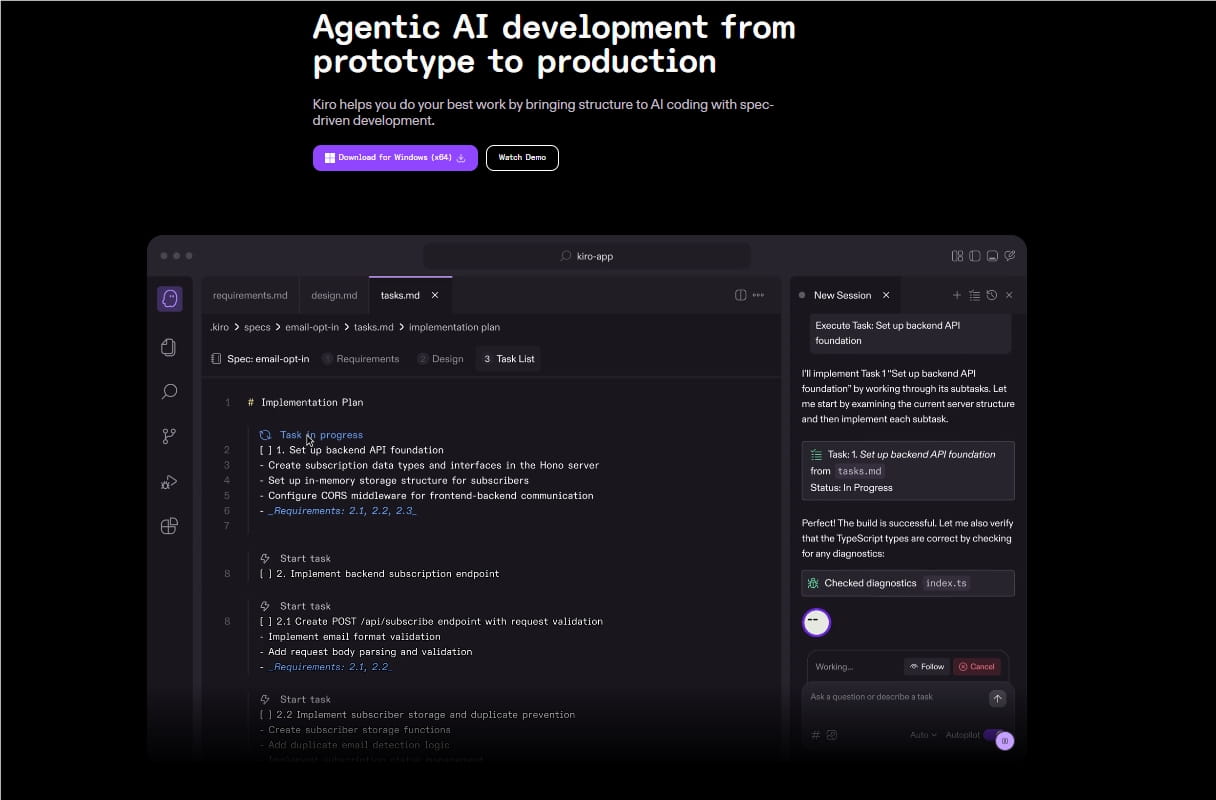

Agentic AI:智能代理的前沿探索

Andrew Ng最新推出的Agentic AI课程,代表了AI领域的最新发展方向。该课程深入探讨了智能代理(Agentic AI)的设计原理、实现方法和应用场景,帮助学习者掌握如何构建能够自主决策和行动的AI系统。

在课程中,学习者将了解如何设计目标导向的AI代理、如何处理复杂环境中的决策问题,以及如何将多个AI代理协同工作以完成复杂任务。这些内容对于希望开发下一代AI应用的学习者来说至关重要。

LLM后训练:大语言模型的进阶之路

由Sharon Zhou主讲的LLM后训练课程,专注于大语言模型(LLM)的高级技术和应用。课程涵盖了微调、强化学习等后训练技术,以及如何优化LLM的性能和效率。

通过这门课程,学习者将掌握如何针对特定任务对预训练模型进行微调,如何通过人类反馈强化学习(RLHF)提升模型质量,以及如何解决LLM在实际应用中面临的各种挑战。这些技能对于希望在大语言模型领域深耕的专业人士来说极为宝贵。

PyTorch专业证书:深度学习的实践基础

Laurence Moroney开发的PyTorch专业证书课程,为深度学习提供了坚实的实践基础。PyTorch作为最受欢迎的深度学习框架之一,其灵活性和易用性使其成为研究和开发的首选工具。

该课程从PyTorch的基础概念开始,逐步深入到复杂的神经网络设计和实现。学习者将通过实际项目掌握如何使用PyTorch构建各种深度学习模型,包括卷积神经网络、循环神经网络和Transformer等。这些技能是任何深度学习从业者必备的核心能力。

实践工具与学习资源

实验室:从理论到实践的桥梁

Pro会员计划提供的实验室环节,是连接理论与实践的关键桥梁。在实验室中,学习者将从零开始构建完整的AI系统,将课程中学到的知识应用到实际项目中。

这些实验室项目涵盖了AI的多个应用领域,包括计算机视觉、自然语言处理、强化学习等。每个实验室都提供了详细的指导文档和代码示例,帮助学习者逐步完成项目,同时鼓励他们进行创新和探索。

练习问题:巩固理解的利器

为了帮助学习者巩固课程内容,Pro会员计划提供了大量的练习问题。这些问题涵盖了从基础概念到高级应用的各个层面,能够全面检验学习者的理解程度。

练习问题不仅包括选择题和填空题等传统形式,还包括编程题和项目设计题等实践性内容。这种多元化的练习方式,确保学习者能够从不同角度理解和应用所学知识。

证书:专业能力的证明

完成课程后,学习者将获得相应的证书。这些证书不仅是学习成果的证明,也是专业能力的展示,对于求职和职业发展具有重要意义。

DeepLearning.AI的证书在业界享有很高的声誉,被许多知名企业和机构认可。获得这些证书,不仅能提升学习者的职业竞争力,还能为他们的职业发展打开新的机会之门。

新工具与未来发展方向

专为AI应用开发的新工具

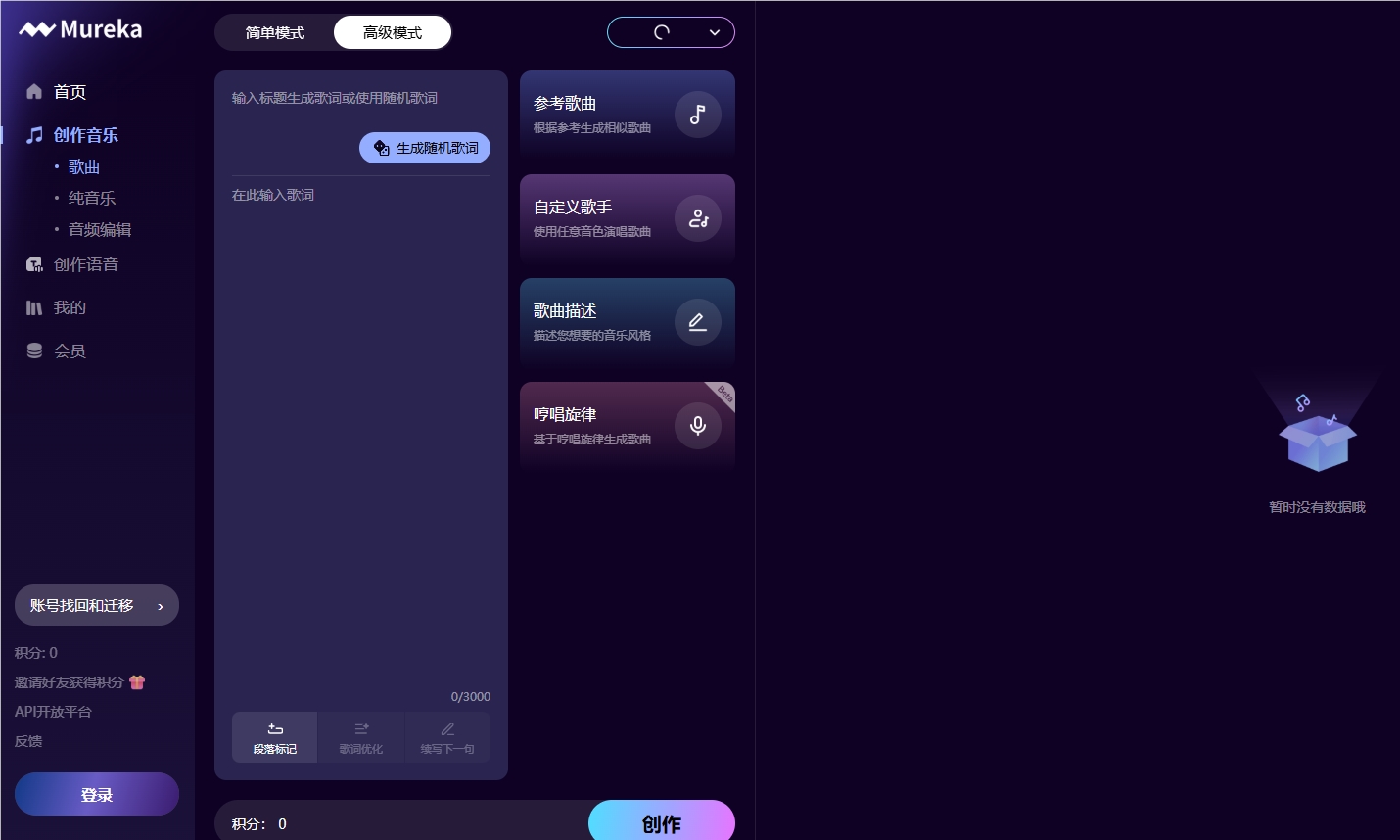

除了现有的课程和资源,DeepLearning.AI还在开发一系列新工具,帮助学习者更高效地构建AI应用。这些工具涵盖了从数据处理到模型部署的整个AI开发生命周期。

这些新工具将首先向Pro会员开放,使会员能够率先体验最新的AI开发技术。这种"会员优先"的策略,不仅提升了会员的价值感,也为AI工具的实际应用提供了宝贵的反馈机会。

职业发展支持

Pro会员计划还提供职业发展支持,帮助学习者将AI技能转化为职业机会。这包括简历优化、面试准备、职业规划等服务,以及与行业专家的交流机会。

通过这些服务,学习者不仅能够提升技术能力,还能够了解行业动态,拓展职业网络,为未来的职业发展奠定坚实基础。

如何最大化Pro会员计划的价值

制定明确的学习目标

要充分利用Pro会员计划的价值,首先需要制定明确的学习目标。学习者应该根据自己的兴趣和职业规划,确定学习的重点方向和预期成果。明确的目标能够帮助学习者更有针对性地选择课程和项目,提高学习效率。

保持持续的学习习惯

AI技术发展迅速,持续学习是保持竞争力的关键。Pro会员计划提供了丰富的学习资源,学习者应该建立持续学习的习惯,定期更新知识体系,掌握最新的技术动态。

积极参与社区交流

DeepLearning.AI拥有活跃的学习社区,学习者可以通过社区交流获得更多学习资源和支持。积极参与社区讨论,分享学习心得,解决学习难题,能够极大地提升学习效果。

将理论与实践结合

Pro会员计划强调实践能力的培养,学习者应该充分利用实验室和项目机会,将理论知识转化为实际技能。通过实践,不仅能够加深对理论的理解,还能够培养解决实际问题的能力。

结语:AI学习的新范式

DeepLearning.AI Pro会员计划的推出,标志着AI教育进入了一个新的阶段。它不仅提供了丰富的学习资源,更构建了一个从理论到实践的完整学习生态系统。在这个生态中,学习者可以根据自己的需求选择合适的学习路径,通过实践项目巩固知识,获得专业认证,并借助各种工具加速AI应用的开发。

对于希望在AI领域有所作为的学习者来说,Pro会员计划无疑是一个宝贵的资源。它不仅能够帮助学习者掌握最新的AI技术,还能够培养解决实际问题的能力,为职业发展奠定坚实基础。正如Andrew Ng在信中所说:"现在是利用AI构建应用的时刻",而DeepLearning.AI Pro会员计划,正是实现这一目标的理想伙伴。

随着AI技术的不断发展,DeepLearning.AI Pro会员计划也将持续更新和优化,为学习者提供最新的学习资源和实践机会。在这个AI技术日新月异的时代,拥有一个全面、系统的学习平台,无疑是在竞争中保持优势的关键。