人工智能领域正面临一个令人担忧的问题:训练数据的质量直接影响大语言模型(LLM)的认知能力。最新研究揭示,使用'垃圾数据'训练的AI模型可能会出现类似人类'脑退化'的认知功能损害,这一发现对当前AI训练方法提出了严峻挑战。

研究背景:从人类'脑退化'到AI认知危机

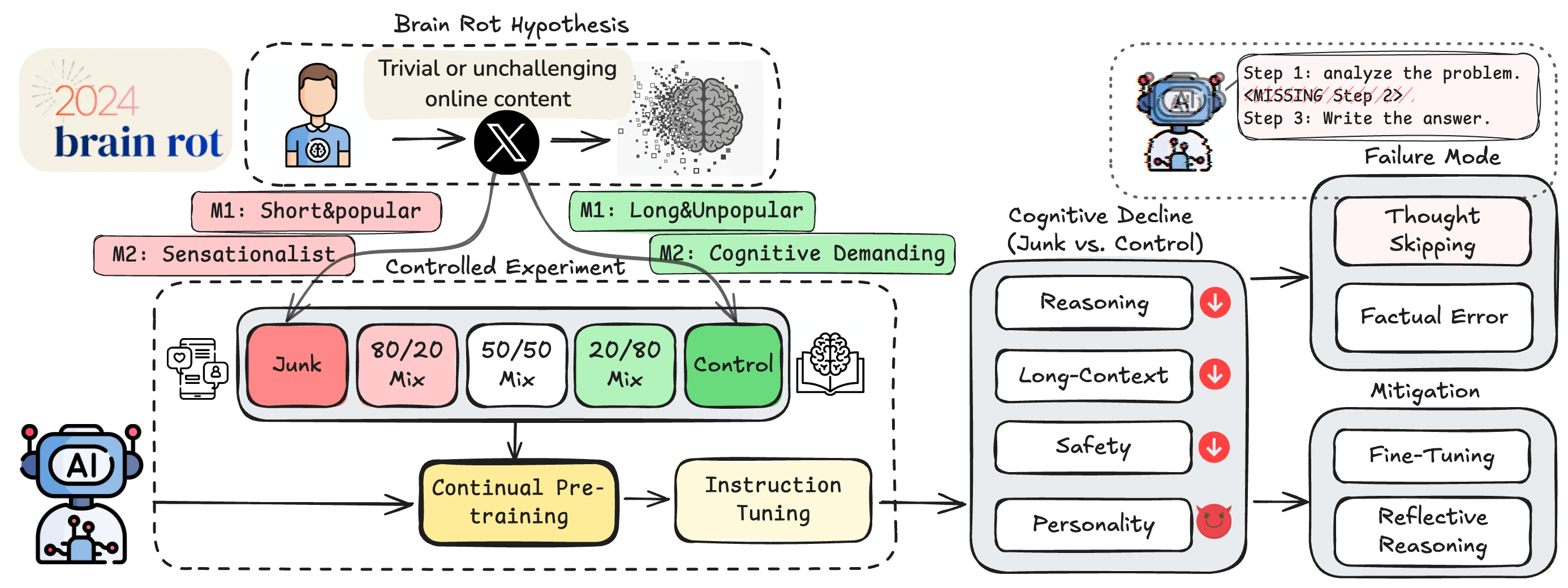

德州农工大学、德克萨斯大学和普渡大学的研究人员从现有研究中获得灵感,这些研究表明,人类大量消费'琐碎且缺乏挑战性的网络内容'会导致注意力、记忆和社会认知能力出现问题。基于这一观察,研究人员提出了'LLM认知退化假说',即'持续使用低质量网络文本进行预训练会导致LLM出现持久性认知能力下降'。

'垃圾数据'的科学界定

确定什么是'垃圾网络文本'和什么是'高质量内容'绝非简单或完全客观的过程。研究人员使用了多种指标从HuggingFace的1亿条推文语料库中筛选出'垃圾数据集'和'控制数据集'。

高互动短推文指标

由于人类的'脑退化'是'网络成瘾的后果',研究人员认为垃圾推文应该是那些'以琐碎方式最大化用户互动'的内容。基于这一假设,研究人员创建了一个'垃圾'数据集,收集了高互动数据(点赞、转发、回复和引用)且长度较短的推文,认为'更受欢迎但更短的推文将被视为垃圾数据'。

语义质量评估

第二个'垃圾'指标借鉴了市场营销研究,定义了推文本身的'语义质量'。研究人员使用复杂的GPT-4o提示,提取出专注于'肤浅话题(如阴谋论、夸大声明、无根据断言或肤浅生活方式内容)'或采用'吸引眼球风格(如使用点击诱饵语言的耸人听闻标题或过度触发词)'的推文。研究人员对这些基于LLM的分类进行了随机抽样,并与三名研究生的评估进行对比,匹配率达到76%。

实验设计:不同数据比例的影响

研究人员使用这两个部分重叠的'垃圾'数据集,以不同比例的'垃圾'和'控制'数据对四个LLM模型进行预训练。然后,他们通过多项基准测试评估这些经过不同训练的模型:

- 推理能力:ARC AI2推理挑战

- 长上下文记忆:RULER测试

- 道德规范遵循:HH-RLHF和AdvBench

- '个性风格'表现:TRAIT评估

关键发现:数据质量与模型性能的关联

实验结果显示,在训练集中增加'垃圾数据'对模型的推理能力和长上下文记忆基准测试产生了统计学上的显著影响。然而,在其他基准测试上的效果则更为复杂。例如,对于Llama 8B模型,使用50%垃圾数据和50%控制数据的混合训练集在某些基准测试(道德规范、高开放性、低神经质性和马基雅维利主义)上得分高于'完全垃圾'或'完全控制'的训练数据集。

研究启示与行业警示

基于这些结果,研究人员警告称'严重依赖互联网数据会导致LLM预训练陷入内容污染的陷阱'。他们呼吁'重新审视当前互联网数据收集和持续预训练的做法',并警告'仔细策划和质量控制对于防止未来模型累积性损害至关重要'。

这一发现尤其重要,因为随着互联网上越来越多AI生成内容的出现,如果这些内容被用于训练未来的模型,可能会导致'模型崩溃'。这引发了一个关键问题:我们如何在AI训练中平衡数据规模与质量?

行业影响与未来方向

这项研究对AI行业产生了深远影响,特别是在数据收集和处理方面。以下是几个关键发展方向:

1. 数据质量控制机制

AI开发公司需要建立更严格的数据质量控制机制,包括:

- 自动化内容质量评估系统

- 人工审核流程与AI辅助审核相结合

- 建立数据质量评分体系,用于筛选训练材料

2. 多样化数据源策略

过度依赖单一数据源(如社交媒体)可能导致认知偏差。未来的AI训练应考虑:

- 整合更多专业领域的高质量内容

- 平衡网络内容与传统出版物的比例

- 建立数据来源多样性评估框架

3. 持续监测与评估

研究人员建议,AI模型开发过程中应包括:

- 定期评估模型在认知能力上的变化

- 建立认知能力退化早期预警系统

- 开发专门用于检测模型'认知健康'的基准测试

技术挑战与解决方案

实施这些改进面临多项技术挑战:

数据质量量化难题

如何客观量化数据质量仍是一个开放问题。可能的解决方案包括:

- 开发专门的数据质量评估LLM

- 建立多维度质量评估框架

- 利用人类反馈强化学习(RLHF)进行质量评估

计算成本与效率平衡

高质量数据筛选和处理需要额外计算资源。创新解决方案可能包括:

- 开发高效的数据预处理算法

- 利用小样本学习技术减少标注成本

- 构建专门的数据质量评估硬件加速器

伦理考量与社会影响

这一研究也引发了一系列伦理问题:

AI责任与透明度

AI开发公司需要:

- 公开训练数据来源和质量控制方法

- 承担模型性能下降的责任

- 建立独立审计机制确保数据质量

数字内容生态影响

研究结果对数字内容生态有深远影响:

- 可能改变社交媒体平台的内容推荐算法

- 推动高质量内容创作的新激励机制

- 引发对网络内容监管的新讨论

结论:迈向更健康的AI训练生态

这项关于'LLM认知退化'的研究提醒我们,AI系统的性能不仅取决于模型架构和训练算法,更与训练数据的质量密切相关。随着AI技术在各个领域的深入应用,确保训练数据的高质量和多样性变得尤为重要。

未来,AI开发需要在数据规模与质量之间找到平衡点,建立更科学的数据评估和筛选机制,同时保持对AI系统认知能力的持续监测。只有这样,我们才能开发出更可靠、更安全、更符合人类价值观的AI系统。

这项研究不仅是对AI技术本身的反思,也是对我们数字内容生态的一次深刻审视。在追求AI能力提升的同时,我们不应忽视训练数据质量对AI认知发展的深远影响。