在过去的几年里,人工智能生成内容已如野火般蔓延至互联网的每个角落。从早期那些有着畸形手的AI合成图像,到如今几乎可以乱真的深度伪造视频,技术进步带来的不仅是创作便利,更带来了前所未有的身份盗用风险。作为这一技术浪潮的重要推动者,Google如今正试图在YouTube平台上遏制AI视频的滥用问题,其最新推出的'相似度检测'系统标志着数字身份保护战进入了一个新阶段。

AI内容泛滥与身份盗用危机

Google强大且免费开放的AI模型在一定程度上助长了AI内容的爆炸式增长,其中部分内容被用于传播虚假信息和骚扰个人。创作者和网红们担心,大量AI生成的视频可能会损害他们的品牌形象——这些视频展示着他们从未说过的话、从未做过的事。这种担忧不仅限于普通创作者,就连立法者们也开始关注这一问题,并推动相关法案的制定,如旨在禁止未经授权的数字复制品的《无伪造法案》。

Google在AI内容领域投入巨大,因此完全禁止AI内容出现在YouTube上——正如许多人所呼吁的那样——显然不符合其商业利益。相反,公司选择了一种折中方案:通过技术手段帮助创作者保护自己的数字身份。

相似度检测系统的工作原理

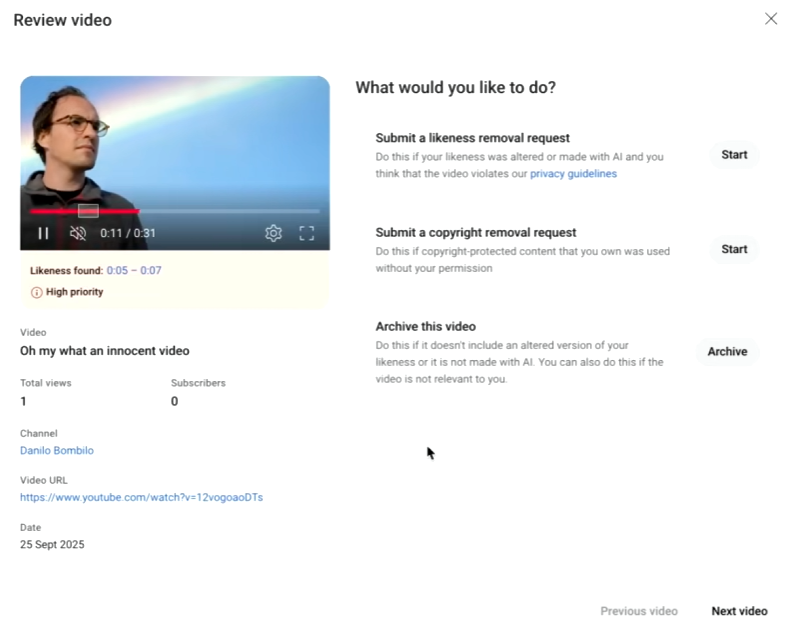

今年早些时候,YouTube承诺将推出能够识别平台上人脸盗用AI内容的工具。现在,这一'相似度检测'系统已从小规模测试阶段扩展至更广泛的创作者群体。该系统类似于YouTube已有的版权检测系统,能够自动扫描平台上的视频内容,标记出可能包含特定创作者面部特征的AI生成内容。

目前,相似度检测仍处于有限测试的测试版阶段,并非所有创作者都能在YouTube工作室中看到这一选项。当它出现时,将被整合到现有的'内容检测'菜单中。根据YouTube的演示视频,设置流程似乎假设频道只有一位主持人需要保护其面部特征。这位主持人必须验证身份,这需要提供政府身份证照片和本人面部视频。

值得注意的是,YouTube需要这些额外数据,尽管创作者已经在自己的视频中展示了那些容易被盗用的面部特征。这种要求引发了一些隐私方面的担忧,但平台似乎认为这是必要的验证步骤。

系统的局限性与挑战

尽管相似度检测系统为创作者提供了一定的保护,但它并非完美无缺。首先,YouTube的算法无法100%确定哪些是AI视频,因此一些面部匹配结果可能是误报——特别是那些遵循合理使用准则使用了创作者短片段的频道。

当创作者确实发现AI伪造内容时,他们可以添加一些细节并在几分钟内提交报告。如果视频包含从创作者频道复制的内容且不遵循合理使用准则,YouTube建议同时提交版权删除请求。然而,仅仅因为某人的形象出现在AI视频中,并不一定意味着YouTube会将其移除。

YouTube已经公布了一份清单,详细说明了审查人员在决定是否批准删除请求时将考虑的因素。例如,标记为AI的 parody 内容或具有不现实风格的视频可能未达到删除门槛。另一方面,可以肯定的是,展示某人代言产品或参与非法活动的逼真AI视频将违反规定并被YouTube移除。

隐私与便利的平衡

相似度检测系统的推出引发了关于隐私与便利之间平衡的讨论。创作者为了获得保护,需要向Google提供额外的个人敏感信息,这本身就存在数据泄露的风险。此外,系统对'相似度'的定义和判断标准并不透明,创作者可能不清楚自己的哪些面部特征会被纳入检测范围。

从技术角度看,AI面部识别技术本身也存在局限性。不同光照条件、角度变化、面部表情等因素都可能影响识别准确率。此外,随着AI技术的进步,深度伪造视频的质量也在不断提高,这给检测系统带来了持续的压力。

行业竞争与技术演进

Google近期发布了新的Veo 3.1视频模型,支持人像和风景AI视频的生成。公司此前已承诺将Veo集成到YouTube中,这将使人们更容易生产可能包含真实人物描绘的AI内容。与此同时,Google的竞争对手OpenAI其Sora AI视频应用及其支持的Sora 2模型在用户中取得了成功(至少在流行度方面)。这可能会推动Google加速其在YouTube的AI计划,但正如我们从Sora看到的,人们热衷于让公众人物做出奇怪的事情。

这种竞争态势意味着AI视频内容可能会在未来几个月内迎来爆发式增长。热门创作者可能需要开始像提交DMCA删除请求一样,定期提交AI形象投诉。这不仅增加了创作者的负担,也对平台的内容审核能力提出了更高要求。

法律与监管框架的缺失

目前,针对AI生成内容的法律和监管框架仍在发展中。虽然一些地区已经开始制定相关法规,但全球范围内的法律标准尚未统一。这种法律环境的不确定性使得平台在处理AI内容问题时面临挑战。

YouTube的相似度检测系统在一定程度上填补了这一空白,但它并非法律解决方案。它更像是一种技术补救措施,旨在在法律框架完善之前为创作者提供一定程度的保护。然而,这种技术手段的有效性很大程度上依赖于平台的执行力度和算法的准确性。

未来展望

随着AI技术的不断发展,我们可以预见相似度检测系统将需要持续更新和改进。未来的版本可能会整合更先进的AI检测技术,能够更准确地识别深度伪造内容。同时,系统可能会增加更多自定义选项,让创作者能够更精细地控制哪些面部特征或使用场景需要保护。

此外,随着行业标准的逐步建立,我们可能会看到更多平台采用类似的保护机制。这种行业自律与监管相结合的方式,或许能够在保护创作者权益的同时,促进AI技术的健康发展。

创作者的应对策略

在等待技术和法律框架完善的同时,创作者也可以采取一些主动措施保护自己的数字身份:

- 定期监控平台:积极使用YouTube的相似度检测工具,同时关注其他平台上的内容。

- 建立数字指纹:在多个平台建立独特的数字身份,增加盗用的难度。

- 法律咨询:了解相关法律权益,必要时寻求专业法律帮助。

- 社区支持:与其他创作者建立联盟,共享信息和资源,共同应对AI盗用问题。

结语

YouTube推出的相似度检测系统代表了数字内容平台在应对AI挑战方面的重要一步。它不仅为创作者提供了一种保护自己数字身份的工具,也反映了整个行业在技术创新与伦理责任之间的探索和平衡。

然而,这一系统只是解决方案的开始,而非终点。随着AI技术的不断进步,我们需要持续发展更有效的检测技术、更完善的法律框架和更广泛的行业共识。只有通过多方协作,我们才能在享受AI技术带来便利的同时,有效保护每个人的数字身份和权益。

在这场数字身份保卫战中,技术、法律和伦理缺一不可。YouTube的尝试为行业树立了一个标杆,但真正的挑战在于如何构建一个既鼓励创新又保护权益的数字生态系统。