在人工智能领域,大型语言模型(LLM)的竞争格局正变得前所未有的激烈。最近,谷歌推出的实验性大模型Gemini-Exp-1114,凭借其卓越的性能,一举登上了lmarena.ai的榜首,超越了OpenAI的ChatGPT O1,这一成就无疑为谷歌在AI领域树立了一个新的里程碑,也为全球LLM的发展设定了新的标杆。本文将深入剖析Gemini-Exp-1114成功背后的数据和原因,并探讨其对行业的影响。

Gemini-Exp-1114在lmarena.ai榜单上的卓越表现

谷歌近期发布的实验性语言模型Gemini-Exp-1114,通过Google AI Studio向公众开放测试,并以其全面的任务能力和跨领域表现脱颖而出,以下是其主要亮点:

- 多任务表现优异:Gemini-Exp-1114在数学、创意写作、指令执行和多轮对话等多个类别中均取得了领先地位。这种全面的能力使其在各种实际应用场景中都能表现出色。

- 视觉AI实力突出:该模型能够从图片中精准生成对应的HTML和CSS代码,这一突破性的功能展示了其在视觉任务中的强大能力。这为开发者提供了一个全新的工具,可以快速将视觉设计转化为可执行的代码。

- 综合能力领先:尽管在一些复杂的代码生成和硬提示风格控制任务中,Gemini-Exp-1114的表现略逊,仅排名第三,但其整体表现依然强劲,足以确保其在榜单上名列前茅。这种综合性的优势使其在各种不同的任务中都能保持卓越的性能。

正是凭借这些优势,谷歌的大模型首次在综合性排行榜中超越了OpenAI的旗舰产品,成为了新的行业标杆。这不仅证明了谷歌在AI技术方面的实力,也预示着LLM领域的竞争将更加激烈。

lmarena.ai榜单的排名方法与权威性

lmarena.ai是由UC Berkeley SkyLab和LMSYS团队开发的开放式社区平台,旨在通过人类偏好评估LLM的性能,其特点如下:

- 排名方法

- lmarena.ai采用Bradley-Terry模型,通过对模型的两两比较,计算得出相对评分。这种方法能够有效地评估模型在不同任务中的表现,并确保排名的公正性和客观性。

- 数据的来源广泛,既包括专家评审,也包括普通用户投票,从而确保了多样性和公平性。这种综合性的评估方法能够更全面地反映模型的实际性能。

- 平台权威性

- lmarena.ai已经积累了超过100万次投票,数据覆盖了多种任务类型。如此庞大的数据集为评估模型的性能提供了可靠的依据。

- 研究显示,投票结果与专家评分高度一致,验证了其评价机制的可信性。这意味着lmarena.ai的排名能够准确地反映模型在实际应用中的表现。

- 行业认可度

- lmarena.ai被广泛引用,成为行业内对比模型性能的主要参考之一。许多研究机构和企业都使用该平台来评估和比较不同的LLM。

Gemini-Exp-1114在该平台上的胜出更具说服力,进一步证明了其卓越的性能和竞争力。

中国大模型在lmarena.ai榜单中的表现

1. 榜单前28名模型

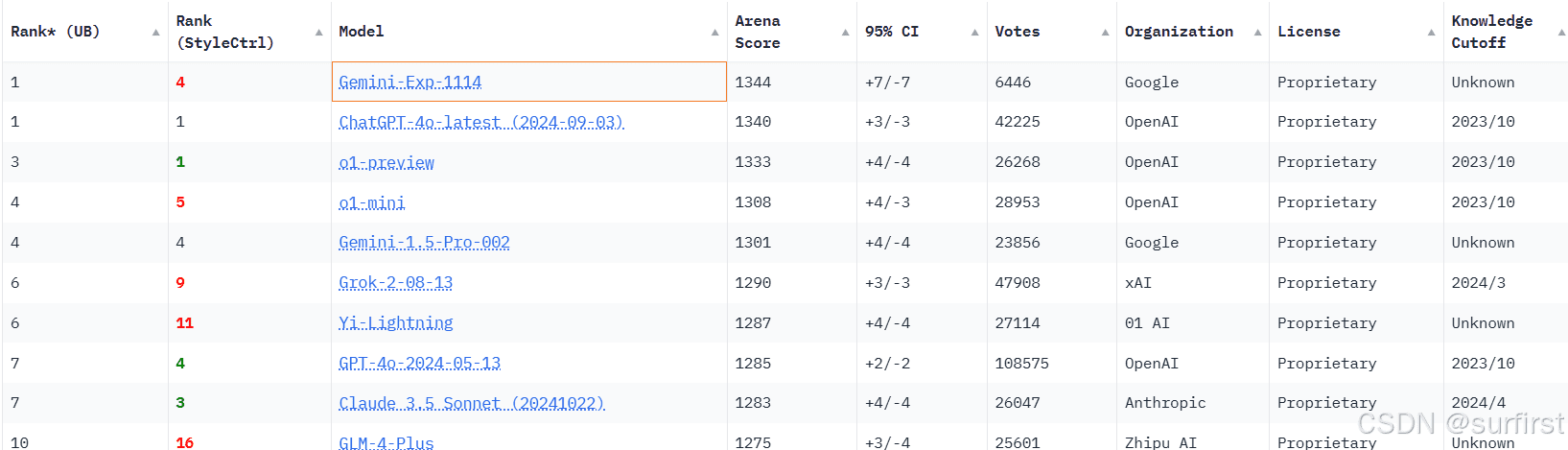

LM Arena是当前最权威的跨语言模型性能评估平台之一。它基于用户反馈和多维度评估指标,对各大语言模型进行排序。以下是截至当前榜单中的前28名:

| 排名 | 模型名称 | 分数 | 组织 | 知识截止 |

|---|---|---|---|---|

| 1 | Gemini-Exp-1114 | 1344 | Unknown | |

| 1 | ChatGPT-4o-latest (2024-02-03) | 1340 | OpenAI | 2023/10 |

| 3 | o1-preview | 1333 | OpenAI | 2023/10 |

| 4 | o1-mini | 1308 | OpenAI | 2023/10 |

| 4 | Gemini-1.5-Pro-002 | 1301 | Unknown | |

| 6 | Grok-2-08-13 | 1290 | xAI | 2024/3 |

| 6 | Yi-Lightning | 1287 | 01万物 | Unknown |

| 7 | GPT-4o-2024-05-13 | 1285 | OpenAI | 2023/10 |

| 7 | Claude-3.5-Sonnet (20241022) | 1283 | Anthropic | 2024/4 |

| 10 | GLM-4-Plus | 1275 | 智谱AI | Unknown |

| 10 | GPT-4o-mini-2024-07-18 | 1272 | OpenAI | 2023/10 |

| 10 | Gemini-1.5-Flash-002 | 1272 | Unknown | |

| 10 | llama-3.1-Nemotron-70B-Instruct | 1269 | Nvidia | 2023/12 |

| 10 | Meta-llama-3.1-405B-Instruct-fp8 | 1267 | Meta | 2023/12 |

| 10 | Meta-llama-3.1-405B-Instruct-bf16 | 1266 | Meta | 2023/12 |

| 11 | Claude-3.5-Sonnet (20240620) | 1268 | Anthropic | 2024/4 |

| 11 | Grok-2-Mini-08-13 | 1267 | xAI | 2024/3 |

| 12 | Gemini-Advanced-App (2024-05-14) | 1267 | Online | |

| 12 | GPT-4o-2024-08-06 | 1265 | OpenAI | 2023/10 |

| 12 | Yi-Lightning-lite | 1264 | 01万物 | Unknown |

| 12 | Qwen-Max-0919 | 1263 | 阿里巴巴 | Unknown |

| 17 | Qwen2.5-72B-Instruct | 1259 | 阿里巴巴 | 2024/9 |

| 18 | Gemini-1.5-Pro-001 | 1260 | 2023/11 | |

| 18 | Deepseek-v2.5 | 1258 | DeepSeek | Unknown |

| 22 | GPT-4-Turbo-2024-04-09 | 1256 | OpenAI | 2023/12 |

| 25 | Mistral-Large-2407 | 1251 | Mistral | 2024/7 |

| 25 | Athene-70B | 1250 | NexusFlow | 2024/7 |

| 26 | GPT-4-1106-preview | 1250 | OpenAI | 2023/4 |

从这份榜单可以看出,Google的Gemini-Exp-1114凭借1344的高分,与OpenAI的ChatGPT-4o-latest并列第一。Google和OpenAI在顶级榜单中占据了主导地位,显示出它们在LLM领域的强大实力。

2. 中国公司大模型的亮点与排名

在榜单中,中国的人工智能公司也有着亮眼的表现:

- 01 AI的Yi-Lightning:以1287的分数排名第6,展现了中国在快速发展LLM方面的实力。

- 智谱AI (Zhipu AI)的GLM-4-Plus:以1275的分数排名第10,表明中国在AI技术方面取得了显著进展。

- 阿里巴巴的Qwen系列:分别排名第12(Qwen-Max-0919,分数1263)和第17(Qwen2.5-72B-Instruct,分数1259),展示了中国企业在全球LLM竞争中的实力。

虽然中国模型的总分稍低,但在特定任务上表现出色,尤其是在中文和多语言领域的优势。这些模型的崛起表明中国公司在全球LLM竞争中正在发挥越来越重要的作用。

Gemini-Exp-1114胜出的原因及优缺点

1. 胜出的原因

- 全面的任务覆盖:Gemini-Exp-1114在数学、指令理解、多轮对话和创意写作等多个领域都名列前茅。这种全面的能力使其在各种不同的应用场景中都能表现出色。

- 视觉AI的突破:通过分析图片生成高质量代码的能力在当前行业中是独树一帜的。这为开发者提供了一个全新的工具,可以快速将视觉设计转化为可执行的代码。

- 用户体验的改进:通过Google AI Studio提供开放式测试,增强了用户对模型能力的直观感受。这种开放式的测试模式有助于收集用户反馈,从而不断改进模型的性能。

2. 优缺点分析

- 优势

- 技术多样性:Gemini-Exp-1114兼备语言和视觉任务处理能力,充分展示了其跨模态能力。这种多样性使其在处理复杂任务时更具优势。

- 创新性任务能力:Gemini-Exp-1114能够生成仓储优化算法,解决复杂逻辑问题等。这些创新性的任务能力使其在某些特定领域具有独特的优势。

- 情感与创意表达:Gemini-Exp-1114能够完成高质量的创意写作和情感交流。这使其在人机交互方面更具吸引力。

- 局限性

- 响应速度偏慢:与同类模型相比,Gemini-Exp-1114在响应速度方面稍有滞后,这可能是由于其优先考虑精准性所致。

- 上下文限制:32k token的上下文长度在大模型中并不算突出。这意味着Gemini-Exp-1114在处理长文本时可能会受到一定的限制。

- 特定任务表现稍弱:在代码生成和硬提示风格控制任务中,Gemini-Exp-1114的表现略逊于竞争对手。这表明其在某些特定领域仍有改进空间。

总结与展望

Gemini-Exp-1114的问世不仅刷新了行业基准,还展示了谷歌在跨模态任务中的领先地位。然而,这一成就也伴随着新的挑战——如何进一步优化性能和扩展模型能力,将决定其能否长期保持行业领先地位。未来,我们可以期待看到Gemini-Exp-1114在更多领域的应用,以及其对LLM技术发展的进一步推动。

对于用户而言,Gemini-Exp-1114的公开测试提供了一个探索下一代AI的绝佳机会。用户可以通过实际体验来了解其能力,并为其未来的发展提供反馈。对于行业而言,竞争的持续加剧无疑将推动LLM技术进入新的发展阶段,从而为各行各业带来更多的创新和机遇。