Langchain与Gemini的集成应用探索:打造智能对话系统的进阶之路

在人工智能领域,构建能够理解和生成自然语言的智能对话系统一直是研究的热点。大型语言模型(LLM)如Google的Gemini,以其强大的语言理解和生成能力,为这一领域带来了革命性的进步。本文将深入探讨如何将Langchain这一强大的开发框架与Gemini模型相结合,构建更高效、更灵活的智能对话应用。

Langchain与Gemini:强强联合的技术基础

Langchain是一个旨在简化LLM应用开发的框架,它提供了一系列的工具、组件和接口,使得开发者能够更方便地利用LLM构建各种应用,如聊天机器人、问答系统、文本摘要等。Gemini则是由Google开发的多模态大语言模型,它不仅能够处理文本信息,还能理解图像、音频等多种模态的数据,从而实现更丰富、更智能的交互。

将Langchain与Gemini集成,可以充分发挥两者的优势:Langchain负责处理应用的流程和逻辑,Gemini负责提供强大的语言理解和生成能力。这种结合,可以大大提高开发效率,并为用户带来更优质的体验。

集成Langchain与Gemini:核心步骤与代码示例

Langchain已经成功地将Gemini模型整合到其生态系统中,通过ChatGoogleGenerativeAI类可以方便地使用Gemini模型。下面,我们将详细介绍集成的核心步骤,并提供相应的代码示例。

1. 初始化Gemini模型

首先,需要创建一个ChatGoogleGenerativeAI类的实例,并指定要使用的Gemini模型。例如,可以使用gemini-pro模型来处理文本输入,或者使用gemini-pro-vision模型来处理包含图像的输入。

from langchain_google_genai import ChatGoogleGenerativeAI

llm = ChatGoogleGenerativeAI(model="gemini-pro")2. 简单的文本查询

接下来,可以使用invoke方法向模型发送查询请求,并获取生成的响应。

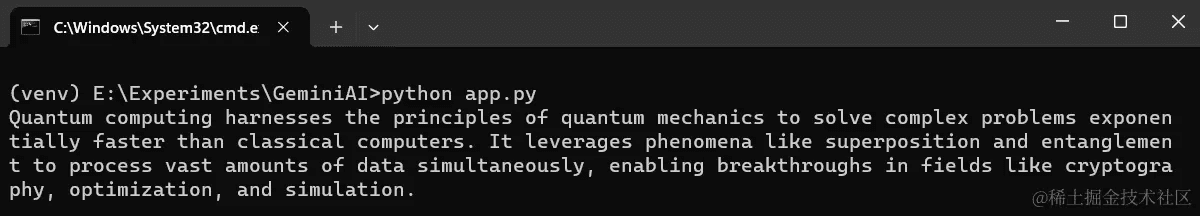

response = llm.invoke("Explain Quantum Computing in 50 words?")

print(response.content)这段代码将向Gemini模型发送一个关于量子计算的查询,并要求模型用50个词进行解释。模型将返回一个包含解释文本的响应。

3. 批量处理多个查询

Langchain还支持批量处理多个查询请求,这可以提高处理效率。可以使用batch方法将多个查询请求发送给模型,并获取每个查询的响应。

batch_responses = llm.batch(

[

"Who is the Prime Minister of India?",

"What is the capital of India?",

]

)

for response in batch_responses:

print(response.content)这段代码将向Gemini模型发送两个查询请求,一个是关于印度总理的,另一个是关于印度首都的。模型将返回两个响应,分别包含对应查询的答案。

4. 处理包含图像的查询

如果需要处理包含图像的查询,可以使用gemini-pro-vision模型。首先,需要创建一个HumanMessage对象,并将文本和图像数据添加到该对象中。然后,将该对象传递给模型的invoke方法。

from langchain_core.messages import HumanMessage

llm = ChatGoogleGenerativeAI(model="gemini-pro-vision")

message = HumanMessage(

content=[

{

"type": "text",

"text": "What is in this picture?"

},

{

"type": "image_url",

"image_url": {

"url": "URL of your image",

}

}

]

)

response = llm.invoke([message])

print(response.content)请注意,需要将"URL of your image"替换为实际的图像URL。这段代码将向Gemini模型发送一个包含图像的查询,并要求模型描述图像中的内容。

Langchain与Gemini集成的优势与应用场景

Langchain与Gemini的集成具有以下优势:

- 强大的语言理解和生成能力:Gemini模型具有强大的语言理解和生成能力,可以处理各种复杂的自然语言任务。

- 多模态数据处理能力:Gemini模型可以处理文本、图像、音频等多种模态的数据,从而实现更丰富、更智能的交互。

- 灵活的应用开发:Langchain提供了一系列的工具、组件和接口,使得开发者能够更方便地利用Gemini模型构建各种应用。

- 高效的开发流程:Langchain简化了LLM应用的开发流程,提高了开发效率。

基于这些优势,Langchain与Gemini的集成可以应用于各种场景,例如:

- 智能客服:构建能够理解用户意图、回答用户问题、解决用户问题的智能客服系统。

- 智能问答:构建能够从海量数据中提取信息、回答用户问题的智能问答系统。

- 内容创作:辅助用户进行文章撰写、文本摘要、标题生成等内容创作任务。

- 教育辅导:为学生提供个性化的学习辅导,例如答疑解惑、作业批改、知识点讲解等。

- 医疗健康:辅助医生进行疾病诊断、治疗方案制定、健康咨询等。

案例分析:基于Langchain和Gemini的智能客服系统

为了更具体地说明Langchain与Gemini集成的应用,我们以构建一个智能客服系统为例进行案例分析。

1. 系统需求分析

该智能客服系统需要具备以下功能:

- 能够理解用户的自然语言提问。

- 能够从知识库中检索相关信息。

- 能够根据检索到的信息生成自然语言回复。

- 能够处理用户的多轮对话。

2. 系统架构设计

该智能客服系统可以采用以下架构:

- 用户界面:用户与系统进行交互的界面,可以使用网页、App等形式。

- 自然语言处理模块:负责对用户的自然语言提问进行处理,包括分词、词性标注、语义分析等。

- 知识库:存储系统需要用到的知识,可以使用数据库、文本文件等形式。

- 检索模块:负责从知识库中检索与用户提问相关的信息。

- 对话管理模块:负责管理用户的对话状态,处理用户的多轮对话。

- 回复生成模块:负责根据检索到的信息生成自然语言回复。

3. 技术选型

在该系统中,我们可以使用Langchain与Gemini进行以下技术选型:

- 自然语言处理模块:使用Langchain提供的自然语言处理工具,例如文本分割器、词向量模型等。

- 检索模块:使用Langchain提供的向量数据库集成,例如Chroma、FAISS等。

- 回复生成模块:使用Gemini模型生成自然语言回复。

4. 实现步骤

以下是构建该智能客服系统的主要步骤:

- 准备知识库:将需要用到的知识存储到知识库中。

- 构建自然语言处理模块:使用Langchain提供的工具构建自然语言处理模块。

- 构建检索模块:使用Langchain提供的向量数据库集成构建检索模块。

- 构建回复生成模块:使用Langchain与Gemini集成构建回复生成模块。

- 构建对话管理模块:构建对话管理模块,处理用户的多轮对话。

- 集成各个模块:将各个模块集成起来,构建完整的智能客服系统。

结论与展望

通过本文的介绍,我们可以看到,Langchain与Gemini的集成具有强大的潜力,可以应用于各种智能对话场景。随着人工智能技术的不断发展,我们可以期待Langchain与Gemini在未来能够发挥更大的作用,为人类带来更智能、更便捷的生活体验。

未来的研究方向包括:

- 多模态数据的融合:如何更好地融合文本、图像、音频等多种模态的数据,以提高模型的理解能力和生成能力。

- 知识库的构建与维护:如何构建高质量的知识库,并对其进行有效的维护和更新。

- 对话管理策略的优化:如何设计更有效的对话管理策略,以提高对话的流畅性和准确性。

- 模型的可解释性:如何提高模型的可解释性,以便更好地理解模型的行为和预测结果。

希望本文能够帮助读者了解Langchain与Gemini集成的基本原理和应用方法,并为读者在智能对话系统领域的探索提供一些参考。