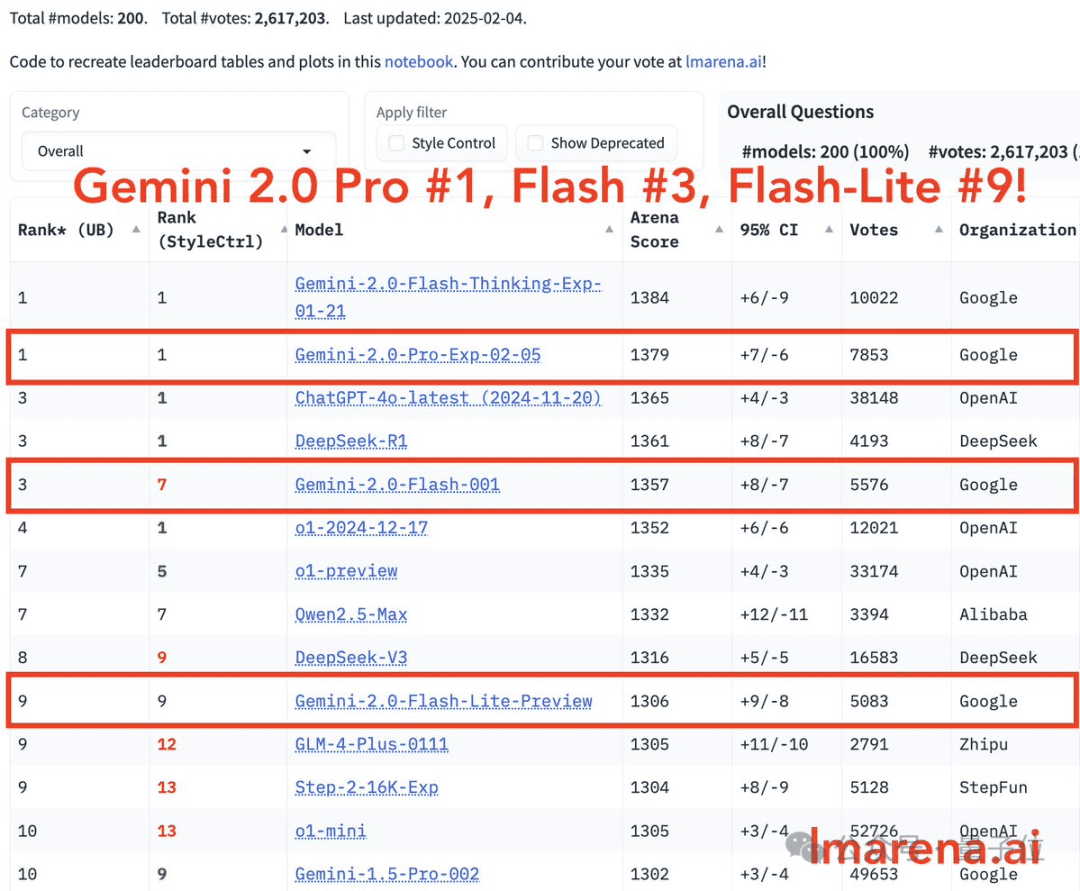

谷歌DeepMind再次出手,这次的目标直指DeepSeek-R1!谷歌CEO桑达尔·皮查伊亲自宣布了Gemini 2.0家族的重大更新,包括Gemini 2.0 Flash、Gemini 2.0 Pro和Gemini 2.0 Flash-Lite三款全新模型。其中,Gemini 2.0 Flash Thinking已经稳坐大模型竞技场的头把交椅,并已在Gemini应用中上线。令人瞩目的是,Gemini 2.0家族的所有模型都成功跻身大模型竞技场的前十名,且Gemini 2.0 Pro在性能上超越了DeepSeek-R1,展现了谷歌在AI领域的强大实力。

谷歌首席科学家杰夫·迪恩表示:“与1.5系列模型相比,2.0系列的每一款通常都比1.5系列的同型号更好”。

此次更新中最引人关注的当属Gemini 2.0 Pro和Gemini 2.0 Flash-Lite。Gemini 2.0 Pro是谷歌目前在编码和复杂指令任务中表现最佳的模型,拥有高达200万tokens的上下文窗口,并支持调用谷歌搜索和代码执行等实用工具。而Gemini 2.0 Flash-Lite则是谷歌迄今为止性价比最高的模型,针对大规模文本输出用例进行了成本优化,同时也在竞技场总榜中名列前茅。

这些模型的成本不断降低,甚至有网友戏称它们是“为爱发电”。

网友们对这些新模型赞不绝口,并积极体验其强大功能。一个典型的例子是使用Gemini 2.0 Pro编写脚本,以模拟一个在旋转的六边形内部弹跳的小球。这个脚本不仅需要考虑到重力和摩擦力的影响,还要确保小球能够真实地从旋转的墙壁上弹开。通过p5.js实现,最终效果令人惊艳:

此前,o3-mini和DeepSeek-R1在类似任务中的表现如下:

对比之下,Gemini 2.0 Pro的优势显而易见。

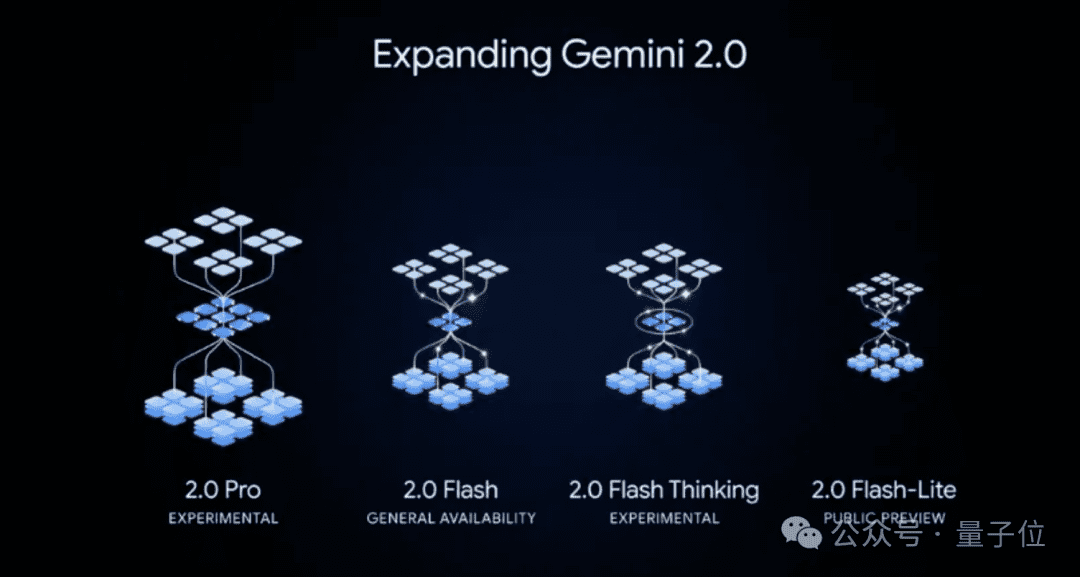

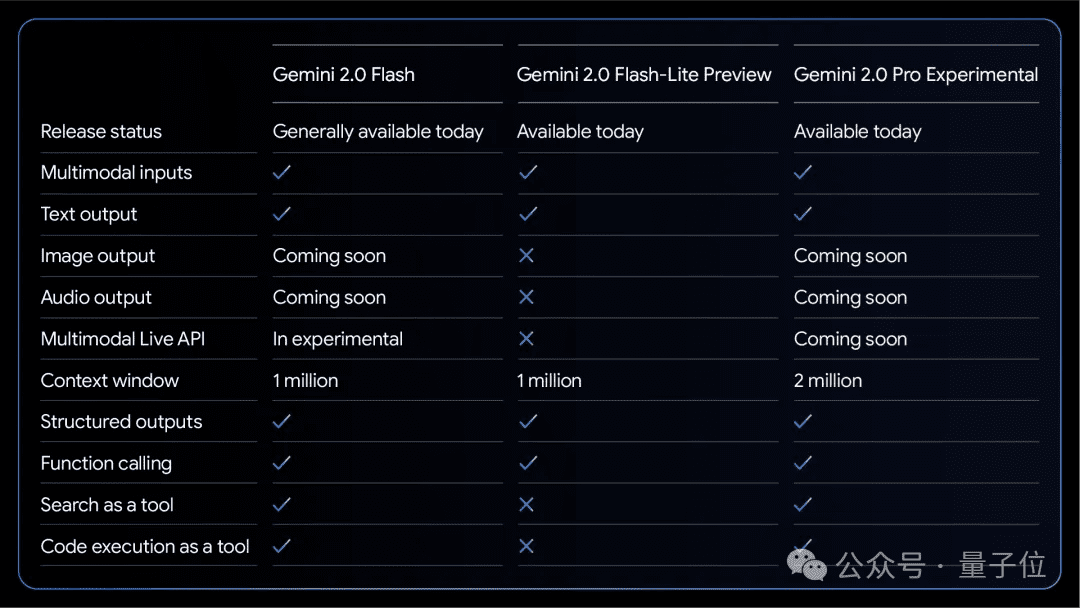

现在,所有用户都可以体验Gemini 2.0的强大功能。此次发布的Gemini 2.0家族包括以下三款模型:

- Gemini 2.0 Flash更新版:通用首选

- Gemini 2.0 Pro实验版:谷歌最强

- Gemini 2.0 Flash-Lite:性价比首选

这些模型均支持多模态输入,并生成文本输出。加上此前发布的Gemini 2.0 Flash Thinking,Gemini 2.0家族的全貌如下:

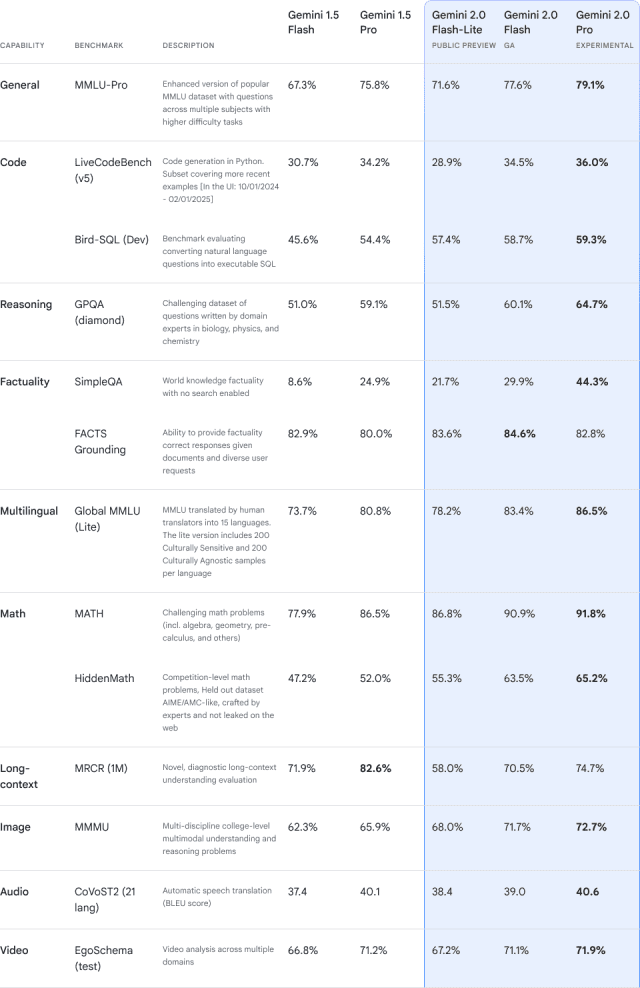

在通用性、代码能力、推理能力、多模态处理、数学运算、长文本处理、图像识别和音视频理解等方面,Gemini 2.0家族的三位新成员都表现出色。Gemini 2.0 Pro作为谷歌的新王者,在13项评测中获得了11个第一名。Gemini 2.0 Flash-Lite在Factuality的FACTS Grounding测试中以84.6%的成绩力压Gemini 2.0 Pro,令人印象深刻。

接下来,我们将详细介绍这三款新模型的具体情况。

Gemini 2.0 Pro实验版:谷歌的最强模型

Gemini 2.0 Pro是谷歌DeepMind迄今为止最强大的模型,但目前仅提供实验版本。它在编码性能和处理复杂提示方面表现出色,对世界知识的理解和推理能力也达到了谷歌的最高水平。Gemini 2.0 Pro实验版配备了200万tokens的超大上下文窗口,使其能够全面分析和理解大量信息,并具备调用谷歌搜索和代码执行等工具的能力。

目前,Gemini 2.0 Pro已在Google AI Studio和Vertex AI上提供给开发者使用。Gemini Advanced的用户也可以在PC端和移动设备端的模型下拉菜单中选择它进行使用。

新版Gemini 2.0 Flash:通用性之选

Gemini 2.0 Flash实验版在2024年谷歌I/O大会上首次亮相,现在已集成到谷歌的AI产品中,供所有用户使用。谷歌DeepMind的CTO Koray Kavukcuoglu表示,Gemini 2.0 Flash提供了全面的功能,适用于大规模处理高容量、高频率的任务。它具备100万tokens的长文本处理能力,支持对海量信息进行多模态推理。

目前,Gemini 2.0 Flash支持多模态输入和文本单模态输出,图像生成和文本转语音功能也正在开发中。未来几个月,将提供Gemini 2.0 Flash的多模态Live API。

使用方法:

- 普通用户:在Gemini App中试用

- 开发者:在Google AI Studio和Vertex AI中调用API

Gemini 2.0 Flash-Lite:性价比之选

为了在保持1.5 Flash成本和速度的同时提高模型质量,谷歌DeepMind推出了Gemini 2.0 Flash-Lite。该模型的速度和成本与Gemini 1.5 Flash相当,但在大多数基准测试中,其能力优于1.5 Flash。虽然是Lite版本,但其长文本处理能力并未缩减,与2.0 Flash一样,具备100万tokens的上下文窗口,并支持多模态输入。此外,它的价格非常实惠。

如果使用Gemini 2.0 Flash-Lite为大约4万张不同的照片生成描述简介,按照Google AI Studio的定价,总成本不超过1美元。

下图总结了Gemini 2.0家族三位新成员的现有能力:

DeepSeek带来的压力

模型一经发布,用户们便开始积极体验其强大功能。杰夫·迪恩率先分享了他使用Gemini 2.0 Pro编程制作的益智休闲类Boggle游戏。当被问及生成代码并解释所需的时间时,他坦率地回答:“18.9秒”。

他解释说,只需一个相对简单的提示词,Gemini 2.0 Pro就能编写出完整的代码,包括所有正确的数据结构和搜索算法,并能找到Boggle棋盘上的所有有效单词。

紧随其后,有网友分享了一个“狂野版贪吃蛇”游戏,该游戏由Google Gemini 2.0一次性生成,并带有编码器模式,其中100条蛇竞争狂舞。

小伙伴们可以直接上手体验这些新模型,并在评论区分享使用感受。

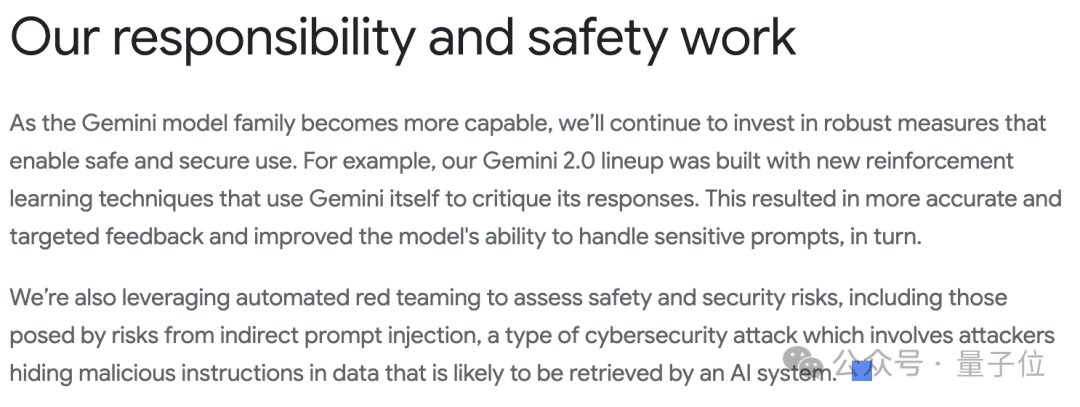

此外,谷歌DeepMind的CTO还在博客中提到,这些发布是谷歌为提升AI Agent能力所做的更广泛努力的一部分。Gemini 2.0系列采用新的强化学习技术构建,这使得模型能够获得更准确和更有针对性的输出反馈,同时提高了模型处理敏感提示的能力。

团队还利用自动化红队测试来评估系列模型的安全风险,包括间接提示注入等风险。这是一种网络安全攻击,攻击者会将恶意指令隐藏在可能被AI系统检索的数据中。

由此可见,有两个重点值得关注:

**首先,Gemini 2.0系列采用新的强化学习技术构建。**OpenAI是第一个明确表示正在探索这条路线的公司,后来的o3、o3-mini和DeepSeek-R1等国内推理模型都追随了这一路线,并在此基础上进行了优化和发展。Gemini 2.0家族中最先亮相的Gemini 2.0 Flash Thinking已经采用了这种方法,而这次CTO更是直接表明了这一点。

**其次,Gemini 2.0 Flash-Lite几乎被国内外所有媒体和网友视为DeepSeek-R1压力下的产物。**DeepSeek-R1以其低成本、高性能和强大的推理能力,迫使OpenAI紧急发布了o3-mini,并紧急加播让ChatGPT上新深度搜索,还促使谷歌DeepMind也开始走上“AI大模型拼多多”的路线。

目前,DeepSeek-R1模型的输入和输出成本如下:

- 输入成本:每百万Tokens的输入成本为4元。

- 输出成本:每百万Tokens的输出成本为16元。

Gemini 2.0 Flash-Lite的使用成本如下:

面对这种“神仙打架,凡人捡漏”的情况,我们只能期待AI技术的不断进步,为用户带来更多实惠和便利。