在人工智能飞速发展的今天,大型语言模型正以前所未有的速度改变着人机交互的方式。其中,阿里云推出的通义千问-7B(Qwen-7B)模型,凭借其70亿参数的强大规模,在众多模型中脱颖而出。Qwen-7B基于先进的Transformer架构,经过海量且多样化的数据训练,不仅包括了丰富的网络文本,还涵盖了专业书籍、代码等多种形式的内容,使其具备了强大的语言理解和生成能力。更进一步,Qwen-7B-Chat作为其衍生的AI助手模型,通过精准的对齐机制,在对话交互中展现出卓越的性能。本文将深入探讨如何利用Qwen-7B-Chat模型,并结合实际操作案例,帮助读者快速上手并掌握其应用。我们还将探讨在不同硬件环境下如何优化模型部署,以及如何通过多轮对话,体验Qwen-7B-Chat在智能对话领域的强大能力。

要充分利用Qwen-7B-Chat模型的强大功能,需要开发者准备以下环境配置:

- Python版本:3.8或更高版本

- PyTorch框架:推荐使用1.12版本或更新,2.0版本及以上将获得更佳体验

- CUDA:如果计划使用GPU加速或flash-attention库,建议安装CUDA 11.4或更高版本

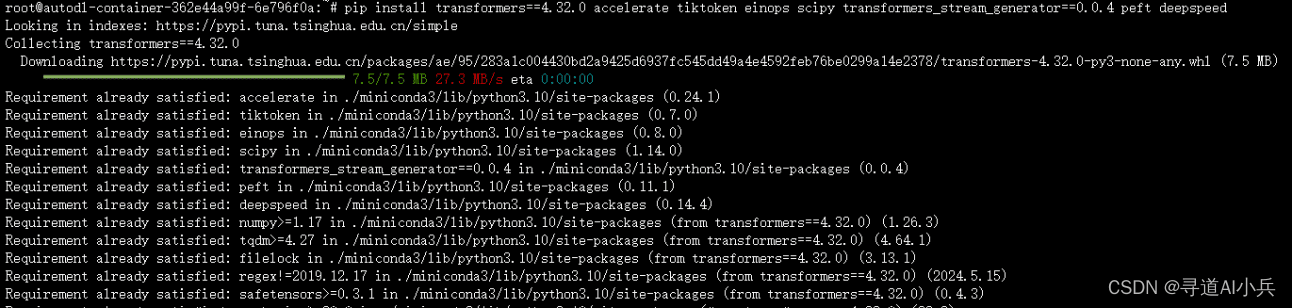

满足上述环境要求后,可以通过以下pip命令安装所需的依赖库:

pip install transformers==4.32.0 accelerate tiktoken einops scipy transformers_stream_generator==0.0.4 peft deepspeed

为了进一步提升运行效率和降低显存占用,强烈推荐安装flash-attention库,该库已全面支持flash attention 2技术。安装步骤如下:

git clone https://github.com/Dao-AILab/flash-attentioncd flash-attention && pip install .

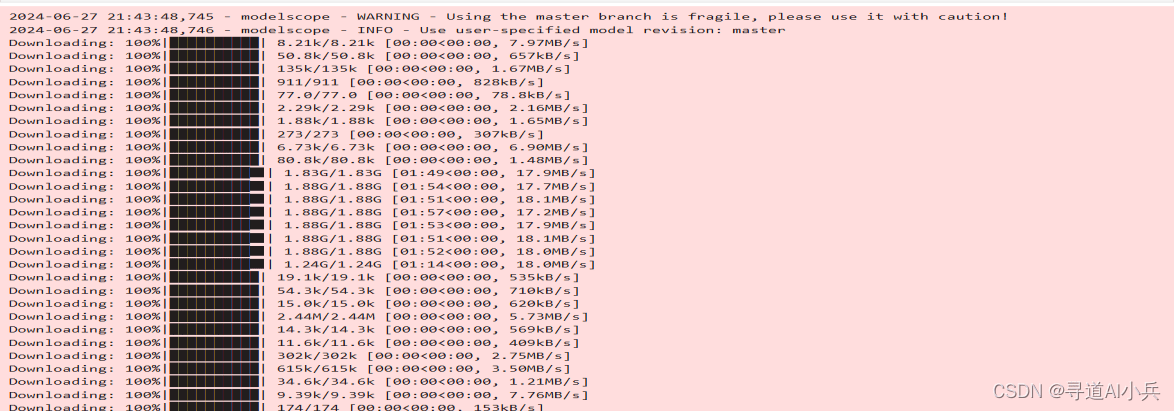

接下来,将模型Qwen-7B-Chat下载到本地,以便提高部署运行效率。可以使用以下代码片段:

import torch

from modelscope import snapshot_download

model_dir = snapshot_download(

'qwen/Qwen-7B-Chat',

cache_dir='/root/autodl-tmp',

revision='master'

)执行上述代码后,检查权重文件大小,对比查看是否有缺失。

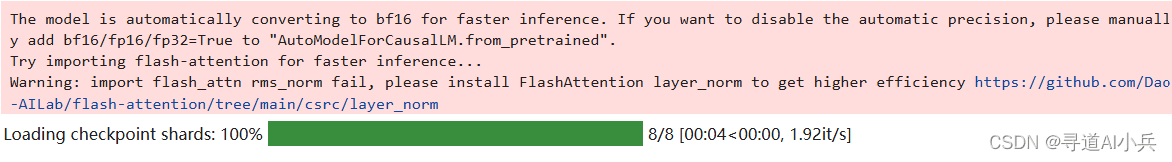

下载并安装所有必要的依赖和模型文件后,就可以开始使用Qwen-7B-Chat进行多轮对话交互了。以下示例将演示如何初始化Qwen-7B-Chat模型,并配置相应的生成参数,以适应不同的硬件环境和性能需求。

from transformers import AutoModelForCausalLM, AutoTokenizer

from transformers.generation import GenerationConfig

tokenizer = AutoTokenizer.from_pretrained("/root/autodl-tmp/qwen/Qwen-7B-Chat", trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained("/root/autodl-tmp/qwen/Qwen-7B-Chat", device_map="auto", trust_remote_code=True).eval()

完成模型和分词器的准备工作后,就可以开始进行对话了。以下是三轮对话示例,展示了Qwen-7B-Chat在不同场景下的应用。

第一轮对话:基础问候

response, history = model.chat(tokenizer, "你好", history=None)

print(response)输出:

你好!很高兴见到你。有什么我能帮助你的吗?第二轮对话:生成故事

response, history = model.chat(tokenizer, "给我讲一个年轻人奋斗创业最终取得成功的故事。", history=history)

print(response)输出:

故事的主角是一个叫做李明的年轻人,他从家乡的一家小公司开始,凭借自己的努力和勇气,逐渐成为了公司的负责人,并带领公司发展成为一家全球知名的科技公司。

一开始,李明只是一个小职员,但他并不满足于现状,他知道只有不断学习、不断进步才能在未来获得更多的机会。于是,他开始自学编程,并参加各种技术比赛,不断提升自己的技能。

当公司遇到困难时,李明并没有选择放弃,而是选择勇敢面对。他积极寻找解决方案,并提出了一些新的思路,帮助公司度过了难关。

经过几年的努力,李明最终成功地领导公司实现了快速发展,并将公司推向了全球市场的前列。他的故事告诉我们,只要我们有决心和勇气,就一定能够实现我们的梦想。第三轮对话:标题生成

response, history = model.chat(tokenizer, "给这个故事起一个标题", history=history)

print(response)输出:

《勇攀高峰:一个年轻人的奋斗创业史》通过以上对话示例,可以看出Qwen-7B-Chat模型不仅具备出色的对话能力,还在理解和生成连贯、相关且富有创意的内容方面表现出色。随着对话的深入,Qwen-7B-Chat展现出的智能和灵活性,将为用户带来深刻的交互体验。Qwen-7B-Chat模型的出现,无疑为人工智能领域注入了新的活力。

总的来说,Qwen-7B-Chat模型在智能对话领域展现了巨大的应用潜力。随着技术的不断进步和优化,Qwen-7B-Chat将在智能助手、客户服务、教育辅导等众多领域发挥关键作用,为各行各业带来创新性的解决方案。我们有理由相信,Qwen-7B-Chat将持续推动人机交互的边界,为用户带来更加智能、便捷和高效的体验。