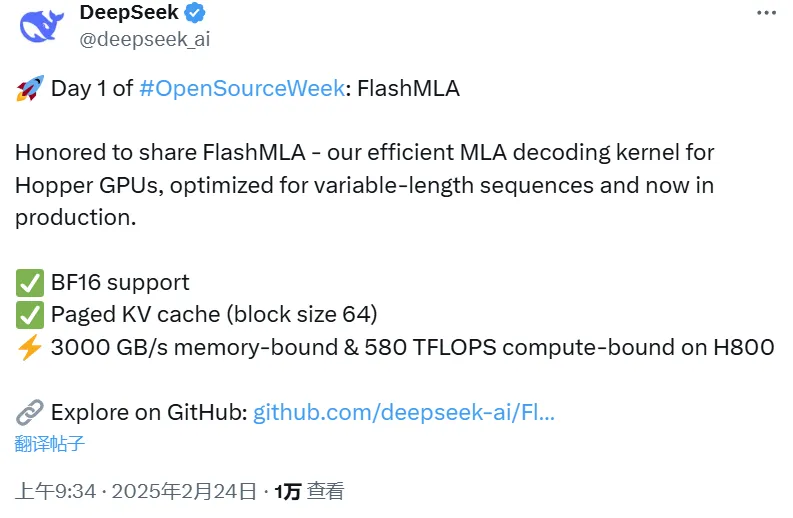

还记得上周DeepSeek那个神秘预告吗?说好的“开源周”,这不,大招说来就来!周一刚上班(美国那边刚下班😉),DeepSeek就扔出了一个重磅炸弹——FlashMLA!

什么是FlashMLA?为啥这么火?🔥

简单来说,FlashMLA就是DeepSeek为那些用Hopper GPU的朋友们量身定制的“加速神器”。它能让大模型在推理的时候跑得更快,更省资源。

具体点说,FlashMLA是个高效的MLA解码核。等等,MLA又是什么?这可是DeepSeek大模型的核心技术之一,能大幅减少推理时需要的KV Cache。说人话就是,以前推理大模型,又慢又费钱,现在有了MLA,速度上去了,成本下来了,爽歪歪!

这次DeepSeek直接把这核心技术的升级版都开源了,诚意满满!难怪项目上线才45分钟,GitHub上的Star数就蹭蹭蹭地往上涨,一下子就破了400,而且还在疯狂飙升中!

FlashMLA有多快?⚡️

DeepSeek官方说了,FlashMLA在H800 SXM5 GPU上,内存速度最高能飙到3000 GB/s,计算能力最高能到580 TFLOPS!这速度,简直了!

想体验一下“飞”一般的感觉?前提是你得有:

- Hopper GPU(这可是硬通货)

- CUDA 12.3及以上版本

- PyTorch 2.0及以上版本

安装和使用也很简单:

- 安装: 一行代码搞定

python setup.py install - 测试: 跑个基准测试看看效果

python tests/test_flash_mla.py - 使用: 几行代码就能集成到你的项目里

from flash_mla import get_mla_metadata, flash_mla_with_kvcache

tile_scheduler_metadata, num_splits = get_mla_metadata (cache_seqlens, s_q * h_q //h_kv, h_kv)

for i in range (num_layers):

...

o_i, lse_i = flash_mla_with_kvcache (

q_i, kvcache_i, block_table, cache_seqlens, dv,

tile_scheduler_metadata, num_splits, causal=True,

)

...开源社区炸锅了!🎉

FlashMLA一发布,整个开源社区都沸腾了!大家纷纷点赞,有人甚至开玩笑说:“DeepSeek这是要上天啊,第五天是不是要开源AGI了?”

DeepSeek:这才是真·OpenAI!

DeepSeek这次开源FlashMLA,不仅展示了强大的技术实力,更体现了开源精神。这波操作,必须给DeepSeek点个大大的赞!👍

DeepSeek本次开源FlashMLA项目,为大模型推理加速提供了新的解决方案,为广大使用Hopper GPU的研究者和开发者提供了便利。FlashMLA的高效性和便捷性,将进一步推动大模型技术的应用和发展。DeepSeek的开源精神,也为整个AI社区树立了榜样。