在当今的大规模模型训练领域,如何高效地利用计算资源、缩短训练时间并提升模型性能是关键挑战。DeepSeek 推出的 EPLB(Expert Parallelism Load Balancer)正是为了解决这一问题而生。EPLB 是一款专家并行负载均衡器,它通过创新的负载均衡策略和优化技术,显著提高了 GPU 资源的利用率和训练效率。本文将深入探讨 EPLB 的核心功能、技术原理、应用场景以及代码示例,帮助读者全面了解这款强大的工具。

EPLB的核心功能

EPLB 的设计目标是解决大规模模型训练中不同专家模型(Expert)负载不均的问题。其主要功能包括:

负载均衡:EPLB 能够根据专家(Experts)的负载估计值,动态调整专家的复制和分配策略,确保不同 GPU 之间的负载差异最小化。通过这种动态调整,EPLB 能够有效避免单个 GPU 过载,从而提高整体训练效率。

专家复制:基于冗余专家策略,EPLB 复制高负载专家,缓解负载不均衡的问题。这意味着,对于那些计算量大的专家,EPLB 会创建多个副本,并将这些副本分配到不同的 GPU 上,从而分担计算压力。

资源优化:EPLB 最大化利用 GPU 资源,减少因负载不均导致的性能瓶颈,提高模型训练效率。通过合理的负载均衡和专家分配,EPLB 能够确保每个 GPU 都能充分发挥其计算能力,避免资源浪费。

通信优化:EPLB 采用合理的专家放置策略,减少节点间通信开销,降低通信延迟。EPLB 尽量将同一组的专家放置在同一节点内,从而减少跨节点通信的需求,提高数据传输效率。

灵活的策略支持:EPLB 提供层次化负载均衡(Hierarchical Load Balancing)和全局负载均衡(Global Load Balancing)两种策略,适用于不同场景和阶段。这两种策略可以根据实际需求灵活切换,以达到最佳的负载均衡效果。

多层 MoE 模型支持:EPLB 适用于多层混合专家模型(MoE),处理复杂模型结构,支持灵活的专家分配和映射。这意味着,EPLB 不仅可以应用于简单的模型,还可以应用于复杂的、多层的 MoE 模型,具有广泛的适用性。

EPLB 的技术原理

EPLB 的核心技术原理主要包括以下几个方面:

冗余专家策略:在专家并行中,不同专家的负载可能因输入数据和模型结构而异。EPLB 引入冗余专家(复制高负载专家)来平衡负载。支持负载较高的专家被复制多次,分散到多个 GPU 上,避免单个 GPU 过载。

层次化负载均衡:将专家组均匀分配到不同节点,确保每个节点的负载大致相等。在每个节点内,进一步复制专家,将复制的专家分配到节点内的 GPU 上,确保节点内负载均衡。尽量将同一组的专家放置在同一节点内,减少跨节点通信开销。

全局负载均衡:在其他情况下(如节点数不能整除专家组数或需要更大规模的并行),采用全局策略:忽略专家组的限制,将专家全局复制分配到所有可用的 GPU 上。基于动态调整专家的复制数量和放置位置,确保全局负载均衡。

负载估计与动态调整:EPLB 依赖于专家负载的估计值来指导负载均衡策略。负载估计基于历史统计数据(如移动平均值)。根据负载估计值,动态调整专家的复制和分配策略,适应不同的训练阶段和数据分布。

专家映射与资源分配:基于 rebalance_experts 函数输出专家的复制和放置计划,将专家映射到具体的 GPU 上。输出的映射关系包括物理到逻辑(phy2log)和逻辑到物理(log2phy)的映射,及每个专家的复制数量(logcnt)。

EPLB 的核心模式

EPLB 提供了两种核心模式,以适应不同的应用场景:

层次化负载均衡模式(Hierarchical Load Balancing):在节点数能整除专家组数时,基于分层次的负载均衡策略,优化节点内和节点间的负载分配。

全局负载均衡模式(Global Load Balancing):在节点数不能整除专家组数或需要更大规模并行时,基于全局复制和分配专家,实现整体负载均衡。

EPLB 的代码演示示例

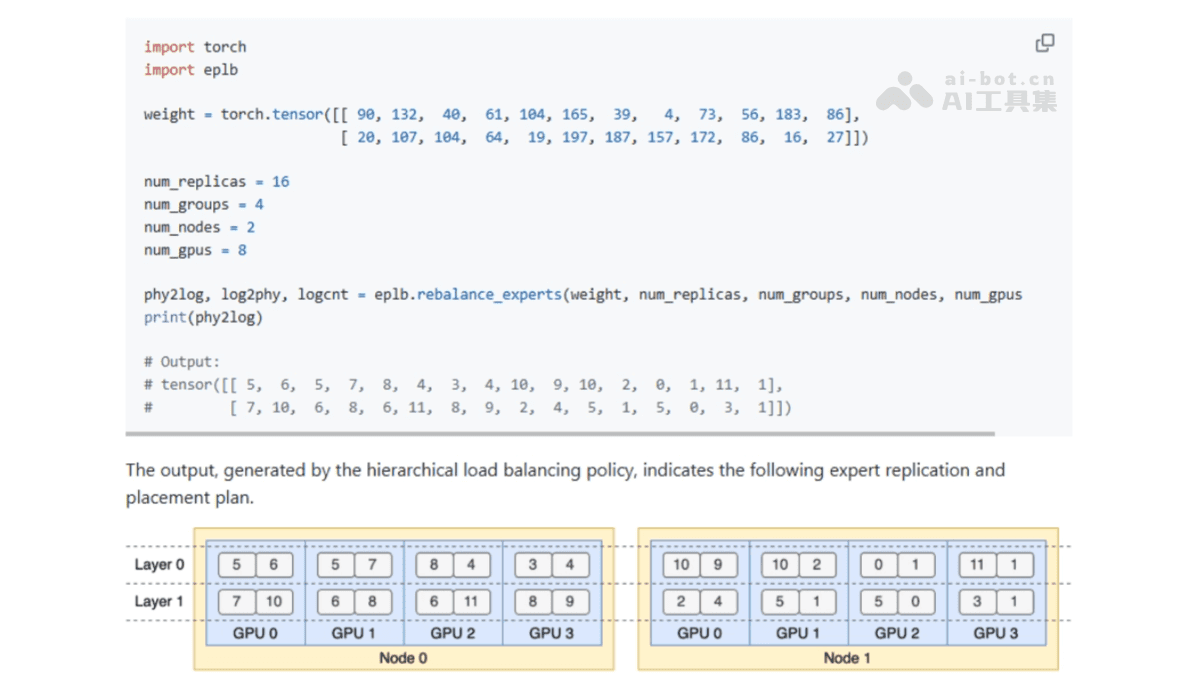

为了更好地理解 EPLB 的工作原理,我们提供一个两层 MoE 模型的示例,每层包含 12 个专家。每层引入 4 个冗余专家,总共 16 个副本放置在 2 个节点上,每个节点包含 4 个 GPU。

该代码演示了如何配置和使用 EPLB,以实现负载均衡。通过这个示例,用户可以直观地了解 EPLB 的各个组件是如何协同工作的。

EPLB 的应用场景

EPLB 具有广泛的应用前景,特别是在以下几个方面:

大规模分布式训练:适用于多节点、多 GPU 环境,基于灵活切换层次化或全局负载均衡模式,优化资源利用减少通信开销。

预填充阶段:在模型训练初期,基于层次化负载均衡减少跨节点通信,提高小规模并行效率。

解码阶段:在训练后期需要大规模并行时,用全局负载均衡动态调整负载,应对复杂任务。

异构硬件环境:当节点数与专家组数不匹配时,全局负载均衡模式可灵活适应异构配置,实现高效负载均衡。

动态负载变化:针对训练过程中负载的动态变化,结合层次化或全局负载均衡策略实时调整,确保训练过程的高效与稳定。

EPLB 的优势与价值

EPLB 作为 DeepSeek 推出的专家并行负载均衡器,具有显著的优势和价值:

提高资源利用率:通过动态负载均衡和专家复制,EPLB 能够确保每个 GPU 的负载均衡,从而最大限度地利用计算资源,避免资源浪费。

缩短训练时间:通过优化负载分配和减少通信开销,EPLB 能够显著缩短模型训练时间,提高训练效率。

提升模型性能:通过更高效的资源利用和更快的训练速度,EPLB 有助于提升模型的最终性能。

灵活适应不同场景:EPLB 提供层次化和全局两种负载均衡策略,可以根据不同的应用场景和硬件配置灵活切换,满足多样化的需求。

简化大规模模型训练:EPLB 简化了大规模模型训练的复杂性,使得用户可以更专注于模型的设计和优化,而无需过多关注底层的资源管理和负载均衡。

EPLB 未来展望

随着人工智能技术的不断发展,大规模模型训练的需求将持续增长。EPLB 作为一款高效的负载均衡器,将在未来的模型训练中发挥越来越重要的作用。未来,EPLB 可以进一步优化,例如:

更智能的负载预测:通过更精准的负载预测,EPLB 可以更及时地调整负载均衡策略,进一步提高资源利用率。

更广泛的硬件支持:扩展对更多类型硬件的支持,包括不同架构的 GPU 和其他加速器,以适应更广泛的应用场景。

自动化调优:实现自动化的参数调优,简化用户配置过程,提高易用性。

EPLB 的出现,为大规模模型训练带来了新的可能性,为 AI 技术的快速发展提供了有力的支持。通过不断优化和完善,EPLB 将会在未来的 AI 领域发挥更加重要的作用。

总结

EPLB 作为 DeepSeek 推出的专家并行负载均衡器,通过其强大的负载均衡、专家复制、资源优化和通信优化等功能,为大规模模型训练提供了高效的解决方案。无论是层次化负载均衡还是全局负载均衡,EPLB 都能灵活适应不同的场景和需求。通过本文的介绍,相信读者对 EPLB 有了更深入的了解。EPLB 的出现,将有助于推动 AI 技术的发展,为构建更强大、更智能的模型提供有力的支持。