在人工智能领域,多模态情感识别正成为一个备受关注的研究方向。近日,阿里通义实验室宣布开源其最新的R1-Omni模型,这一举措无疑为该领域注入了新的活力。R1-Omni模型巧妙地融合了强化学习与可验证奖励(RLVR)方法,旨在显著提升模型在多模态情感识别任务中的推理能力和泛化性能。这一突破性的进展,或将为情感识别技术带来质的飞跃。

R1-Omni模型的训练过程独具匠心,被划分为两个关键阶段。首先是冷启动阶段,研究团队采用了一个包含580条视频数据的精选组合数据集进行微调。这些数据来源于Explainable Multimodal Emotion Reasoning(EMER)数据集和HumanOmni数据集。冷启动阶段的主要目标是为模型奠定坚实的基础推理能力,确保其在进入RLVR阶段之前,已经具备了初步的多模态情感识别能力。这一策略能够有效地保障后续训练过程的平稳性、效率以及整体的稳定性。

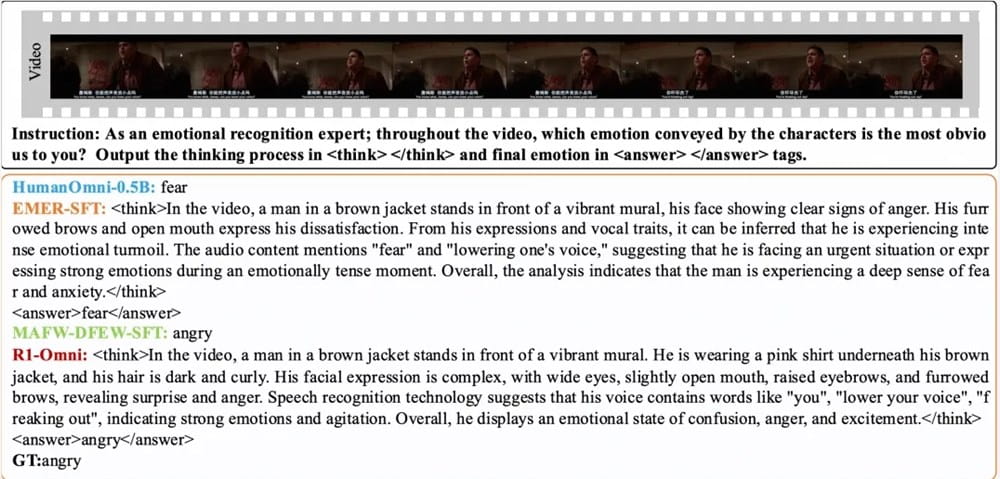

紧随其后的是RLVR阶段,模型将通过强化学习与可验证奖励机制得到进一步的优化。在这个阶段,策略模型和奖励函数扮演着至关重要的角色。策略模型负责处理由视频帧和音频流组成的多模态输入数据,并生成带有详细推理过程的候选响应。这一过程充分展示了模型如何有效地整合视觉和听觉信息,从而得出最终的预测结果。而奖励函数的设计则受到了DeepSeek R1的启发,它由精确率奖励和格式奖励两部分组成,共同构成最终的奖励信号。这样的设计既能够鼓励模型生成准确的预测,又能够保证输出结果的结构化和符合预设的格式要求。

为了全面评估R1-Omni模型的性能,研究团队进行了一系列严谨的实验。实验结果显示,在同分布测试集DFEW和MAFW上,R1-Omni相较于原始基线模型,性能平均提升超过35%。更令人瞩目的是,相较于有监督微调(SFT)模型,R1-Omni在未加权平均召回率(UAR)上实现了高达10%以上的提升。此外,在不同分布测试集RAVDESS上,R1-Omni的加权平均召回率(WAR)和UAR均提升超过13%,充分展现出其卓越的泛化能力。

除了性能上的显著提升,R1-Omni还具有显著的透明性优势。借助RLVR方法,音频和视频信息在模型中的作用变得更加清晰可见。模型能够明确展示各种模态信息对于特定情绪判断的关键作用,这为理解模型的决策过程和未来的研究方向提供了重要的参考依据。通过深入剖析模型内部的运作机制,研究人员可以更好地理解多模态情感识别的本质,并为未来的模型改进提供有力的指导。

R1-Omni模型的实际应用与影响

R1-Omni模型的开源,无疑将对多模态情感识别领域产生深远的影响。其强大的性能和出色的泛化能力,使其在诸多实际应用场景中具备巨大的潜力。

智能客服:在智能客服领域,R1-Omni模型可以帮助客服系统更准确地理解用户的情绪状态,从而提供更加个性化和贴心的服务。通过分析用户的语音、语调以及面部表情,R1-Omni模型可以判断用户是高兴、愤怒还是沮丧,并据此调整回复策略,提升用户满意度。

在线教育:在在线教育领域,R1-Omni模型可以用于监测学生的学习状态和情绪反应。通过分析学生的面部表情和语音语调,教师可以及时发现学生在学习过程中遇到的困难和情绪波动,并给予及时的指导和帮助,从而提升学生的学习效果。

医疗健康:在医疗健康领域,R1-Omni模型可以用于辅助医生进行精神疾病的诊断和治疗。通过分析患者的言语、行为以及面部表情,医生可以更准确地判断患者的情绪状态和精神状况,从而制定更加有效的治疗方案。

人机交互:在人机交互领域,R1-Omni模型可以提升人机交互的自然性和流畅性。通过理解用户的情绪状态,机器可以更加智能地回应用户的需求,从而创造更加友好和高效的人机交互体验。

R1-Omni模型的局限性与未来发展方向

尽管R1-Omni模型在多模态情感识别领域取得了显著的进展,但仍然存在一些局限性。例如,模型对于复杂情绪的识别能力仍有待提高,对于不同文化背景下的情绪表达差异的适应性也需要进一步加强。此外,模型在处理噪声数据和非典型情绪表达时的鲁棒性也需要进一步提升。

未来,R1-Omni模型的发展方向主要集中在以下几个方面:

提升模型对于复杂情绪的识别能力:通过引入更加精细的情绪分类体系和更加复杂的模型结构,提升模型对于复杂情绪的识别能力。

增强模型对于不同文化背景的适应性:通过引入多文化背景的数据进行训练,并采用跨文化的情绪识别技术,增强模型对于不同文化背景下的情绪表达差异的适应性。

提升模型在处理噪声数据时的鲁棒性:通过引入数据增强技术和噪声消除技术,提升模型在处理噪声数据时的鲁棒性。

探索更加高效的强化学习算法:通过探索更加高效的强化学习算法,提升模型的训练效率和性能。

研究可解释性更强的模型结构:通过研究可解释性更强的模型结构,提升模型决策过程的可解释性,为用户提供更加透明和可信赖的情感识别服务。

多模态情感识别领域的发展趋势

随着人工智能技术的不断发展,多模态情感识别领域正迎来前所未有的发展机遇。未来,该领域的发展趋势主要体现在以下几个方面:

多模态数据融合技术的不断创新:多模态数据融合技术是多模态情感识别的核心。未来,研究人员将继续探索更加高效和鲁棒的多模态数据融合方法,以提升模型的情感识别能力。

深度学习技术的广泛应用:深度学习技术在多模态情感识别领域展现出强大的潜力。未来,研究人员将继续探索更加先进的深度学习模型,以提升模型的情感识别性能。

跨领域应用的不断拓展:多模态情感识别技术将在越来越多的领域得到应用,例如智能客服、在线教育、医疗健康、人机交互等。未来,研究人员将不断拓展多模态情感识别技术的应用领域,为人类生活带来更多的便利。

伦理和社会问题的日益重视:随着多模态情感识别技术的广泛应用,伦理和社会问题也日益凸显。未来,研究人员将更加重视伦理和社会问题,制定更加完善的伦理规范,以确保多模态情感识别技术的健康发展。

阿里通义开源R1-Omni模型是多模态情感识别领域的一个重要里程碑。我们有理由相信,随着技术的不断进步和应用的不断拓展,多模态情感识别技术将在未来发挥更加重要的作用,为人类社会带来更多的福祉。

通过对R1-Omni模型的深入分析,我们可以看到,人工智能在情感理解方面的进步正在加速。未来的AI系统将不仅能够理解我们的语言,还能感知我们的情绪,从而实现更加自然和高效的人机交互。这一趋势将深刻地改变我们与技术互动的方式,并为各行各业带来创新和变革。