开源大模型领域再添猛将

近日,谷歌宣布开源其Gemma 3模型家族,为开源大模型领域注入了一股强大的力量。Gemma 3是基于Gemini技术开发的轻量级模型家族,具备多模态能力,支持多种参数规模,并在多项任务中表现出色。

🌟 Gemma 3:轻量级、多模态、性能强劲

Gemma 3模型家族具有以下显著特点:

- 轻量级设计: Gemma模型注重高效性,能够在资源受限的设备上运行,适合移动端、嵌入式设备或边缘计算等场景。

- 多模态能力: Gemma 3模型不仅能处理文本,还能处理图像,使其在更广泛的应用场景中发挥作用。

- 大上下文窗口: 128K的上下文窗口意味着模型能够处理更长的输入序列,适合需要理解长文本或复杂上下文的场景。

- 多语言支持: 支持超过140种语言,具备全球化的应用潜力。

- 多种参数规模: 提供1B、4B、12B和27B四种参数规模,用户可以根据任务需求和硬件条件选择合适的模型。

- 任务表现优异: 在问答、摘要和推理等任务中表现出色,展现了强大的语言理解和生成能力。

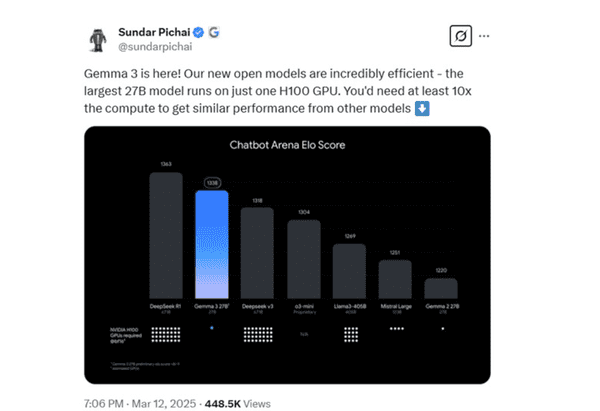

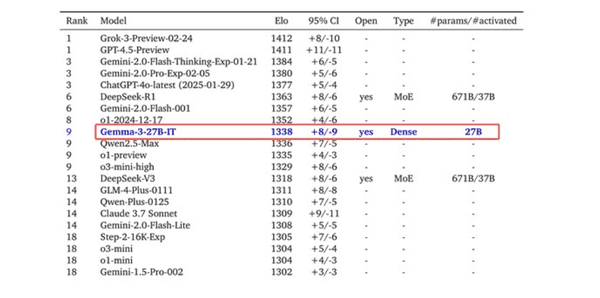

🚀 Gemma 3:性能比肩DeepSeek 67B

令人惊讶的是,Gemma 3在某些方面的性能甚至可以对标DeepSeek 67B的R1和V3模型。这充分展示了Gemma 3在轻量级模型中的强大竞争力。

🌐 Gemma 3:广泛的应用场景

Gemma 3模型家族的应用场景非常广泛,包括:

- 移动端应用: 由于模型轻量,适合集成到手机或平板等设备中,提供本地化的AI功能。

- 边缘计算: 在资源有限的边缘设备上运行,支持实时处理和分析。

- 多语言服务: 支持多种语言,适合全球化企业的多语言客服、翻译等需求。

- 复杂任务处理: 大上下文窗口和多模态能力使其适合处理复杂的多模态任务,如文档分析、图像描述生成等。

📊 Gemma 3:不同模型解读

Gemma模型家族包含四种不同规模的模型,分别是1B、4B、12B和27B。以下是这些模型的详细解读:

1B参数模型

- 类型: 文本模型

- 上下文窗口: 32K

- 运行命令:

ollama run gemma3:1b - 特点: 轻量级设计,适合资源有限的设备;专注于文本处理任务;上下文窗口较小,适合处理较短文本或简单任务。

- 适用场景: 移动端应用、嵌入式设备或边缘计算;需要快速响应的轻量级文本处理任务。

4B参数模型

- 类型: 多模态模型(支持文本和图像)

- 上下文窗口: 128K

- 运行命令:

ollama run gemma3:4b - 特点: 支持多模态输入;较大的上下文窗口,适合处理长文本或复杂任务;在保持高效性的同时,提供更强的推理和生成能力。

- 适用场景: 多模态任务,如图像描述生成、文档分析;需要处理长文本或复杂上下文的场景。

12B参数模型

- 类型: 多模态模型(支持文本和图像)

- 上下文窗口: 128K

- 运行命令:

ollama run gemma3:12b - 特点: 更强的推理和生成能力,适合更复杂的任务;支持多模态输入和长上下文窗口;在性能和资源消耗之间取得平衡。

- 适用场景: 需要高精度和复杂推理的任务,如高级问答、多模态分析;适合中等规模的部署场景。

27B参数模型

- 类型: 多模态模型(支持文本和图像)

- 上下文窗口: 128K

- 运行命令:

ollama run gemma3:27b - 特点: 最大规模的模型,提供最强的推理和生成能力;支持多模态输入和长上下文窗口;适合需要最高精度的复杂任务。

- 适用场景: 需要最高性能的任务,如复杂推理、多模态生成;适合大规模部署或高性能计算场景。

Gemma 3,开源AI的新篇章

谷歌Gemma 3的开源,为开发者和研究人员提供了一个强大而灵活的AI工具。其轻量级设计、多模态能力、大上下文窗口、多语言支持以及多种参数规模,使其能够适应各种不同的应用场景和需求。Gemma 3的出现,无疑将推动开源AI技术的进一步发展,为AI的普及和应用带来更多可能性。