在人工智能领域,大型语言模型(LLM)一直是研究和应用的热点。然而,随着模型规模的不断扩大,计算资源的需求也日益增长,这给许多开发者和研究人员带来了挑战。近日,微软研究院推出了一款名为BitNet b1.58 2B4T的开源大型语言模型,以其独特的低精度架构和极低的内存占用,为解决这一问题提供了新的思路。

BitNet b1.58 2B4T:技术特点

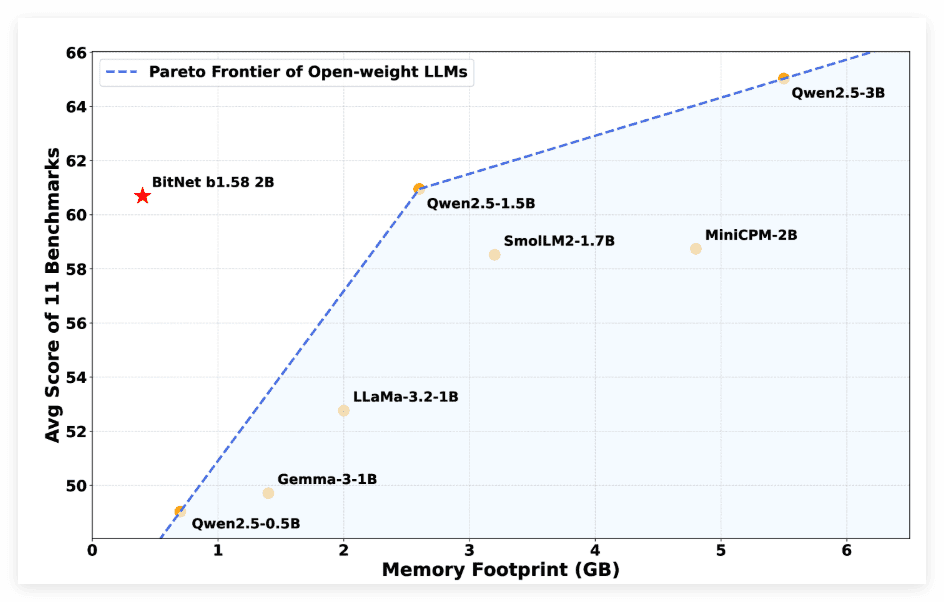

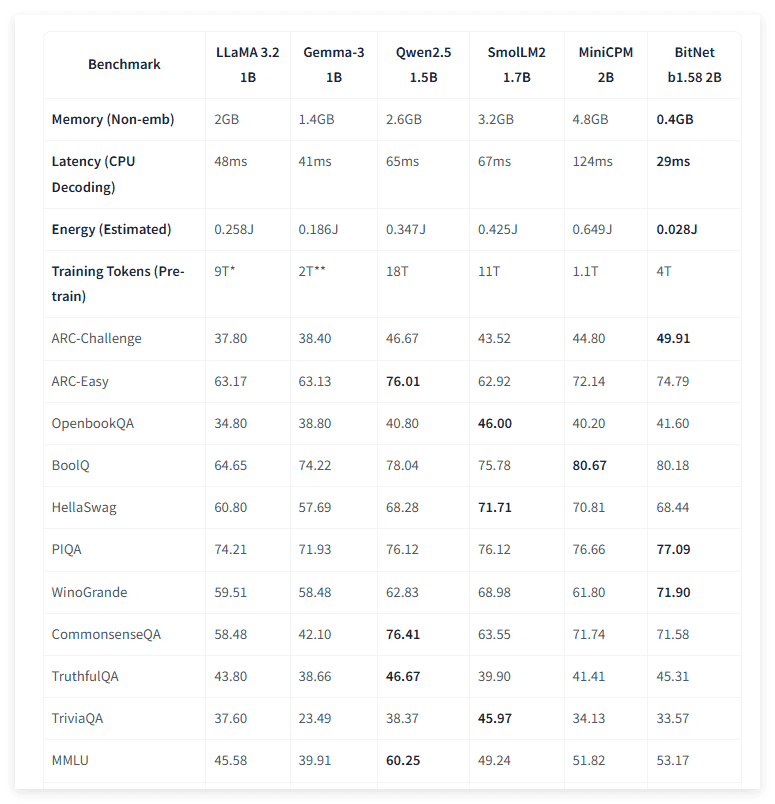

BitNet b1.58 2B4T模型拥有20亿参数,但其最大的亮点在于采用了1.58位低精度架构进行原生训练。与传统的训练后量化方法不同,BitNet从一开始就以低精度进行训练,从而显著降低了计算资源的需求。根据微软的介绍,该模型在非嵌入内存占用方面仅为0.4GB,远低于其他同类产品。这一特性使得BitNet在资源受限的环境中也能高效运行,为AI应用的普及提供了可能。

创新的架构设计

BitNet的高效性能得益于其创新的架构设计。该模型放弃了传统的16位数值,而是采用了定制的BitLinear层,将权重限制为-1、0和+1三种状态,形成了三值系统。这意味着每个权重仅需约1.58位的信息存储。此外,层间的激活值则采用8位整数进行量化,从而形成了W1.58A8的配置。这种低精度设计在保证模型性能的同时,大大降低了内存占用和计算复杂度。

除了低精度设计,微软还对Transformer架构进行了调整,引入了平方ReLU激活函数、标准旋转位置嵌入(RoPE)和subln归一化,以确保低位训练的稳定性。这些技术手段共同作用,使得BitNet能够在低精度下实现高性能。

模型训练过程

在开发过程中,BitNet经历了三个阶段:

- 预训练:以4万亿token的网络数据、代码和合成数学数据集进行预训练,使模型具备初步的语言理解和生成能力。

- 监督微调:通过公开及合成指令数据集进行监督微调,使模型能够更好地遵循指令,完成特定任务。

- 直接偏好优化(DPO):采用直接偏好优化(DPO)方法,利用UltraFeedback等数据集提升模型的对话能力和安全性。

通过这三个阶段的训练,BitNet不仅具备了强大的语言能力,还具备了良好的对话能力和安全性。

BitNet的性能表现

微软的测试结果显示,BitNet在GSM8K(数学)和PIQA(物理常识)等基准测试中的表现非常出色,整体性能与主流的1B-2B参数全精度模型相当,同时在能耗(每token消耗0.028焦耳)和CPU解码延迟(29毫秒)上具备明显的优势。这些数据表明,BitNet在保持高性能的同时,还具有更低的能耗和更快的速度,这使得它在实际应用中更具优势。

案例分析

为了更直观地了解BitNet的性能,我们可以将其与其他模型进行对比。例如,与Gemma-31B相比,BitNet的内存占用仅为其约1/3,但性能却与之相当。与MiniCPM2B相比,BitNet的内存占用更是大幅降低,仅为其约1/12。这表明BitNet在资源利用率方面具有显著优势。

此外,BitNet在能耗和速度方面的优势也使其在移动设备和边缘计算等场景中具有广泛的应用前景。例如,可以将BitNet部署在手机或平板电脑上,实现本地化的AI应用,而无需依赖云端服务器。这不仅可以提高应用的响应速度,还可以保护用户数据的隐私。

BitNet的局限性与未来发展

尽管BitNet展现出巨大的潜力,但其高效性依赖于微软提供的专用C++框架bitnet.cpp。常见的工具如Hugging Face transformers库无法完全体现其速度与能耗的优势。这意味着,如果开发者想要充分利用BitNet的优势,需要使用微软提供的专用框架。

未来发展方向

微软未来还计划优化GPU和NPU的支持,扩展上下文窗口至4096token,并探索更大规模的模型及多语言功能。这些改进将进一步提升BitNet的性能和适用性,使其能够应对更复杂的任务和更广泛的应用场景。此外,微软还计划将BitNet推广到更多的平台和框架中,使其能够被更广泛的开发者所使用。

BitNet的开源与应用

现如今,BitNet b1.58 2B4T 已经以 MIT 许可证在 Hugging Face 平台发布,供广大开发者和研究人员进行测试和应用。这一举措将加速BitNet的普及和应用,促进人工智能领域的创新。

应用场景展望

BitNet的低内存占用和高性能使其在以下领域具有广泛的应用前景:

- 移动设备:在手机、平板电脑等移动设备上部署BitNet,实现本地化的AI应用。

- 边缘计算:在边缘服务器上部署BitNet,实现快速响应和数据隐私保护。

- 嵌入式系统:在嵌入式系统中部署BitNet,实现智能控制和自动化。

- 教育领域:为学生提供低成本的AI学习工具,促进AI教育的普及。

- 科研领域:为研究人员提供高效的AI研究平台,加速AI技术的创新。

结论

微软BitNet b1.58 2B4T语言模型以其低精度架构和极低的内存占用,为解决大型语言模型计算资源需求问题提供了新的思路。虽然目前其高效性依赖于微软提供的专用框架,但随着微软不断优化和推广,BitNet有望在未来的人工智能领域发挥更大的作用。

BitNet的出现,不仅降低了AI应用的门槛,也为AI技术的创新提供了新的动力。我们有理由相信,在BitNet等低资源AI技术的推动下,人工智能将更加普及,为人类社会带来更多的福祉。