Kimi-Audio:Moonshot AI 开源的音频基础模型深度解析

在人工智能领域,音频处理一直是一个备受关注的研究方向。近日,Moonshot AI 开源了其音频基础模型 Kimi-Audio,引起了业界的广泛关注。Kimi-Audio 专注于音频理解、生成和对话任务,并在超过 1300 万小时的多样化音频数据上进行了预训练,展现出强大的音频推理和语言理解能力。本文将对 Kimi-Audio 的技术原理、功能特性、性能表现以及应用场景进行深入分析,以期为相关领域的研究者和开发者提供有价值的参考。

Kimi-Audio 的核心功能

Kimi-Audio 作为一个综合性的音频基础模型,具备多种强大的功能,涵盖了音频处理的多个方面:

语音识别(ASR):Kimi-Audio 能够将语音信号精确地转换为文本内容,并且支持多种语言和方言。这使得 Kimi-Audio 在语音搜索、语音输入、会议记录等场景中具有广泛的应用前景。

语音情感识别(SER):该模型能够分析语音中的情感信息,准确判断说话者的情绪状态,例如高兴、悲伤、愤怒等。情感识别技术在客户服务、心理咨询、情感计算等领域具有重要的应用价值。

声音事件/场景分类(SEC/ASC):Kimi-Audio 能够识别和分类环境中的各种声音事件,例如汽车喇叭声、狗叫声、雨声等,或者对场景进行分类,如办公室、街道、森林等。这一功能在智能监控、智能家居、环境感知等领域具有广泛的应用。

音频字幕生成(AAC):Kimi-Audio 可以根据音频内容自动生成字幕,帮助听力障碍者更好地理解音频信息。这项技术在视频制作、在线教育、无障碍交流等领域具有重要的社会意义。

音频问答(AQA):该模型能够根据用户提出的问题,生成相应的音频回答。这在智能客服、语音助手、知识问答等场景中具有广泛的应用。

端到端语音对话:Kimi-Audio 支持生成自然流畅的语音对话内容,使得人机交互更加自然和高效。这项技术在智能音箱、虚拟助手、聊天机器人等领域具有重要的应用价值。

多轮对话管理:Kimi-Audio 能够处理复杂的多轮对话任务,理解上下文信息并生成连贯的语音回应。这使得人机交互更加深入和智能化。

语音合成(TTS):该模型能够将文本内容转换为自然流畅的语音,并且支持多种音色和语调选择。语音合成技术在语音播报、语音导航、语音助手等领域具有广泛的应用。

音频内容分析:Kimi-Audio 能够对音频中的语义、情感、事件等进行综合分析,提取关键信息。这在舆情分析、市场调研、内容审核等领域具有重要的应用价值。

音频质量评估:Kimi-Audio 能够分析音频的清晰度、噪声水平等,为音频处理提供参考。这项技术在音频修复、音频优化、音频质量控制等领域具有重要的应用价值。

Kimi-Audio 的技术原理剖析

Kimi-Audio 之所以能够实现上述强大的功能,离不开其独特的技术原理:

混合音频输入:Kimi-Audio 采用混合音频输入方式,将输入音频分为两部分:离散语义标记和连续声学特征。

- 离散语义标记:通过向量量化技术,将音频转换为离散的语义标记,频率为 12.5Hz。这种离散表示能够有效地捕捉音频中的语义信息,并且降低计算复杂度。

- 连续声学特征:使用 Whisper 编码器提取连续的声学特征,并将其降采样到 12.5Hz。连续声学特征能够保留音频的细节信息,有助于提高模型的性能。

这种混合输入方式结合了离散语义和连续声学信息,使得模型能够更全面地理解和处理音频内容。

基于 LLM 的核心架构:Kimi-Audio 的核心是一个基于 Transformer 的语言模型(LLM),初始化来源于预训练的文本 LLM(如 Qwen 2.5 7B)。这种基于 LLM 的架构使得 Kimi-Audio 能够充分利用预训练语言模型的知识,提高模型的泛化能力和性能。

分块流式解码:Kimi-Audio 采用基于流匹配的分块流式解码器,支持低延迟音频生成。通过分块处理音频数据,模型能够在生成过程中实时输出音频,显著降低延迟。同时,该解码器还支持前瞻机制,进一步优化了音频生成的流畅性和连贯性。

大规模预训练:Kimi-Audio 在超过 1300 万小时的多样化音频数据(包括语音、音乐和各种声音)上进行了预训练。大规模预训练是提高模型性能的关键因素之一,能够使模型具备强大的音频推理和语言理解能力,从而处理多种复杂的音频任务,如语音识别、音频问答、情感识别等。

流匹配模型:Kimi-Audio 使用流匹配模型将离散标记转换为连续的音频信号。流匹配模型能够有效地将离散语义信息转换为连续的音频波形,从而实现高质量的音频生成。

声码器(BigVGAN):Kimi-Audio 使用声码器(BigVGAN)生成高质量的音频波形,确保了生成音频的自然度和流畅性。声码器是音频生成流程中的重要组成部分,能够将模型的输出转换为可听的音频信号。

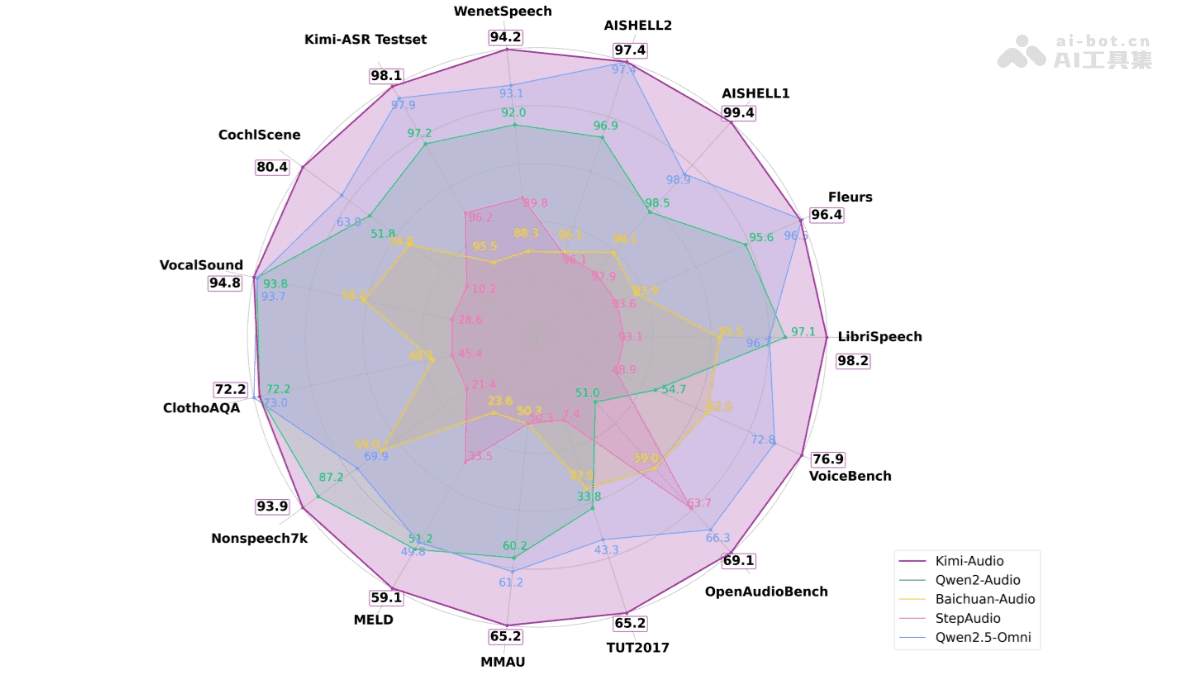

Kimi-Audio 的卓越性能

Kimi-Audio 在多个音频处理任务中都展现出了卓越的性能:

语音识别(ASR):在 LibriSpeech 测试集上,Kimi-Audio 的词错误率(WER)分别达到了 1.28%(test-clean)和 2.42%(test-other),显著低于其他模型。在 AISHELL-1 数据集上,其 WER 仅为 0.60%,表现优异。这些数据表明,Kimi-Audio 在语音识别方面具有很高的准确性和鲁棒性。

音频理解:在音频理解任务中,Kimi-Audio 在多个数据集上取得了接近或超过 SOTA 的结果。例如,在 ClothoAQA 数据集上,其测试集性能达到了 73.18%;在 VocalSound 数据集上,准确率达到了 94.85%。这些结果表明,Kimi-Audio 能够有效地理解音频内容,并从中提取有用的信息。

音频问答(AQA):在音频问答任务中,Kimi-Audio 在 ClothoAQA 数据集的开发集上达到了 73.18% 的准确率,显示出其在理解和生成音频问答内容方面的强大能力。这表明,Kimi-Audio 能够根据用户提出的问题,生成准确且有意义的音频回答。

音频对话:在语音对话任务中,Kimi-Audio 在多个基准测试中也表现出色。例如,在 VoiceBench 的 AlpacaEval 数据集上,其性能达到了 75.73%,在语音对话的流畅性和连贯性方面表现出色。这表明,Kimi-Audio 能够进行自然流畅的语音对话,并且能够理解上下文信息。

音频生成:Kimi-Audio 在非语音音频生成方面表现出色,在 Nonspeech7k 数据集上,准确率达到了 93.93%,显示出其在生成高质量音频内容方面的能力。这表明,Kimi-Audio 能够生成各种类型的音频内容,例如音乐、环境声音等。

Kimi-Audio 的广泛应用场景

Kimi-Audio 作为一个通用的音频基础模型,具有广泛的应用场景:

智能语音助手:Kimi-Audio 可以用于开发智能语音助手,支持语音识别、语音合成和多轮对话功能。它能够理解用户的语音指令,并生成自然流畅的语音回应,从而实现更加智能和便捷的人机交互。

语音识别与转录:Kimi-Audio 能够将语音信号高效地转换为文本内容,并且支持多种语言和方言。这使得它适用于会议记录、语音笔记、实时翻译等场景,可以大大提高工作效率。

音频内容生成:Kimi-Audio 可以生成高质量的音频内容,包括语音合成(TTS)、音频字幕生成(AAC)和音频问答(AQA)。它可以根据文本内容生成自然流畅的语音,也可以根据问题生成音频回答,适用于有声读物、视频字幕生成和智能客服等领域。

情感分析与语音情感识别:Kimi-Audio 能够分析语音中的情感信息,判断说话者的情绪状态,例如高兴、悲伤、愤怒等。这使得它在情感计算、心理咨询、客户服务等领域具有重要的应用价值。

教育与学习:Kimi-Audio 在教育领域有多种应用,例如英语口语陪练、语言学习辅助等。它可以通过语音交互帮助用户练习发音、纠正语法错误,并提供实时反馈,从而提高学习效果。

总而言之,Kimi-Audio 的开源为音频处理领域注入了新的活力。其强大的功能、卓越的性能和广泛的应用场景,使其成为研究者和开发者们值得关注的重要工具。