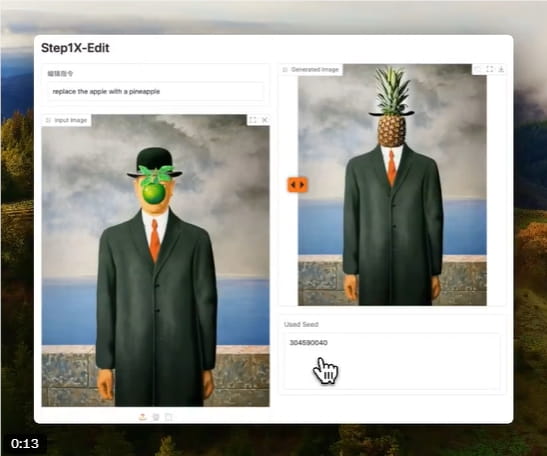

在人工智能领域,图像编辑技术一直备受关注。近日,一款名为Step1X-Edit的开源图像编辑框架登陆Hugging Face社区,引起了广泛关注。这款工具巧妙地融合了多模态大语言模型Qwen-VL与扩散变换器DiT,用户仅需通过简单的自然语言指令,即可实现高精度的图像编辑。其卓越性能直逼GPT-4o和Gemini2Flash等顶尖闭源模型。同时发布的GEdit-Bench基准测试,为衡量真实场景下的图像编辑效果提供了更全面的标准。更令人振奋的是,Step1X-Edit遵循Apache2.0许可证,完全开放源代码,所有技术细节均已在Hugging Face与arXiv上公开,为图像编辑领域带来了一场开源革命。

那么,Step1X-Edit究竟有何独特之处?它又将如何改变我们对图像编辑的认知?

Step1X-Edit的核心魅力

Step1X-Edit的核心在于将Qwen-VL的“智慧大脑”与DiT的“精湛画技”无缝结合,为用户带来前所未有的灵活性与精准度。用户无需再与复杂的工具栏搏斗,只需像与人对话般下达指令,AI编辑大师便能心领神会。例如,将照片的背景替换为璀璨星空,或调整图中人物的服装风格。Qwen-VL负责深度理解用户意图,生成精确的编辑指令嵌入;DiT网络则作为技艺高超的“数字画师”,解码这些指令,在高分辨率下细腻地重绘图像,同时小心翼翼地保留原图的纹理、光影乃至色彩的和谐统一,确保每一次编辑都如魔法般自然。

Step1X-Edit并非只能应对一两种简单任务,而是覆盖了背景替换、对象移除、风格迁移、局部微调等11种主流编辑类型,几乎能满足用户对图像编辑的各种奇思妙想。更重要的是,这一切都是免费且开放的,配合Hugging Face模型卡和GitHub上的完整代码,无论是快速部署试用,还是进行二次开发,都变得触手可及。GEdit-Bench的诞生更是基于海量真实用户指令构建,覆盖多样化编辑场景,为整个行业提供了一把更贴近现实应用的度量衡。社区的初步测试显示,Step1X-Edit仅需约22秒(1024x1024分辨率),就能将一张白天的城市街景照片巧妙地转化为夜景,不仅建筑细节得以保留,连迷人的光晕效果也处理得恰到好处,效率与效果兼备。

技术奥秘:多模态LLM与扩散模型的协同创新

Step1X-Edit的成功源于多模态LLM与扩散模型的协同创新。Qwen-VL(基于Qwen2-VL-7B-Instruct版本)凭借其独特的Multimodal Rotary Position Embedding (M-ROPE)技术,能够同时理解图像和文本输入,将复杂的编辑指令转化为富有语义的编辑嵌入,这是实现精准指令遵循的关键。而DiT作为图像生成的引擎,则负责将这些抽象的指令转化为像素级的真实图像,并在生成速度与质量之间取得了优异的平衡。

为了锻造出如此强大的能力,研发团队构建了一个包含超过100万组高质量三元组(原始图像、编辑指令、目标图像)的庞大数据集,确保模型在各种场景下都能稳健应对。在代码层面,Step1X-Edit已无缝集成到最新的Hugging Face Transformers库中,并推荐配合Flash Attention2进行推理加速,进一步提升效率。在GEdit-Bench的严格考核下,Step1X-Edit的表现超越了所有已知的开源基线模型,展现出逼近顶级闭源模型的实力。可以说,Step1X-Edit拥有了类似DALL-E3那样强大的指令理解能力,却通过开放的Apache2.0许可证,打破了技术壁垒,在性能与可及性之间找到了完美的平衡点。

Step1X-Edit的应用前景

Step1X-Edit的通用性使其应用前景极为广阔,几乎能渗透到所有需要图像处理的行业与创作流程中。在电商与广告领域,它可以秒速生成同一产品在不同背景、光线下的展示图,极大提升营销素材的生产效率,无疑是Shopify、Amazon等平台商家的福音。对于数字艺术家和NFT创作者,无论是进行大胆的风格迁移,还是对作品进行精细的局部调整,Step1X-Edit都能成为激发灵感的利器,为OpenSea等市场带来更多独特视觉资产。

内容创作者们也能利用它为Instagram、TikTok等社交媒体平台量身定制吸睛内容,比如将生活照一键转化为流行的卡通风格,或为节日添加应景的元素。甚至在影视与游戏行业,它也能在概念艺术设计阶段大显身手,快速生成场景草图或角色皮肤概念,有效降低前期制作成本。当然,对于AI研究者而言,这个开源框架本身及其配套的GEdit-Bench基准,无疑是加速图像生成技术迭代的宝贵资源。已有社区案例显示,一家电商企业利用Step1X-Edit为服装生成了海滩、都市等多种场景下的展示图,素材制作时间缩短了惊人的70%。更有远见者指出,若将其与类似3DV-TON的视频编辑技术相结合,未来或许能将这种强大的编辑能力延伸至动态内容的创作。

亲身体验Step1X-Edit

想要亲身体验Step1X-Edit的魔力?它已在Hugging Face和GitHub上完全开放。不过请注意,要充分发挥其1024x1024分辨率的实力,官方推荐使用拥有约50GB VRAM的高端GPU(如A100)。上手过程相对直接:克隆GitHub仓库,安装必要的依赖库,加载预训练的Qwen-VL和DiT模型,若条件允许,配置Flash Attention2加速。然后,只需输入你的图片和编辑指令(例如,“把天空换成日落景象”),即可运行推理,见证奇迹的发生。

生成的图像可以轻松导出为PNG或JPEG格式,甚至一键上传至云端或导入Figma等设计工具。社区的经验分享建议,对于复杂的编辑任务,提供更详尽的描述有助于提升生成质量;如果硬件资源有限,尝试512x512分辨率(约需42GB VRAM,生成时间约5秒)也是一个不错的平衡选择。当然,处理极其复杂的场景(如多个物体交错互动)可能仍需顶级硬件支持,持续关注官方更新以获取优化版本是明智之举。

社区反响与未来展望

Step1X-Edit的发布在社区中激起了热烈反响,其彻底的开源精神和令人印象深刻的编辑质量赢得了广泛赞誉。有开发者称其“将高精度图像编辑从闭源巨头的垄断中解放出来,带给了整个开源社区”。它在GEdit-Bench上的出色表现更是被反复提及。然而,高昂的VRAM需求(50GB跑满分辨率)也确实给不少个人用户设置了门槛,优化推理效率成为了社区普遍的期待。此外,对视频编辑的支持和更灵活、更可控的风格调整也是开发者们热切盼望的功能。

令人欣慰的是,开发团队已积极回应,承诺将在后续版本中努力降低硬件门槛,并探索与更强大的Qwen2.5-VL-72B模型集成,以进一步提升多模态理解与处理能力。有分析预测,为了让更多人能用上这项技术,Step1X-Edit未来可能会效仿DeepWiki等项目,推出便捷的云端API服务(SaaS模式),从而大幅降低使用成本。

Step1X-Edit的诞生是开源图像编辑领域的一座重要里程碑。它所采用的Qwen-VL与DiT结合的架构,不仅在性能上达到了接近闭源模型的高度,更通过GEdit-Bench为行业贡献了一套宝贵的、面向真实应用场景的评估标准。社区中已经开始热烈讨论如何将其与DeepWiki、ComfyUI等现有工具链整合,构建从代码理解到视觉设计、再到最终输出的完整闭环工作流。从长远来看,Step1X-Edit极有可能演化为一个功能丰富的“开源设计平台”,提供类似Hugging Face那样的模型生态,包含丰富的模板市场和便捷的云端推理服务。我们热切期待在2025年接下来的时间里,看到Step1X-Edit在低资源优化和多模态能力扩展上带来更多惊喜。

总而言之,Step1X-Edit以其强大的多模态指令编辑能力、令人惊叹的高保真生成效果以及彻底的开源生态理念,为图像编辑领域注入了前所未有的活力。其采用的Apache2.0许可证和配套的GEdit-Bench基准测试,更有力地推动了社区协作和技术透明化。我们强烈推荐所有对AI图像编辑感兴趣的朋友,访问其Hugging Face页面或GitHub仓库,亲手体验这一框架的魅力,或是参与到GEdit-Bench的贡献中,共同完善这把衡量未来的标尺。