在人工智能领域,多模态模型的快速发展正引领着新一轮的技术革新。阿里巴巴 Qwen 团队推出的 Qwen2.5-Omni-3B 模型,作为 Qwen2.5-Omni-7B 的精简版本,在保持卓越性能的同时,更专注于消费级硬件的适配。这款轻量级多模态 AI 模型,不仅支持文本、音频、图像和视频等多种输入形式,还在实时文本生成和自然语音输出方面表现出色,为用户带来了前所未有的交互体验。

Qwen2.5-Omni-3B:技术特点与优势

Qwen2.5-Omni-3B 的核心优势在于其高效的资源利用和卓越的性能表现。尽管参数量从 7B 缩减到 3B,该模型仍能保持 7B 模型 90% 以上的多模态性能。这种高效性得益于阿里巴巴 Qwen 团队在模型架构和优化方面的创新。

多模态输入与实时响应

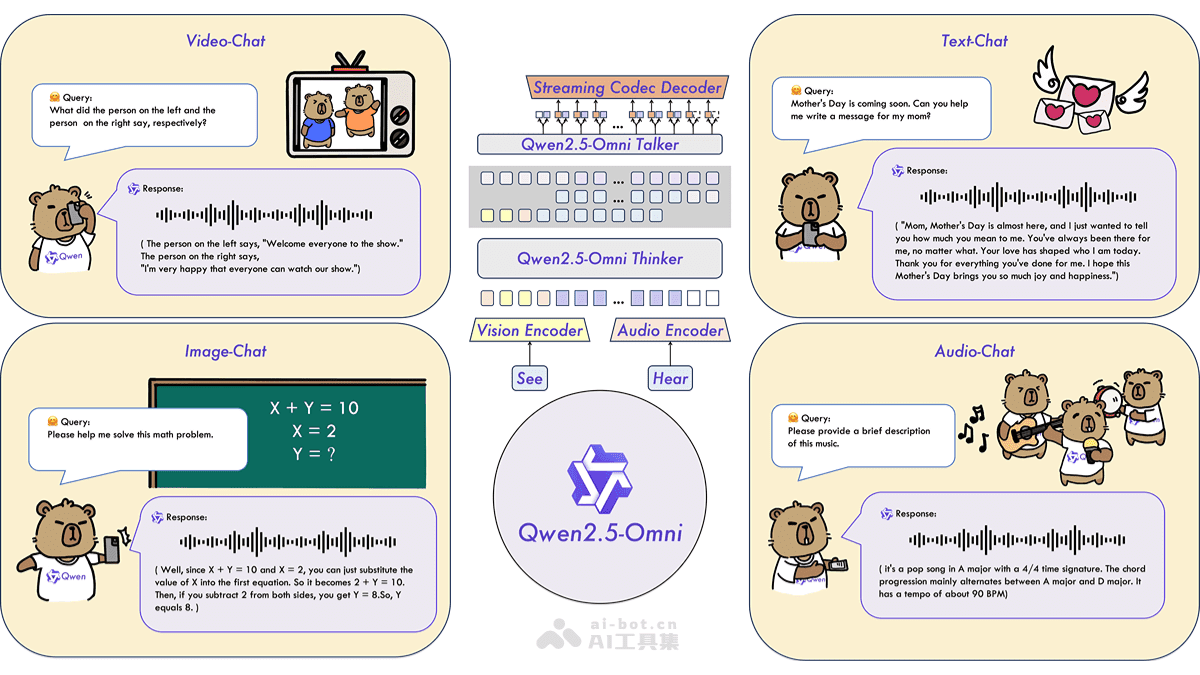

Qwen2.5-Omni-3B 模型支持多种输入模态,包括文本、音频、图像和视频。这意味着用户可以通过不同的方式与模型进行交互,从而实现更加自然和直观的体验。更重要的是,该模型能够实时生成文本和自然语音响应,确保用户能够及时获得反馈。

语音定制

为了满足不同用户的需求,Qwen2.5-Omni-3B 提供了语音定制功能。用户可以在两个内置声音之间进行选择,分别是 Chelsie(女性)和 Ethan(男性)。这种个性化的设置,使得模型能够更好地适应不同的应用场景和受众。

显存优化

对于许多开发者而言,显存占用是一个重要的考虑因素。Qwen2.5-Omni-3B 在显存优化方面表现出色。在处理 25,000 token 的长上下文输入时,显存占用从 7B 模型的 60.2GB 降至 28.2GB,减少了 53%。这意味着该模型可以在 24GB GPU 的设备上运行,从而降低了硬件成本。

架构创新

Qwen2.5-Omni-3B 采用了 Thinker-Talker 设计和定制位置嵌入方法 TMRoPE。Thinker-Talker 架构将模型分为“思考者”和“说话者”两个部分,分别负责处理多模态输入和生成自然语音。TMRoPE 则确保了视频与音频输入的同步理解。

优化支持

为了进一步提升性能,Qwen2.5-Omni-3B 支持 FlashAttention 2 和 BF16 精度优化。这些优化技术可以显著提高处理速度并降低内存消耗,从而使得模型在实际应用中更加高效。

性能表现

尽管参数量有所减少,Qwen2.5-Omni-3B 在多模态基准测试中仍表现出色。例如,在 VideoBench 视频理解测试中,该模型得分为 68.8;在 Seed-tts-eval 语音生成测试中,该模型得分为 92.1。这些数据表明,Qwen2.5-Omni-3B 在性能方面完全可以媲美 7B 模型。

Qwen2.5-Omni-3B 的技术原理

Qwen2.5-Omni-3B 的技术原理主要包括 Thinker-Talker 架构、时间对齐多模态位置嵌入(TMRoPE)、流式处理与实时响应以及精度优化。

Thinker-Talker 架构

Thinker-Talker 架构是 Qwen2.5-Omni-3B 的核心组成部分。该架构将模型分为“思考者”(Thinker)和“说话者”(Talker)两个部分。Thinker 负责处理和理解多模态输入(如文本、音频和视频),生成高级语义表示和文本输出;Talker 基于 Thinker 的输出生成自然语音,确保文本生成和语音输出的同步进行。这种分离的设计使得模型能够更好地处理复杂的任务。

时间对齐多模态位置嵌入(TMRoPE)

为了同步视频输入的时间戳与音频,Qwen2.5-Omni-3B 提出了 TMRoPE(Time-aligned Multimodal RoPE)。通过交错排列音频和视频帧的时间 ID,将多模态输入的三维位置信息(时间、高度、宽度)编码到模型中,实现视频与音频输入的同步理解。这对于处理涉及多种模态输入的任务至关重要。

流式处理与实时响应

为了实现实时响应,Qwen2.5-Omni-3B 采用了流式处理技术。模型采用了分块处理方法,将长序列的多模态数据分解为小块进行处理,减少处理延迟。此外,模型还引入了滑动窗口机制,限制当前标记的上下文范围,进一步优化流式生成的效率。这些技术使得模型能够以流式方式实时生成文本和语音响应。

精度优化

为了进一步提升性能,Qwen2.5-Omni-3B 支持 FlashAttention 2 和 BF16 精度优化。这些优化技术可以显著提高处理速度并降低内存消耗,从而使得模型在实际应用中更加高效。

Qwen2.5-Omni-3B 的应用场景

Qwen2.5-Omni-3B 的多功能性使其适用于各种应用场景。以下是一些典型的应用示例:

视频理解与分析

Qwen2.5-Omni-3B 能够实时处理和分析视频内容。这使得其可以应用于视频内容分析、监控视频解读、智能视频编辑等领域。例如,该模型可以帮助用户快速提取视频中的关键信息,从而提高工作效率。

语音生成与交互

Qwen2.5-Omni-3B 支持语音定制功能,用户可以在两个内置声音(Chelsie 女性和 Ethan 男性)之间选择。这使得其可以用于智能语音助手、语音播报系统、有声读物生成等场景。例如,该模型可以用于创建自然流畅的语音交互体验,从而提高用户满意度。

智能客服与自动化报告生成

Qwen2.5-Omni-3B 可以处理文本输入并实时生成文本响应,适用于智能客服系统。例如,该模型可以快速解答用户问题并提供解决方案,从而提高客户服务效率。此外,该模型还可以用于自动化报告生成,从而节省人力成本。

教育与学习工具

在教育领域,Qwen2.5-Omni-3B 可以辅助教学。例如,通过语音和文本交互,该模型可以帮助学生解答问题、提供学习指导。特别是在数学教学方面,Qwen2.5-Omni-3B 可以解析几何问题并提供分步推理指导,从而帮助学生更好地理解数学概念。

创意内容生成

Qwen2.5-Omni-3B 能够分析图像内容并生成图文结合的创意内容。例如,该模型可以用于生成社交媒体帖子、广告文案等,从而帮助用户快速创建引人注目的内容。

结论

总而言之,Qwen2.5-Omni-3B 作为阿里巴巴 Qwen 团队推出的轻量级多模态 AI 模型,凭借其高效的资源利用、卓越的性能表现和广泛的应用场景,为人工智能领域带来了新的可能性。随着技术的不断发展,我们有理由相信,Qwen2.5-Omni-3B 将在未来的发展中发挥更大的作用,为人类创造更多的价值。