在人工智能领域,我们常常惊叹于AI在诗歌创作、绘画艺术乃至日常对话中的卓越表现。然而,当AI面对视频时,它是否真正理解了视频背后的“灵魂”?

你或许会认为,AI已经能够轻松识别视频中的猫、狗以及人群。但请注意,识别物体与理解视频的“灵魂”——即摄像机的运动方式——是截然不同的。想象一下,希区柯克电影中经典的“滑动变焦”(dolly zoom)所带来的眩晕感;《侏罗纪公园》中,镜头缓缓抬起(tilt up)并平移(pan right),首次展现恐龙时的那种敬畏之情;或者,在偶像vlog中,紧随偶像的“跟踪镜头”(tracking shot)。这些运镜手法都在讲述故事,传递情感。

然而,对于AI而言,这些微妙的动作语言在很大程度上仍然是一个谜。它可能能够识别出画面中有人在奔跑,但很难准确判断摄像机是在跟踪拍摄(tracking),还是在原地旋转(panning),亦或是像喝醉酒一样摇晃(unsteady)。这显然是不够的。无论是为了深入理解视频内容、进行3D重建(SfM/SLAM),还是为了生成更逼真的视频,理解镜头运动都是AI必须掌握的一项基本技能。

幸运的是,来自卡内基梅隆大学(CMU)、马萨诸塞大学阿默斯特分校(UMass)、南加州大学(USC)等顶尖机构的研究人员已经着手解决这个问题。他们共同推出了一个名为CameraBench的项目,旨在为AI提供全面的“电影摄影课程”。接下来,我们将深入剖析这篇最新的研究论文,用通俗易懂的语言揭示其背后的奥秘。

AI为何难以理解镜头运动?

你可能会感到疑惑,人类天生就具备观察和理解能力,为什么AI在这方面却显得如此吃力?原因在于其中存在诸多挑战:

- 参照物不明确导致理解偏差: 例如,在无人机俯拍的场景中,当镜头向前飞行时,有人会描述为“向前”,而另一些人则会因为镜头朝向地面而描述为“向下”。那么,到底应该以相机自身、地面还是画面中的物体为参照?如果参照物不明确,AI就容易产生混淆。研究论文指出,人们在描述镜头运动时,通常会结合场景或物体,例如“相机跟随主体移动”,即使相机实际上是在倒退飞行!

- 专业术语繁多且易混淆: 你是否也难以区分“推拉镜头”(Dolly In/Out)和“变焦”(Zoom In/Out)?前者是指相机发生真实的物理移动(改变相机外参),而后者仅仅是调整镜头内部的镜片(改变相机内参)。虽然效果相似,但原理和透视感却截然不同!即使是专业人士也常常混淆这些概念,如果AI模型学习出现偏差,后果将不堪设想。

- 现实场景的复杂性: 互联网上的视频内容千变万化。镜头运动可能先向前,然后突然转向;可能抖动得像帕金森患者;也可能同时运用多种运镜方式……试图用简单的“左移”、“右移”等标签来概括这些复杂的运动是远远不够的。

面对这些挑战,传统的方法显得有些力不从心:

- 传统的几何学方法(SfM/SLAM): 这类方法擅长通过分析画面像素的变化来推算相机的轨迹,并在3D重建方面表现出色。然而,在动态场景中(例如画面中人和车辆都在移动),它们很容易“敌我不分”,难以区分是相机在移动还是物体在移动。此外,它们只关注冷冰冰的坐标数据,完全无法理解运镜的“意图”和“情感”。

- 新兴的语言模型(VLM): 像GPT-4o、Gemini等模型,在理解语义方面表现出色,似乎能够“看懂”视频。但它们对精确的几何运动(例如平移1米还是旋转5度)却不够敏感,理解主要依赖于“猜测”和大规模训练数据中获得的“感觉”。

因此,研究人员认为,现在是时候系统地解决这个问题了!

CameraBench:构建AI的“镜头语言词典”

CameraBench不仅仅是一个简单的数据库,而是一整套解决方案。其核心在于两个关键要素:一个详细的“镜头运动分类法”(Taxonomy)和一个高质量的“标注数据集”。

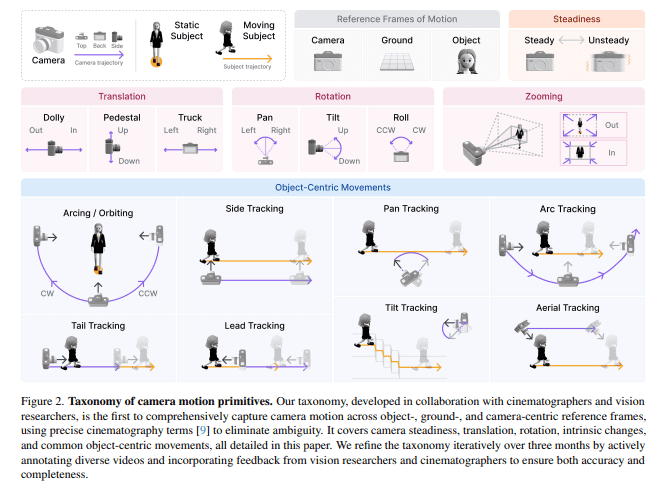

1. 镜头运动分类法(Taxonomy)

这个分类法并非凭空想象,而是由视觉研究人员和专业的电影摄影师共同合作,历经数月精心打磨而成。它充分考虑了以下因素:

- 三大参照系: 明确区分相对于物体(Object)、地面(Ground)还是相机自身(Camera)的运动,从而解决参照物混乱的问题。

- 精准术语: 采用电影行业的标准术语,避免歧义。

- 平移(Translation):Dolly(前后)、Pedestal(上下)、Truck(左右)。相机发生真实的物理移动!

- 旋转(Rotation):Pan(左右摇摆)、Tilt(上下点头)、Roll(侧向翻滚)。相机在原地转动!

- 变焦(Zooming):Zoom In/Out。镜头内部发生变化,改变焦距!

- 目标导向: 还考虑了以物体为中心的运动,例如镜头是否为了使主体在画面中显得更大或更小。

这个分类法就像一本权威的词典,为混乱的镜头运动描述建立了规范!

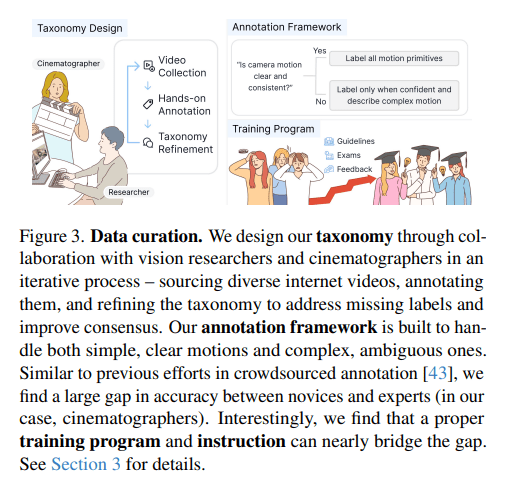

2. 数据集标注

有了好的词典,还需要高质量的例句。研究人员从互联网上收集了约3000个各种各样的视频片段,包括电影、广告、游戏、Vlog、动画、体育赛事等。然后,他们进行了一套极其严格的标注流程:

- 人工分镜: 首先将视频手动切割成一个个独立的、运镜连续的镜头。

- “先打标签,再描述”(Label-then-caption):

- 简单、清晰的运动:标注员必须严格按照分类法,为所有相关的运动都打上标签。

- 复杂、模糊的运动:如果运动非常复杂(例如先左摇再右摇)或者看不清(例如背景太暗),标注员只选择自己非常有把握的标签,其他留空(标为“不确定”)。然后,必须用自然语言写一段描述,解释清楚这个复杂的运动过程,或者说明为什么看不清。

- 还要解释“为什么这么动”:鼓励标注员描述运镜的意图,例如“第一人称视角跟随角色走路”、“为了展示风景”、“为了跟踪主体”等。这使得数据不仅包含了几何信息,还包含了语义和叙事的维度!

- 专家把关 + 魔鬼训练营:

- 研究人员发现,有摄影经验的“专家”比“小白”的标注准确率高15%以上!

- 为了保证大规模标注的质量,他们推出了一个“培训计划”,提供详细的图文并茂的指南(包含各种易错点、边界案例),并让标注员参加多轮考试(每轮标注30个视频),考完还有详细的错误反馈PDF!

- 经过培训,无论是专家还是小白,准确率都提升了10-15%!只有通过所有培训(平均耗时20小时!)的人才能上岗。而且还有随机抽查和反馈机制,以保证质量。

这套流程下来,得到的数据质量非常高,既有结构化的标签,又有丰富的自然语言描述。

CameraBench的“期末考试”

有了CameraBench这个强大的教材和考卷,研究人员立即将市面上主流的AI模型拉来进行“考试”。考题包括运动分类、视频问答(VQA)、视频描述生成、视频文本检索等。

考试结果(有些惨不忍睹,但也在意料之中):

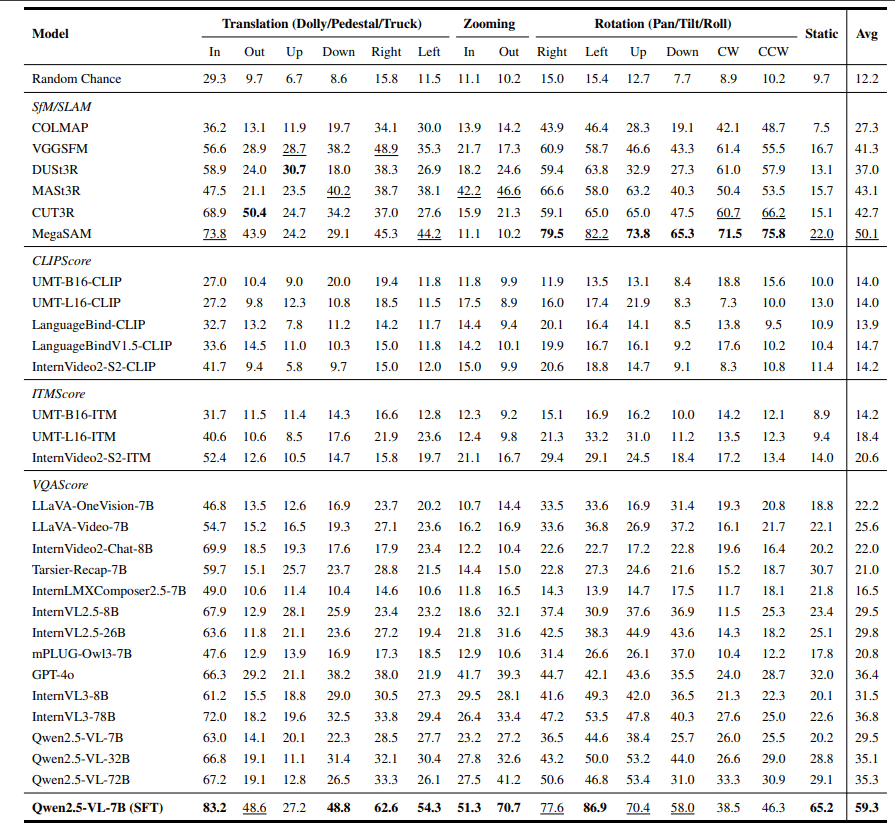

1. 几何学方法(SfM/SLAM)的成绩单:

- 优势: 处理简单、静态的场景还算可以。基于学习的方法(如MegaSAM)比传统方法(如COLMAP)对动态场景的处理效果更好。

- 劣势: 遇到主体在动、背景纹理较少的视频就束手无策(如图7所示,跟踪拍摄时相机明明在后退,但由于主体在画面中相对静止,AI就认为相机没有移动,甚至直接崩溃!);对旋转和移动分不清楚;完全无法理解语义(例如无法判断“这是否是一个跟踪镜头”)。结论:基本功尚可,但应用题全部挂科。

2. 语言模型(VLM)的成绩单:

- 优势: 对语义理解具有潜力!例如能够大致判断出“相机在跟随人移动”。生成式VLM(如GPT-4o)普遍比判别式VLM表现更好。

- 劣势: 几何感知是硬伤!让它们精确判断是Pan还是Truck,是Dolly还是Zoom,基本靠猜测。在VQA测试中,许多模型的表现甚至不如瞎猜。结论:擅长华丽的辞藻,但缺乏对物理世界的精确感知。

3. 语言模型上了“电影课”

既然VLM具有潜力,研究人员就想:是否可以使用CameraBench的高质量数据来给VLM“补课”呢?

他们选择了一个表现不错的生成式VLM(Qwen2.5-VL),并使用CameraBench的一部分数据(约1400个视频)进行了监督微调(SFT)。请注意,这只是一个小规模的微调!

结果如何?

效果显著!

- 分类任务: 微调后的模型在镜头运动分类任务上的性能提升了1-2倍!整体表现追平了最好的几何方法MegaSAM!

- 生成任务(描述/VQA): 更是远超之前的自己和其他VLM!生成的镜头描述更加准确、更加细致(请参阅图8、9、10的对比!)。VQA任务也表现出色,尤其是在需要理解复杂逻辑和物体中心运动的任务上。

这意味着什么?

高质量、带有精确几何和语义标注的数据,对于提升VLM理解视频动态(尤其是镜头运动)至关重要!CameraBench提供的这套“教材”确实有效!

未来展望

CameraBench项目在让AI理解镜头运动方面迈出了关键一步。它告诉我们:

- 需要专业的分类法:定义清晰、参照系明确是基础。

- 高质量数据是关键:专家参与、严格的标注流程和培训必不可少。

- 几何和语义相结合:SfM/SLAM和VLM各有优劣,未来需要融合两者的优势。

- 微调潜力巨大:即使是小规模的高质量数据微调,也能显著提升现有大模型的能力。

当然,研究仍在继续。未来可能需要更多样、更具挑战性的数据,探索更有效的模型训练方法,甚至让AI不仅能够识别运镜,还能够理解运镜背后的情感和导演意图。

总而言之,CameraBench不仅仅是一个数据集,它更像是一个“AI电影学院”的雏形。它用严谨的方法论、专业的知识和高质量的数据,试图教会AI这个“直男”如何欣赏和理解镜头运动这门充满魅力的“视觉舞蹈”。

虽然现在的AI在这方面还像一个刚入门的学生,但有了CameraBench这样的“教科书”和“训练场”,相信不久的将来,AI不仅能看懂视频里的猫猫狗狗,更能和你一起讨论:“哇,你看诺兰这个旋转镜头用得多妙!”

想了解更多技术细节可至项目页查看~