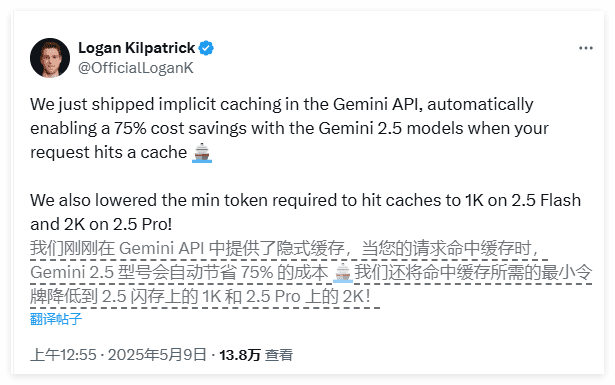

在人工智能技术日新月异的今天,Google再次走在了创新的前沿。近期,Google Gemini API推出了一项名为“隐式缓存”的全新功能,这项功能旨在帮助广大开发者在使用最新的AI模型时,显著降低成本,特别是在处理重复性上下文时,成本节约效果尤为突出,最高可达75%。

隐式缓存的工作原理

隐式缓存的核心在于其卓越的自动化能力,能够智能识别并高效重用先前请求中相似的内容。这项新功能已默认开启,适用于Gemini 2.5 Pro和2.5 Flash模型,为开发者带来极大的便利。当开发者向Gemini 2.5模型发送请求时,系统会自动检测该请求与之前的请求是否存在相同的前缀。如果存在,系统将自动命中缓存,从而实现成本的节约。这一过程无需人工干预,极大地简化了开发流程。

隐式缓存与之前的显式缓存存在显著区别。显式缓存需要开发者手动定义高频请求,操作繁琐,令许多开发者望而却步。尤其是在最近几周,关于API费用过高的投诉不断增加,使得开发者对于更高效、更便捷的缓存方案的需求更加迫切。隐式缓存的推出,无疑为开发者提供了一个理想的解决方案。

隐式缓存的优势

隐式缓存的最大优势在于其高度的自动化。当请求的上下文信息与先前请求相似时,系统会自动返回成本节约,无需开发者进行任何手动配置。这种自动化不仅简化了开发者的操作流程,还大大减轻了他们的负担,使他们能够更专注于创新和优化。

根据Google的开发者文档,隐式缓存的最低提示令牌数为2,048(针对2.5 Pro模型)和1,024(针对2.5 Flash模型)。这意味着,开发者只需提供少量的信息,即可触发自动节省,极大地降低了使用门槛。令牌是模型处理的数据基本单元,大约1,000个令牌相当于750个单词。因此,即使是少量的重复内容,也能带来显著的成本节约。

使用建议与注意事项

为了更好地利用隐式缓存,Google 建议开发者在请求的开头尽量放置重复的上下文内容,以增加命中缓存的几率。而可能会在请求间变化的上下文信息,则建议放在请求的末尾。通过这种方式,可以最大程度地提高缓存的命中率,从而实现最佳的成本节约效果。

尽管 Google 对此次隐式缓存的效果充满信心,但尚未提供第三方验证,因此开发者在使用过程中仍需保持谨慎。建议开发者在使用过程中密切关注成本变化,并根据实际情况进行调整。随着越来越多的开发者开始使用这一新功能,我们期待他们的反馈能够验证 Google 的承诺,并为隐式缓存的进一步优化提供宝贵的参考。

AI模型成本控制的新思路

在AI模型的使用成本持续上升的背景下,Google的隐式缓存功能无疑为开发者提供了一个降低成本的新选择。这项创新功能的推出,有望对开发者社区产生积极影响,激发更多的创新和应用。未来,随着反馈的积累,我们也将看到这一功能的实际效果,并期待其在AI领域发挥更大的作用。

隐式缓存的出现,实际上反映了AI技术发展的一个重要趋势,即从单纯追求模型性能向更加注重成本效益的转变。在AI应用的早期阶段,开发者往往更关注模型的准确率、速度等指标,而忽略了成本因素。然而,随着AI应用的普及,成本问题日益凸显,成为制约AI技术进一步发展的瓶颈。

隐式缓存通过减少重复计算,降低了AI模型的使用成本,为开发者提供了更多的灵活性和选择空间。开发者可以将节省下来的成本用于其他方面的创新,例如优化模型结构、改进算法、拓展应用场景等,从而推动AI技术的整体发展。

隐式缓存与显式缓存的对比分析

为了更深入地理解隐式缓存的优势,我们不妨将其与显式缓存进行对比分析。

显式缓存是一种传统的缓存技术,需要开发者手动指定需要缓存的数据。这种方式的优点是可以精确控制缓存的内容,避免缓存不必要的数据,从而提高缓存的效率。然而,显式缓存的缺点也很明显,即需要开发者花费大量的时间和精力进行配置和管理。特别是对于复杂的AI应用来说,手动配置缓存可能是一项非常繁琐的任务。

相比之下,隐式缓存则更加智能化和自动化。它能够自动识别并缓存重复使用的数据,无需开发者进行手动配置。这种方式的优点是简单易用,可以大大减轻开发者的负担。然而,隐式缓存的缺点是无法精确控制缓存的内容,可能会缓存一些不必要的数据,从而降低缓存的效率。因此,在选择缓存方式时,开发者需要根据实际情况进行权衡。

隐式缓存的潜在应用场景

隐式缓存的应用场景非常广泛,几乎可以应用于所有使用Gemini 2.5 Pro和2.5 Flash模型的AI应用。以下是一些典型的应用场景:

- 聊天机器人: 聊天机器人需要处理大量的用户输入,其中很多输入可能包含重复的上下文信息。通过使用隐式缓存,可以避免重复计算,降低聊天机器人的响应延迟,提高用户体验。

- 文本摘要: 文本摘要的任务是从一篇长篇文章中提取出关键信息。在处理多篇文章时,可能会出现重复的段落或句子。通过使用隐式缓存,可以避免重复处理这些重复内容,提高文本摘要的效率。

- 代码生成: 代码生成的任务是根据自然语言描述生成代码。在生成相似的代码时,可能会出现重复的代码片段。通过使用隐式缓存,可以避免重复生成这些代码片段,提高代码生成的效率。

- 机器翻译: 机器翻译的任务是将一种语言的文本翻译成另一种语言。在翻译相似的句子时,可能会出现重复的词汇或短语。通过使用隐式缓存,可以避免重复翻译这些词汇或短语,提高机器翻译的效率。

未来展望:AI缓存技术的演进

隐式缓存的推出,标志着AI缓存技术进入了一个新的阶段。未来,我们可以期待AI缓存技术在以下几个方面取得更大的进展:

- 更智能的缓存策略: 未来的AI缓存技术将能够更智能地识别和缓存数据,从而提高缓存的效率。例如,可以根据数据的访问频率、重要程度等因素,动态调整缓存策略。

- 更强大的缓存容量: 未来的AI缓存技术将能够支持更大的缓存容量,从而存储更多的数据。这需要依赖于存储技术的不断发展。

- 更安全的缓存机制: 未来的AI缓存技术将能够提供更安全的缓存机制,保护缓存数据的安全性。例如,可以使用加密技术对缓存数据进行加密,防止未经授权的访问。

总之,Google Gemini API的隐式缓存功能是一项重要的创新,它为开发者提供了一个降低AI模型使用成本的新选择。随着AI技术的不断发展,我们相信AI缓存技术将在未来发挥更大的作用,推动AI应用的普及和发展。

官方博客:https://developers.googleblog.com/en/gemini-2-5-models-now-support-implicit-caching/