在人工智能领域,大语言模型(LLM)已成为一股强大的力量,它们能够生成文本、翻译语言、编写代码,并以惊人的准确性回答问题。然而,这些模型并非完美无缺。一个长期存在的问题是它们的“健忘症”——在长时间的对话中,它们往往会忘记之前说过的内容,这极大地限制了它们在需要持续上下文理解的应用中的实用性。不过,一家名为Supermemory的公司推出了一项创新技术,旨在通过为AI提供“无限记忆”来解决这个问题。这项技术有望彻底改变我们与AI交互的方式。

大语言模型的记忆困境

诸如ChatGPT和Claude等大语言模型都受到上下文窗口大小的限制。上下文窗口是指模型在生成下一个token时可以考虑的先前token的数量。虽然像GPT-4和Claude 3这样的最新模型已经显著增加了它们的上下文窗口大小,达到了8k、32k甚至128k tokens,但这仍然是一个有限的资源。一旦对话超过了这个限制,模型就会开始“忘记”最早的token,从而导致对话出现不连贯和不准确的情况。

这种“健忘症”对许多应用来说都是一个严重的问题。例如,在客户服务聊天机器人中,如果机器人忘记了客户之前说过的内容,可能会导致重复提问和令人沮丧的体验。在创意写作中,如果模型忘记了故事的早期情节,可能会导致情节漏洞和不一致。在代码生成中,如果模型忘记了之前的代码片段,可能会导致错误和重复代码。

Supermemory的解决方案:Infinite Chat API

Supermemory通过推出Infinite Chat API来解决大语言模型的记忆问题。这项技术旨在无限扩展任何大语言模型的上下文长度,使AI能够记住无限量的对话历史记录,而无需开发者重写任何应用程序逻辑。这项技术的关键在于其创新的智能代理架构,该架构包含三个关键环节:透明代理机制、智能分段与检索系统和自动Token管理。

透明代理机制

Supermemory充当中间层,拦截应用程序和大语言模型之间的所有通信。为了使用Supermemory,开发者只需将原有OpenAI等API的请求URL更改为Supermemory的地址。然后,系统会自动将请求转发给相应的LLM。这意味着开发者几乎无需更改代码,就能立即获得“无限记忆”功能。

这种透明代理机制非常方便,因为它允许开发者在不改变现有代码库的情况下集成Supermemory。这对于那些已经构建了基于大语言模型的复杂应用程序的开发者来说尤其有吸引力。

智能分段与检索系统

Supermemory的核心是其智能分段与检索系统。该系统将长对话内容分成保持语义连贯性的块。当模型需要访问上下文时,系统只会提取与当前对话最相关的上下文片段,而不是将全部历史记录传递给大模型。这极大地提高了效率并降低了资源消耗。

这种智能分段和检索系统类似于人类记忆的工作方式。当我们回忆起某个事件时,我们通常不会记住所有细节,而是会提取与当前情境最相关的关键信息。Supermemory的系统以类似的方式工作,确保模型能够访问其所需的上下文,而不会被不相关的信息淹没。

自动Token管理

由于大语言模型的API是按token收费的,因此管理token的使用对于控制成本至关重要。Supermemory的自动Token管理系统可以根据实际需求智能控制token使用量。该系统会监控对话的长度,并根据需要压缩或删除不相关的上下文,以确保token使用量保持在可接受的水平。这避免了因上下文过长导致的性能下降,同时防止成本失控及请求失败。

一行代码,立即生效

Supermemory的接入流程非常简单。开发者只需三个步骤即可开始使用:

- 获取API Key

- 更换请求URL

- 添加请求头中的认证信息

这种简单的接入流程意味着开发者可以快速轻松地将Supermemory集成到他们的应用程序中,而无需花费大量时间和精力来学习和配置复杂的系统。

性能与费用

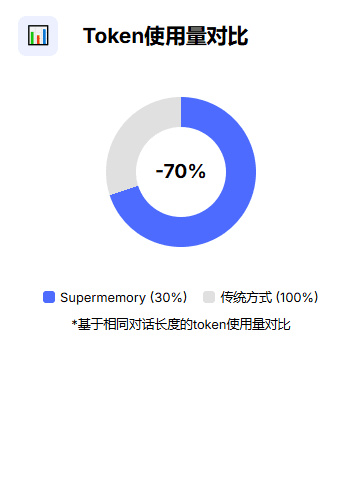

在性能方面,Supermemory表现出色。它完全突破了OpenAI等模型的token限制,据称可节省高达70%甚至90%的token使用量,同时几乎不增加延迟。这意味着开发者可以使用更少的token来获得相同或更好的性能,从而降低了成本并提高了效率。

Supermemory的价格模式也相当亲民。它提供10万tokens的免费存储额度,之后每月仅需20美元的固定费用,超出部分按增量计费。这种灵活的价格模式使各种规模的开发者都可以使用Supermemory。

容错机制与兼容性

为了确保稳定性,Supermemory还设计了容错机制。即使系统自身出现异常,它也会自动绕过,直接将请求转发给原LLM,确保服务不中断。这意味着开发者可以依靠Supermemory来提供可靠的服务,即使在出现问题时也是如此。

在兼容性方面,Supermemory支持所有兼容OpenAI API的模型和服务,包括OpenAI的GPT系列、Anthropic的Claude3系列,以及其他提供OpenAI接口兼容层的服务商。这种广泛的兼容性意味着开发者可以使用他们选择的任何大语言模型,而无需担心兼容性问题。

Supermemory的意义

业内专家认为,Supermemory的出现标志着AI代理正从孤立工具向前端驱动软件产品进化,将大幅降低开发者将AI代理集成到生产环境的门槛,有望加速交互式AI应用的普及。通过解决大语言模型的记忆问题,Supermemory正在为构建更智能、更具对话性和更有用的AI应用程序铺平道路。

尽管这项技术仍处于早期阶段,但其开源性质和广泛框架支持,已吸引大量开发者关注,共同构建更智能的AI应用未来。随着越来越多的开发者开始使用Supermemory,我们可以期待看到AI应用程序在未来几年内实现巨大的飞跃。

总而言之,Supermemory的Infinite Chat API是一项有前途的技术,它有可能解决大语言模型的一个长期存在的问题。通过提供无限的上下文长度和智能的token管理,Supermemory正在使开发者能够构建更智能、更具对话性和更有用的AI应用程序。随着这项技术的不断发展,我们可以期待看到它在未来几年内对AI领域产生重大影响。