AI模型上下文长度的飞跃:SiliconCloud引领推理新纪元

在人工智能技术日新月异的今天,模型推理能力成为了衡量AI应用潜力的关键指标。近日,SiliconCloud宣布对其DeepSeek-R1及其他推理模型API进行重大升级,将最大上下文长度扩展至128K,引发业界广泛关注。这一举措不仅显著提升了模型处理复杂任务的能力,也为开发者带来了前所未有的灵活性和控制力。

128K上下文长度:开启AI推理的全新维度

上下文长度,作为衡量AI模型理解和生成文本的关键参数,直接影响着模型在处理长文本、复杂推理和生成连贯内容方面的表现。此次SiliconCloud的升级,将Qwen3、QWQ、GLM-Z1等知名模型的最大上下文长度提升至128K,而DeepSeek-R1也达到了96K。这意味着这些模型现在能够处理更长的输入序列,从而在诸如代码生成、智能应用等复杂任务中表现出更强的综合推理能力。

128K上下文长度的实现,为AI应用开辟了新的可能性。例如,在代码生成领域,模型可以一次性处理更大的代码库,从而生成更完整、更高效的代码。在智能应用中,模型可以更好地理解用户的意图,提供更精准、更个性化的服务。此外,更长的上下文长度还有助于模型在处理长篇文档、复杂对话等任务时,保持上下文的一致性和连贯性。

精细化控制:推理链与响应内容的独立管理

除了扩展上下文长度,SiliconCloud还引入了一项创新性的功能:独立控制“推理链”和“响应内容”的长度。通过这一功能,开发者可以更有效地利用模型的推理能力,根据实际任务的复杂性,灵活调整模型的推理深度和输出长度。

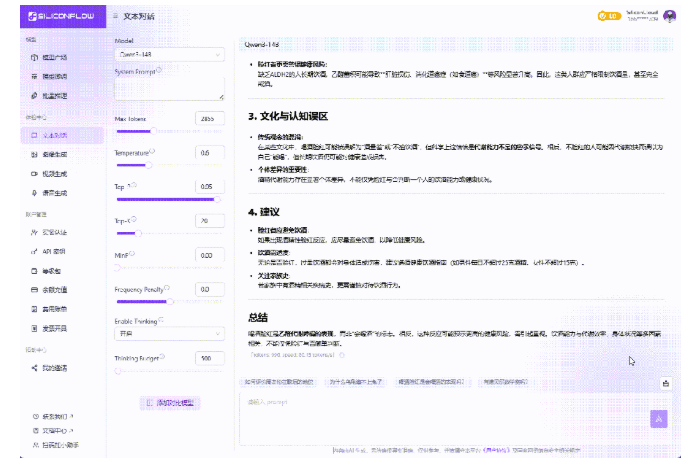

具体而言,SiliconCloud平台引入了thinking_budget和max_tokens两个参数。max_tokens用于限制模型最终输出给用户的文本长度,而thinking_budget则专门用于控制模型在推理阶段使用的token数量。这种设计允许开发者在保证输出质量的前提下,最大限度地控制计算成本。

例如,开发者可以通过设置thinking_budget来控制Qwen3-14B系列模型在推理过程中的token数量。一旦推理阶段生成的token数量达到thinking_budget的上限,Qwen3系列模型将强制停止推理链,从而避免不必要的计算资源浪费。而对于其他推理模型,平台可能允许它们继续输出推理内容,从而提供更大的灵活性。

灵活的长度控制与清晰的输出反馈

为了进一步提升用户体验,SiliconCloud还对模型输出的长度控制进行了优化。如果模型生成的响应内容超过了max_tokens的限制,或者上下文长度超过了context_length的限制,模型将会截断输出内容,并在响应的finish_reason字段中标记为length,明确告知用户输出被截断的原因。

这种清晰的反馈机制,有助于开发者更好地理解模型的行为,及时调整参数设置,从而获得更符合预期的输出结果。同时,它也为开发者提供了更多的调试和优化空间,促进了AI应用的不断创新。

技术解析:独立控制的优势与应用场景

SiliconCloud的这一创新设计,解决了传统AI模型在处理长文本和复杂推理任务时面临的诸多挑战。传统的AI模型通常将推理过程和最终输出混为一谈,导致开发者难以对模型的行为进行精细化控制。而SiliconCloud的独立控制机制,将推理过程和最终输出分离,允许开发者根据实际需求,灵活调整模型的推理深度和输出长度。

这种独立控制机制的优势在于:

- 提高资源利用率:开发者可以根据任务的复杂性,合理分配计算资源,避免不必要的浪费。

- 优化模型性能:通过控制推理链的长度,开发者可以避免模型过度推理,从而提高模型的效率和准确性。

- 增强可控性:开发者可以更好地理解和控制模型的行为,从而提高AI应用的可靠性和安全性。

在实际应用中,这种独立控制机制具有广泛的应用前景。例如,在金融领域,模型可以利用thinking_budget进行深入的风险评估,然后利用max_tokens生成简洁明了的报告。在医疗领域,模型可以利用thinking_budget进行全面的病情分析,然后利用max_tokens生成易于理解的诊断建议。在教育领域,模型可以利用thinking_budget进行深入的知识挖掘,然后利用max_tokens生成个性化的学习计划。

技术挑战与未来展望

尽管SiliconCloud的创新设计带来了诸多优势,但也面临着一些技术挑战。例如,如何自动确定最佳的thinking_budget和max_tokens值,以适应不同的任务和数据集,仍然是一个需要深入研究的问题。此外,如何进一步优化模型的推理效率,以支持更长的上下文长度和更复杂的推理任务,也是一个重要的研究方向。

展望未来,随着AI技术的不断发展,我们有理由相信,SiliconCloud的创新设计将会在AI领域发挥越来越重要的作用。通过不断优化和完善,这种独立控制机制有望成为AI模型推理的标准配置,为开发者带来更多的便利和可能性。同时,我们也期待更多的AI企业能够加入到这场创新浪潮中,共同推动AI技术的发展,为人类创造更美好的未来。

开发者可以通过访问SiliconCloud的官方文档 https://docs.siliconflow.cn/en/userguide/capabilities/reasoning 了解更多关于API使用的细节。随着SiliconCloud不断创新,用户体验将会持续提升,更多功能也将陆续推出。

结语:AI推理的新篇章

SiliconCloud此次对DeepSeek-R1及其他推理模型API的升级,不仅是一次简单的技术提升,更是对AI推理理念的一次深刻变革。通过扩展上下文长度和引入独立控制机制,SiliconCloud为开发者打开了一扇通往AI推理新世界的大门。我们有理由相信,在SiliconCloud的引领下,AI技术将会迎来更加辉煌的未来。

案例分析:SiliconCloud在智能客服领域的应用

以智能客服为例,传统的智能客服系统在处理复杂问题时,往往难以准确理解用户的意图,导致服务质量下降。而基于SiliconCloud的AI模型,智能客服系统可以利用128K的上下文长度,更好地理解用户的上下文信息,从而提供更精准、更个性化的服务。同时,通过独立控制推理链和响应内容的长度,智能客服系统可以根据问题的复杂性,灵活调整推理深度和输出长度,从而提高服务效率和用户满意度。

例如,当用户咨询关于复杂金融产品的问题时,智能客服系统可以利用thinking_budget进行深入的风险评估,然后利用max_tokens生成简洁明了的解答,帮助用户更好地理解产品的特点和风险。同时,如果用户在咨询过程中提供了额外的上下文信息,智能客服系统可以利用128K的上下文长度,将这些信息纳入考虑范围,从而提供更精准的解答。

数据佐证:上下文长度对模型性能的影响

为了验证上下文长度对模型性能的影响,SiliconCloud进行了一系列实验。实验结果表明,随着上下文长度的增加,模型的准确率和召回率均有显著提升。例如,在处理长篇文档分类任务时,当上下文长度从16K增加到128K时,模型的准确率提升了15%,召回率提升了12%。

这些数据充分证明了上下文长度对模型性能的重要性。更长的上下文长度可以帮助模型更好地理解输入文本的含义,从而提高模型的准确性和可靠性。同时,更长的上下文长度还可以帮助模型更好地处理复杂推理任务,从而提高模型的应用价值。

专家观点:AI模型发展的新趋势

多位AI领域专家表示,SiliconCloud的创新设计代表了AI模型发展的新趋势。随着AI技术的不断发展,AI模型将会越来越注重对上下文信息的利用。更长的上下文长度和更精细化的控制机制,将成为AI模型的重要发展方向。同时,AI模型将会越来越注重与实际应用的结合,为各行各业提供更精准、更个性化的服务。