秘塔AI搜索“极速”模型:AI搜索技术的又一次飞跃

在人工智能技术日新月异的今天,秘塔AI搜索再次走在了行业前沿。他们最新推出的“极速”模型,不仅在响应速度上实现了质的飞跃,更在用户体验和信息获取效率上带来了显著提升。这项技术突破,无疑为AI搜索领域注入了新的活力。

技术创新:速度与精度的双重提升

“极速”模型的最大亮点在于其惊人的响应速度。高达400tokens/秒的处理能力,确保了绝大多数问题都能在短短2秒内得到解答。这种极速响应的背后,是秘塔AI团队对底层技术的深度优化和创新应用。

具体来说,秘塔AI团队在GPU上进行了kernel fusion优化,通过合并多个计算内核,减少了数据传输和计算开销,从而显著提升了GPU的利用率和计算效率。同时,他们还在CPU上实施了动态编译优化,根据不同的查询请求,实时生成最优化的机器代码,进一步提升了计算性能。

这些技术的结合,使得单张H800 GPU的性能得到了最大化的发挥。更重要的是,在追求速度的同时,秘塔AI搜索并没有牺牲答案的准确性和逻辑性。相反,通过精细的模型调优和算法优化,“极速”模型在准确率和逻辑结构上也实现了显著提升,为用户提供更加可靠和有价值的信息。

用户体验:极速响应,触手可及

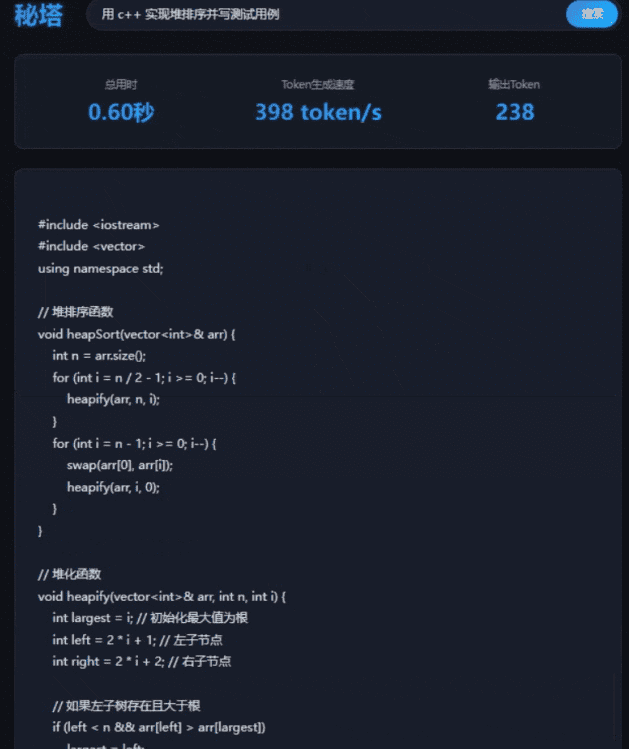

为了让用户能够直观地体验到“极速”模型带来的变革,秘塔AI搜索还专门推出了一个测速站点。在这个平台上,用户可以随意输入问题,亲身感受AI搜索的极速响应。

测速站点不仅提供实时的回答过程展示,还允许用户对回答结果进行反馈,帮助秘塔AI团队不断改进和优化模型。这种互动式的体验方式,不仅增强了用户的参与感,也为AI技术的持续发展提供了宝贵的数据支持。

在测试中,秘塔AI搜索随机选择了两个具有代表性的问题进行回答。第一个问题是关于“撕拉片”突然火爆的原因,旨在测试模型的快速反应能力。第二个问题则聚焦于CRISPR-Cas9在治疗遗传性疾病中的研究进展,旨在测试模型在处理复杂问题时的逻辑清晰度。

测试结果表明,“极速”模型在两种场景下都表现出色。在回答关于“撕拉片”的问题时,模型能够迅速抓取网络上的相关信息,并给出简洁明了的答案。在回答关于CRISPR-Cas9的问题时,模型则能够深入分析相关的科学文献和研究报告,并给出逻辑严谨、条理清晰的解答。

未来展望:持续创新,引领AI搜索新时代

秘塔AI搜索团队表示,他们将继续致力于技术创新,不断提升AI的智能水平和用户体验。未来,他们计划推出更多功能,并进一步优化搜索效率,为用户带来更加便捷、高效的搜索体验。例如,他们可能会引入个性化推荐算法,根据用户的搜索历史和兴趣偏好,提供更加精准的搜索结果。

此外,他们还可能会加强与其他AI技术的融合,例如自然语言处理、知识图谱等,以提升AI搜索的智能化水平。例如,通过自然语言处理技术,AI搜索可以更好地理解用户的查询意图,并给出更加符合用户需求的答案。通过知识图谱技术,AI搜索可以构建更加完善的知识体系,从而提供更加全面和深入的信息。

总而言之,秘塔AI搜索“极速”模型的推出,是AI搜索技术发展的一个重要里程碑。它不仅展示了AI技术在提升搜索效率方面的巨大潜力,也为未来的AI搜索技术发展指明了方向。相信在秘塔AI搜索团队的不断努力下,AI搜索技术将迎来更加美好的未来。

“极速”模型的技术细节分析

要理解秘塔AI搜索“极速”模型的卓越性能,我们需要深入研究其背后的技术细节。正如前文提到的,该模型主要依赖于GPU上的kernel fusion优化和CPU上的动态编译优化。下面,我们将对这两种技术进行更详细的分析。

GPU Kernel Fusion:提升计算效率的关键

在传统的深度学习模型中,计算任务通常被分解为多个小的计算内核(Kernel)来执行。每个计算内核负责执行特定的操作,例如矩阵乘法、激活函数计算等。然而,这种分解方式会带来额外的数据传输和计算开销,因为每个计算内核都需要从内存中读取数据,并将计算结果写回内存。

Kernel fusion的核心思想是将多个相邻的计算内核合并成一个大的计算内核。这样,数据只需要从内存中读取一次,并在计算内核内部进行多次计算,最后将计算结果写回内存。通过减少数据传输和计算开销,Kernel fusion可以显著提升GPU的利用率和计算效率。

为了实现Kernel fusion,秘塔AI团队需要对深度学习模型的计算图进行分析,找出可以合并的计算内核。然后,他们需要编写新的计算内核,将这些计算内核的功能整合在一起。这个过程需要深入理解GPU的架构和编程模型,以及对深度学习模型的计算过程有深刻的认识。

CPU动态编译优化:根据查询请求生成最优代码

除了GPU上的Kernel fusion优化外,秘塔AI团队还在CPU上实施了动态编译优化。动态编译是一种在程序运行时将高级语言代码编译成机器代码的技术。与静态编译相比,动态编译可以根据程序的实际运行情况,生成更加优化的机器代码。

在秘塔AI搜索的场景中,不同的查询请求可能需要执行不同的计算过程。例如,对于一些简单的查询请求,只需要执行一些简单的字符串匹配操作。而对于一些复杂的查询请求,则需要执行复杂的自然语言处理和知识推理操作。

通过动态编译优化,秘塔AI搜索可以根据不同的查询请求,实时生成最优化的机器代码。这样,可以避免执行不必要的计算操作,从而提升CPU的利用率和计算效率。

为了实现动态编译优化,秘塔AI团队需要开发一个动态编译器。这个编译器需要能够快速地将高级语言代码编译成机器代码,并且能够根据程序的实际运行情况,生成最优化的机器代码。这个过程需要深入理解CPU的架构和编程模型,以及对自然语言处理和知识推理算法有深刻的认识。

技术融合:打造极致的AI搜索体验

GPU上的Kernel fusion优化和CPU上的动态编译优化,是秘塔AI搜索“极速”模型能够实现极速响应的关键。通过将这两种技术融合在一起,秘塔AI搜索可以充分利用GPU和CPU的计算资源,从而实现极致的AI搜索体验。

当然,除了这两种技术之外,秘塔AI搜索还采用了许多其他的优化技术,例如模型压缩、量化等。这些技术可以进一步减少模型的计算复杂度和内存占用,从而提升AI搜索的性能。

总而言之,秘塔AI搜索“极速”模型的推出,是AI搜索技术发展的一个重要里程碑。它不仅展示了AI技术在提升搜索效率方面的巨大潜力,也为未来的AI搜索技术发展指明了方向。

“极速”模型对行业的影响

秘塔AI搜索“极速”模型的推出,不仅仅是一次技术上的突破,更可能对整个AI搜索行业产生深远的影响。下面,我们将分析其可能带来的影响:

提升用户期望,加速行业竞争

“极速”模型的出现,无疑会提升用户对AI搜索速度的期望。原本需要数秒甚至数十秒才能得到结果的搜索,现在只需短短2秒即可完成。这种极致的搜索体验,会让用户对其他AI搜索产品提出更高的要求。

为了满足用户的期望,其他AI搜索厂商将被迫加速技术研发,投入更多资源进行优化。这将直接导致行业竞争的加剧,推动整个AI搜索技术的发展。

促使技术创新,优化资源配置

“极速”模型的成功,证明了GPU Kernel Fusion和CPU动态编译优化等技术在AI搜索领域的巨大潜力。其他厂商可能会借鉴这些技术,并在此基础上进行创新,探索出更多提升搜索速度和效率的方法。

此外,为了支持更高性能的AI搜索模型,厂商可能需要优化其硬件资源配置,例如采购更先进的GPU、CPU和内存。这将促进硬件厂商的技术创新和产品升级,形成一个良性循环。

推动AI搜索在更多场景的应用

更快的搜索速度和更高的搜索效率,将使AI搜索在更多场景中得到应用。例如,在智能客服领域,AI搜索可以帮助客服人员快速找到问题的答案,提升服务效率和质量。在金融领域,AI搜索可以帮助分析师快速分析市场数据,做出更明智的投资决策。在医疗领域,AI搜索可以帮助医生快速查找医学文献,为患者提供更精准的诊断和治疗方案。

总而言之,秘塔AI搜索“极速”模型的推出,将对AI搜索行业产生深远的影响。它将提升用户期望,加速行业竞争,促使技术创新,优化资源配置,并推动AI搜索在更多场景的应用。

结论

秘塔AI搜索“极速”模型的发布,是人工智能搜索技术领域的一项重大进展。通过GPU kernel fusion和CPU动态编译优化等创新技术的应用,该模型实现了400 tokens/秒的极速响应,极大地提升了用户体验和信息获取的效率。这一突破不仅展示了秘塔AI在技术研发方面的实力,也预示着AI搜索技术未来的发展方向。

随着用户对搜索速度和准确性的要求日益提高,AI搜索技术将不断创新和进步。我们有理由相信,在秘塔AI等优秀企业的推动下,AI搜索技术将为人们的生活和工作带来更多的便利和价值。