各位AI爱好者、开发者朋友们,大家好!今天我们来聊聊OpenAI连续12天直播发布会的第9天,也就是开发者日,OpenAI为我们带来了哪些激动人心的更新!这次的发布可谓干货满满,不仅有满血版o1模型API的正式推出,还有实时API的全面升级,以及全新的偏好微调技术(PFT)的亮相,简直是给开发者们送上了一份大礼包!

满血版o1模型API正式上线

首先,让我们聚焦于万众期待的o1模型。此前,我们已经体验过集成在ChatGPT中的o1应用版本,而今天,OpenAI终于推出了满血版的o1模型API,这对于开发者来说无疑是一个巨大的好消息。o1模型API不仅具备强大的推理能力,还支持函数调用、结构化输出、开发者消息、推理参数控制以及视觉输入等多种功能,这使得开发者能够更加灵活地将o1模型集成到各种应用场景中。

- 函数调用(Function Calling): o1模型可以与外部API和数据源进行交互,自动选择合适的函数来执行任务。例如,它可以调用外部税率查询函数,实现与现实世界系统的无缝衔接。

- 结构化输出(Structured Outputs): o1模型能够输出符合自定义JSON Schema的结果,确保数据格式一致,方便开发者集成。

- 开发者消息(Developer Messages): 开发者可以通过新型的系统消息精确控制o1模型的行为,例如指定语气、风格或上下文顺序,实现更个性化的模型输出。

- 推理参数控制(reasoning_effort): 开发者可以根据任务的复杂程度控制o1模型的推理时间,从而在简单任务中节省成本,在复杂任务中提升效果。

- 视觉输入(Vision): o1模型支持图片输入,可以应用于错误检测、科学分析等多种场景。

此外,o1模型API的延迟也大幅降低,推理token数消耗比预览版减少了60%,这意味着响应速度更快、成本更低。

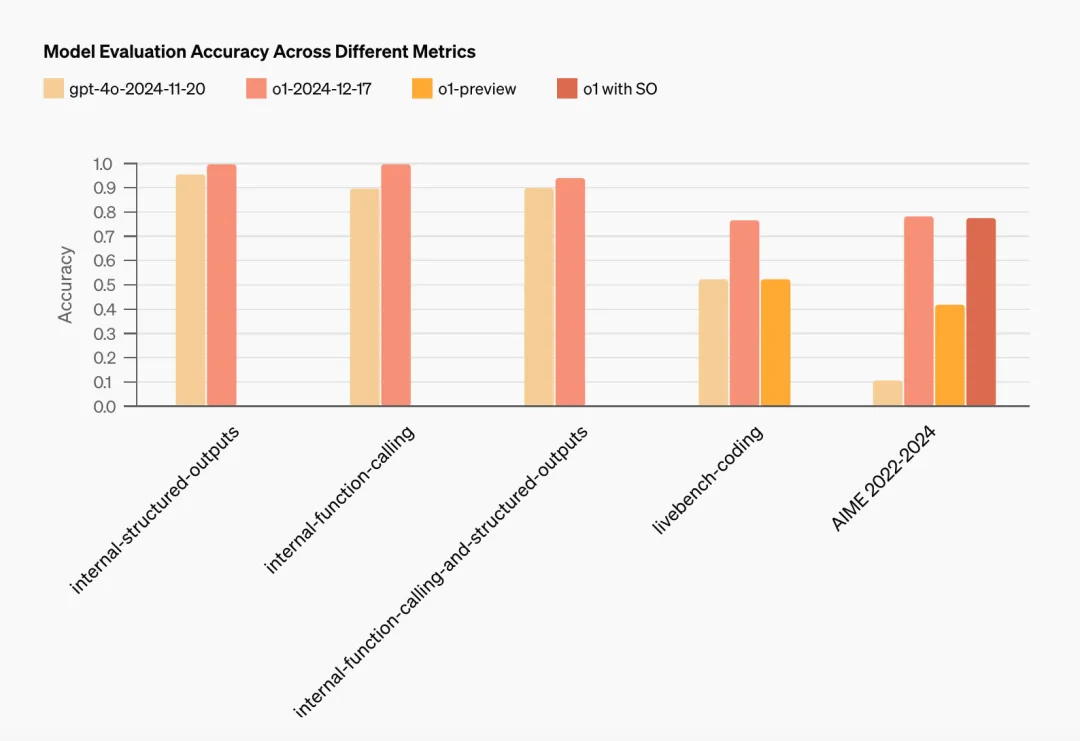

在基准测试中,满血版o1 API(o1-2024-12-17)在多个方面均优于之前的预览版本,尤其是在代码能力、数学能力和视觉能力方面,提升非常显著。不过需要注意的是,o1模型API将优先向账号使用级别为第5层的开发者开放,其他开发者可能还需要等待一段时间。

o1模型API的价格

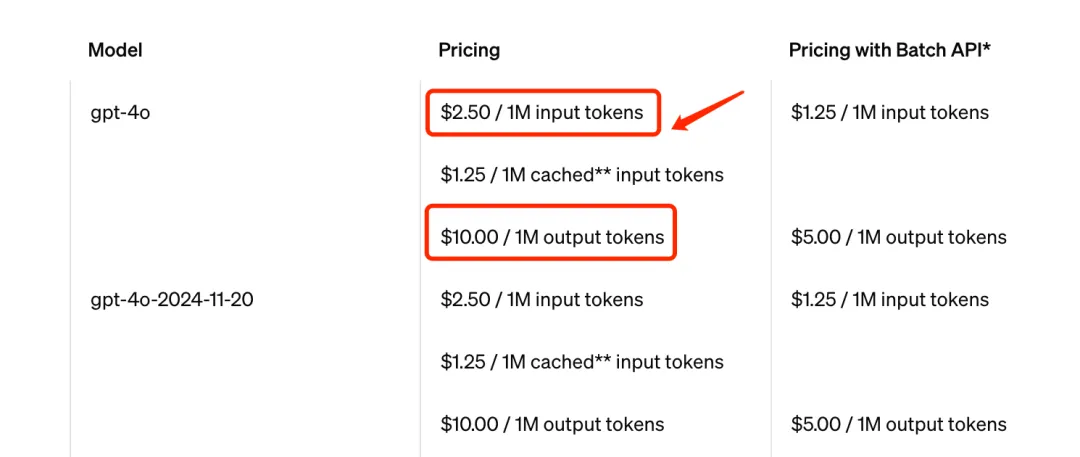

虽然o1模型API功能强大,但价格也相对较高。输入token的价格为每百万tokens 15美元,输出token的价格为每百万tokens 60美元。作为对比,GPT-4o的API价格分别为每百万tokens 2.5美元(输入)和10美元(输出),仅为o1的六分之一。所以,选择哪个模型,还需要根据实际需求和预算来权衡。

实时API全面升级,WebRTC集成

除了o1模型API,本次发布会的另一个亮点是实时API的全面升级。实时API旨在为开发者提供低延迟、自然流畅的交互体验,非常适合应用于语音助手、实时翻译工具、虚拟导师等场景。

此次升级,最值得关注的是WebRTC的集成。WebRTC是一种开放标准,可以简化跨平台实时语音产品的构建与扩展,无论是在浏览器应用、移动端App、物联网设备还是服务器之间,都能实现流畅的实时语音通信。WebRTC的集成能够确保在真实世界网络条件下提供稳定、响应迅速的交互体验,即使在网络质量不佳的情况下也能正常工作。开发者只需要12行JavaScript代码,就可以轻松添加实时语音功能。

实时API价格

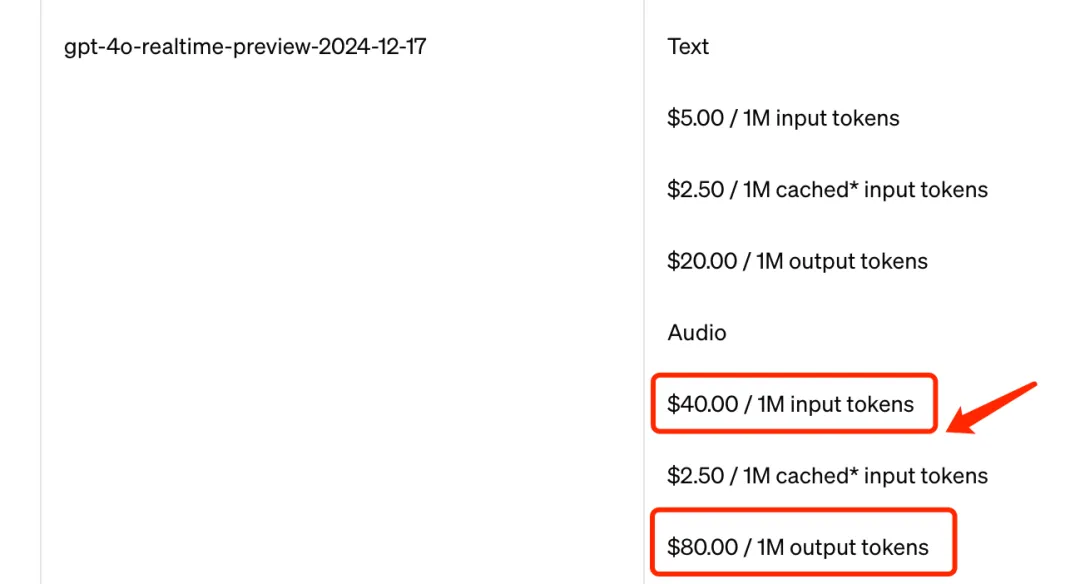

实时API目前提供GPT-4o和GPT-4o mini两个版本。其中,GPT-4o实时API的最新版本(gpt-4o-realtime-preview-2024-12-17)价格大幅降低,每百万输入和输出tokens价格分别为40美元和80美元,相比之前的100美元和200美元,音频token价格降低了60%。

同时,OpenAI还推出了实时API的小模型gpt-4o-mini-realtime-preview-2024-12-17,目前处于Beta版本,主打质量和成本的平衡。GPT-4o mini实时API价格为每百万的输入和输出token分别对应10美元和20美元。

实时API功能增强

此次实时API的升级还包括以下增强功能:

- 并行后台响应(Concurrent out-of-band responses): 支持后台任务与语音交互并行执行。

- 自定义输入上下文 (Custom input context): 开发者可以灵活选择模型输入内容。

- 响应时机控制(Controlled response timing): 结合服务器端语音活动检测,实现更精准的语音回复控制。

- 最大会话时长(Increased maximum session length): 从15分钟延长至30分钟。

偏好微调(Preference Fine-Tuning)技术亮相

本次发布会,OpenAI还首次推出了偏好微调(PFT)技术。这项技术使用直接偏好优化(DPO)算法,通过比较模型生成的不同响应,让模型学习人类偏好,而非依赖精确的输入-输出对。偏好微调特别适用于那些“更好”响应带有主观性的任务,例如创意写作或摘要任务。

与传统的监督微调(SFT)相比,偏好微调能够更好地优化模型的行为,强化优选响应,减少非优选响应的可能性。OpenAI表示,他们已经与一些受信任的合作伙伴测试了偏好微调技术,并取得了显著的成果。

目前偏好微调优先支持gpt-4o-2024-08-06模型,很快也将支持gpt-4o-mini-2024-07-18。训练token的价格与监督微调相同,更多新模型的支持计划将在明年初推出。

如何使用偏好微调?

偏好微调功能已在OpenAI的开发者后台开放,开发者可以在Dashboard-Fine-tuning中新建微调模型,并在Method中选择“Direct Preference Optimization”即可开始使用。

总结

总的来说,OpenAI开发者日的这次发布,为开发者们带来了许多令人兴奋的新功能和技术。无论是满血版o1模型API的正式上线,还是实时API的全面升级,亦或是偏好微调技术的首次亮相,都充分展现了OpenAI在人工智能领域的创新能力和技术实力。相信这些新功能和技术的应用,将为开发者们带来更多的可能性,也将会推动人工智能技术在各个领域的应用发展。