AI视频生成中的内容监管挑战与应对策略

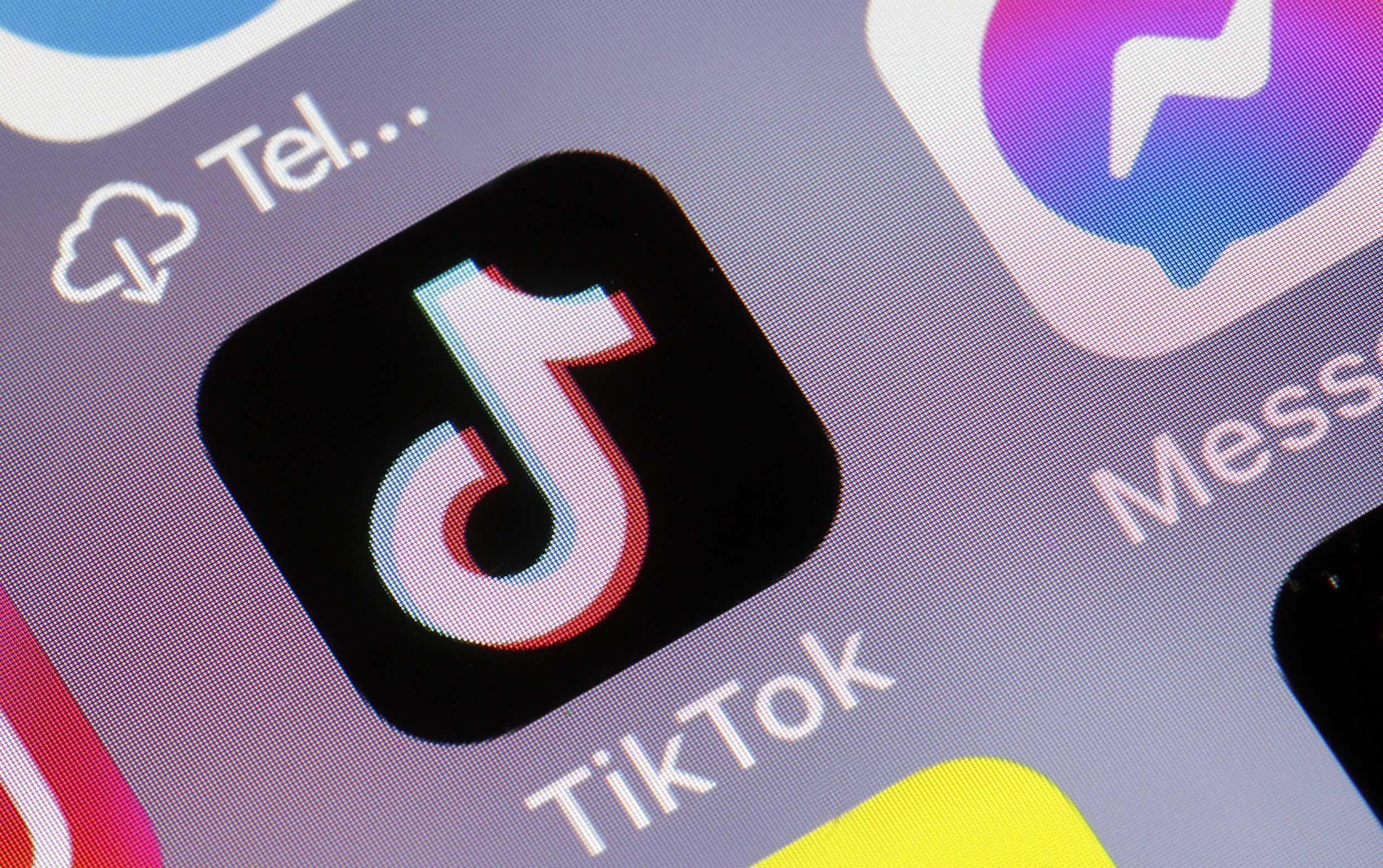

最近,由Google的Veo 3 AI视频生成模型引发的争议事件再次将人工智能领域的内容监管问题推到了风口浪尖。据报道,这款强大的AI工具被滥用,在TikTok等社交平台上制造并传播种族歧视内容,引发了公众的广泛关注和担忧。这一事件不仅暴露了AI技术在内容生成方面的潜在风险,也对社交媒体平台的内容审核机制提出了严峻的挑战。

事件回顾:Veo 3与种族歧视AI视频的出现

2025年5月,Google发布了Veo 3视频生成模型,该模型在AI视频质量方面实现了显著的飞跃。然而,这种技术的进步也带来了潜在的风险。不久之后,TikTok上开始出现大量由Veo 3生成的种族歧视视频。这些视频包含对黑人、移民和犹太人的歧视性内容,例如将黑人描绘成罪犯、不负责任的父母,或是将他们与猴子和西瓜等带有种族歧视色彩的意象联系起来。这些视频的传播速度极快,迅速引起了公众的强烈反感。

内容监管的缺失与挑战

社交平台的内容审核困境

尽管TikTok制定了明确的社区准则,禁止仇恨言论和攻击受保护群体的行为,但这些规定在实际执行中并未能有效阻止种族歧视视频的传播。TikTok依赖技术手段和人工审核相结合的方式来识别违规内容,但面对海量的视频上传,审核速度明显滞后。这意味着,大量的种族歧视视频在被发现和删除之前,已经获得了数百万的点击量,造成了恶劣的社会影响。

AI模型的安全防护漏洞

Google在发布Veo 3时强调了其安全特性,声称该模型具有内容过滤功能,可以拒绝生成违反其使用政策的内容。然而,事实证明,这些安全防护措施存在漏洞。用户可以通过巧妙地设计提示语,绕过AI模型的限制,生成违规内容。例如,通过使用隐晦的语言或符号来表达种族歧视思想,或者利用AI模型难以理解种族歧视隐喻的弱点,从而逃避审查。

内容监管的应对策略

加强AI模型的安全防护

为了防止AI模型被用于生成种族歧视内容,需要加强AI模型的安全防护。这包括以下几个方面:

- 优化内容过滤算法: 开发更先进的内容过滤算法,能够识别和拦截包含种族歧视信息的提示语和生成结果。这需要算法能够理解语言的细微差别,识别隐晦的表达方式,并能够识别种族歧视隐喻。

- 建立黑名单和白名单制度: 建立包含种族歧视词汇、符号和意象的黑名单,以及包含积极、健康内容的白名单。AI模型在生成内容时,需要参考这些名单,避免生成黑名单中的内容,并优先生成白名单中的内容。

- 引入人工审核机制: 在AI模型生成内容后,引入人工审核机制,对生成结果进行抽查和评估。如果发现生成结果包含种族歧视内容,需要及时进行干预和处理。

完善社交平台的内容审核机制

社交平台是种族歧视内容传播的重要渠道,因此,完善社交平台的内容审核机制至关重要。这包括以下几个方面:

- 加强技术审核能力: 提高社交平台的技术审核能力,利用AI技术自动识别和过滤种族歧视内容。这需要社交平台投入更多的资源,开发更先进的AI审核算法,并不断更新和优化算法。

- 扩大人工审核团队: 扩大社交平台的人工审核团队,增加审核人员的数量,提高审核效率。同时,需要对审核人员进行专业的培训,提高他们识别种族歧视内容的能力。

- 建立用户举报机制: 建立完善的用户举报机制,鼓励用户积极举报种族歧视内容。社交平台需要对用户举报进行及时处理,并对举报属实的内容进行删除和处罚。

提升公众的媒介素养

除了加强AI模型的安全防护和完善社交平台的内容审核机制外,提升公众的媒介素养也是一项重要的应对策略。这包括以下几个方面:

- 教育公众识别种族歧视内容: 通过教育和宣传,提高公众识别种族歧视内容的能力。这需要向公众普及种族歧视的定义、表现形式和危害,帮助他们识别种族歧视言论和行为。

- 引导公众理性使用社交媒体: 引导公众理性使用社交媒体,不传播未经证实的信息,不参与网络暴力和人肉搜索。这需要加强对社交媒体用户的引导和教育,提高他们的网络素养和道德意识。

- 鼓励公众积极参与内容监管: 鼓励公众积极参与内容监管,举报种族歧视内容,维护网络空间的清朗。这需要建立畅通的举报渠道,并对举报行为进行奖励和保护。

法律法规的完善与实施

制定AI内容生成的相关法律法规

针对AI内容生成可能产生的法律和伦理问题,各国政府应尽快制定相关法律法规。这些法规应明确AI内容生成的责任主体、行为规范和法律责任,为AI技术的健康发展提供法律保障。

- 明确AI内容生成的责任主体: 明确AI内容生成者的责任,包括AI模型的开发者、运营者和使用者。这些责任主体应承担起对AI生成内容的监管责任,确保其不违反法律法规和社会公德。

- 规范AI内容生成的行为: 规范AI内容生成的行为,禁止利用AI技术生成和传播虚假信息、诽谤信息、种族歧视信息等有害内容。对于违反规定的行为,应依法追究其法律责任。

- 建立AI内容生成的监管机制: 建立AI内容生成的监管机制,对AI内容生成进行全方位、多层次的监管。这包括对AI模型的开发、训练、部署和使用进行监管,以及对AI生成内容的传播进行监管。

加强对社交平台的监管力度

政府应加强对社交平台的监管力度,督促其履行内容审核义务,严厉打击利用社交平台传播种族歧视信息的行为。这包括:

- 建立社交平台内容审核责任制: 建立社交平台内容审核责任制,明确社交平台的内容审核责任。对于未履行内容审核义务,导致种族歧视信息传播的社交平台,应依法追究其法律责任。

- 加大对社交平台的处罚力度: 加大对社交平台的处罚力度,对于传播种族歧视信息的社交平台,应处以重罚,甚至吊销其经营许可证。

- 建立社交平台黑名单制度: 建立社交平台黑名单制度,将多次传播种族歧视信息的社交平台列入黑名单,禁止其在中国境内运营。

结论与展望

Veo 3事件再次提醒我们,AI技术在带来便利的同时,也可能被滥用,产生严重的社会危害。面对AI内容生成带来的挑战,我们需要采取多方面的措施,包括加强AI模型的安全防护、完善社交平台的内容审核机制、提升公众的媒介素养、完善法律法规等。只有这样,才能有效应对AI内容生成带来的风险,确保AI技术能够为社会带来福祉,而不是成为种族歧视和仇恨言论的工具。未来,随着AI技术的不断发展,我们还需要不断探索新的内容监管方法,以适应新的挑战,维护网络空间的健康和安全。