在人工智能领域,语音技术正经历着前所未有的变革。曾经被视为鸡肋的语音助手,如今正以全新的姿态重回大众视野。大量的资金涌入、科技巨头的加持、以及创业公司的创新,共同推动着AI语音技术的快速发展。本文将深入探讨AI语音爆发的逻辑、面临的挑战以及未来的发展趋势。

AI语音爆发的逻辑:大模型赋予声音“可编程化”

过去半年,AI语音领域获得了前所未有的关注和投资。Wispr Flow、Cartesia、ElevenLabs等公司纷纷获得巨额融资,这背后是大模型技术的突破。

大模型让声音这项基础能力首次实现了“可编程化”。这意味着声音不再仅仅是一种输入或输出的介质,而是可以被代码自由地调用、组合、修改和控制。过去,文字、图像、视频等都可以被编程,但声音却难以被软件直接“编程”和“理解”。传统的语音识别,更多的是把声音转换成文字,然后对文字进行处理。

以前,自然语言处理(NLP)的背后需要大量的人工标注,让AI系统能够识别每个句子的意向。语音的开发,每增加一个功能,都需要从头写代码,费时费力。例如,想让智能音箱支持“点外卖”,需要单独开发一套语音识别和语义逻辑,成本高、周期长。

而现在,AI大模型可以解决这些问题。大模型对多模态数据的深度理解能力,对声学信号的细致解析,使得声音本身携带的除了文字信息之外的更多信息,开始被AI系统直接捕捉、理解和“编程”。

这种可编程化,意味着AI可以像处理数据一样处理声音。它可以分析声音的频率、振幅、波形,提取出情绪特征、识别不同的声源、声源距离、甚至预测用户的意图。这时,声音包含的不再仅仅是“你说了什么”,更是“你如何说”、“你在哪里说”、“谁在说”以及“你说了之后希望发生什么”。由此,声音也成为了真正的交互引擎。

语音交互的未来:从“Voice”到“Sound”

很多人以为,语音交互就是“Voice”(语音)。但真正的语音交互,核心不是“Voice”,而是“Sound”(声音)。“Sound”包含了更丰富的元素:语调、音色、节奏、情绪,更重要的是环境音。

环境音里面可能包含了环境中的各种非语音信息,比如背景音乐、环境噪音(风声、雨声、车声)、物体发出的声音(开门声、打字声)、以及人类语音中包含的非语义信息(语调、语速、音色、语气词、叹息声、笑声、哭声等)。例如,你咳嗽的时候,跟AI说话,它可能会识别出咳嗽,然后跟你说多喝水;比如,你在咖啡馆说,“帮我找个安静的地方”,AI不仅要理解你的指令,还要从背景音中判断出你当前的环境嘈杂,从而推荐附近的图书馆。

AI系统将不再仅仅依赖于识别用户说的“词”,而是能够全面感知和理解用户所处环境的“声学场景”中的所有关键元素。只有当AI能够全面感知并解析“Sound”中包含的这些多维度信息时,它才能真正理解用户的深层需求,提供更精准、更个性化、更富有情感的交互。这才是真正的“语音交互”,它不仅仅是“听懂”字面意思,更是“听懂”你的“言外之意”和“心声”。

语音交互的挑战:声学技术的“卡点”

尽管大模型带来了语音交互的巨大飞跃,但语音交互当下依然存在一个核心的“卡点”,那就是声学。我们常说“听清、听懂、会说”。“听懂”和“会说”的能力,正在被大模型以前所未有的速度提升。但“听清”这个最基础的环节,却受到物理层面的制约。如果AI听不清你的指令,即便它能“听懂”再复杂的语义,能“会说”再动听的话语,那也都是空中楼阁。

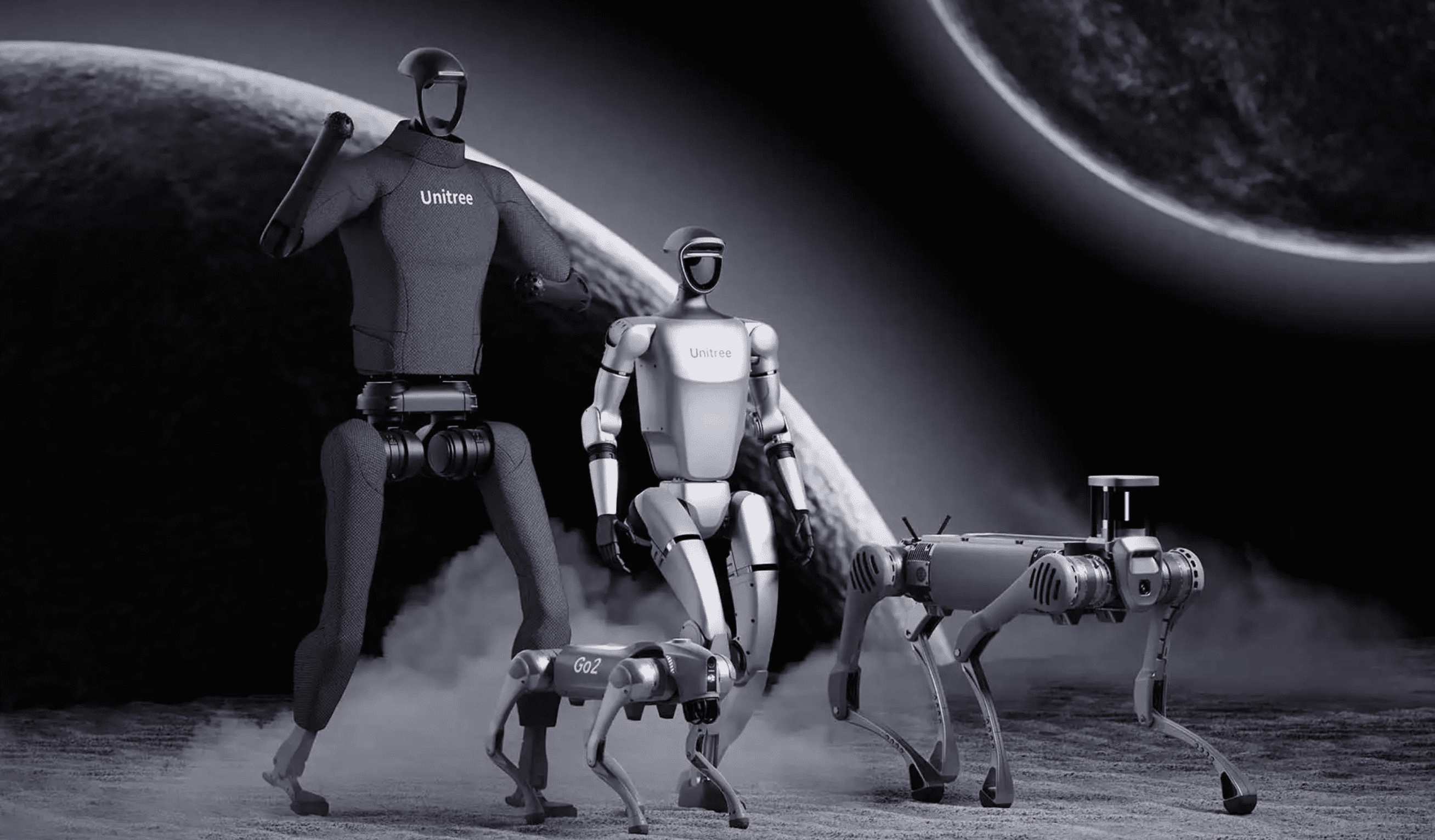

当下最热门的具身智能,面临着电路噪声、关节噪声等问题,尤其在室外,更难听清楚人的指令。因此,现在很多机器人都要靠遥控器来控制。

这方面,就需要对声学层面的突破,比如说环境噪声的抑制,比如电路底噪的抑制,还有啸叫的抑制、混响回响的抑制等等。而这些就是物理学科的逻辑,它需要数据样本,需要know-how的壁垒,不仅是技术问题,而是时间的问题,需要时间去采集声音、做训练。这不是烧钱能解决的。让AI准确地“听清”用户的指令,依然是一个世界级的难题。而声学相关的人才很少,所以像谷歌、微软、苹果经常会收购声学技术的初创公司。

要构建真正的下一代人机交互系统,拥有核心的声学能力是基石。

语音交互的未来:实现“共情”

现在很多AI应用的日活、留存不高,有个很大的原因就是普通人本身是不会提问的,让人向大模型提问,这本身就是一个非常高的交互门槛。好的提问还需要学识、表达等基础,所以停留在文字层面的问答,本身就是一种门槛限制。

而语音带来的一种可能性是,它正在开启一个全新的阶段——人机交互的“共情模式”。如果把语音交互比作一个“UI界面”,那这个界面会长什么样?我们可以做个推演,它的构成要素可能会有:

- 情绪识别:AI通过分析语调、音量、语速,判断用户的情感状态。比如,你的声音颤抖,AI可能推测你在紧张或伤心。

- 意图理解:不仅听懂你说了什么,还要明白你想做什么。比如,你说“播放音乐”,AI会根据你的情绪,决定是放摇滚还是古典。

- 声纹识别:通过独一无二的音声波特征,区分不同用户。比如,家里的智能音箱能自动切换到“孩子模式”模式,只为孩子的声音提供安全的回应。

- 情绪生成:AI的回应需要带有情感化的表达。比如,用温暖的语气说“别担心,我来帮你解决”,而不是机械的“好的,正在处理”。

这些要素的背后,是AI从“功能导向”到“情感导向”的转变,AI会与人实现共情。这种交互,能显著提升长时间交互的质量和亲密感。

不仅如此,从狭义的“Voice”拓展到广义的“Sound”,当AI能接收到的不仅仅是用户的指令,而是整个物理世界的实时反馈时,我们可以去构建一个“声学世界模型”。这个“声学世界模型”可以理解声音在物理世界中产生、传播和交互的根本规律,它不仅要“听清”和“听懂”,更要具备“声学常识”和“声学推理”的能力:它能从一声闷响中分辨出是书本落地还是箱子倒塌;能通过回声判断出房间的大小与空旷程度;更能理解“脚步声由远及近”背后所蕴含的物理运动逻辑。

未来,当这样一个声学世界模型与视觉、语言大模型深度融合时,具身智能机器人将不再“失聪”和冰冷。

结论

AI语音技术正在经历一场深刻的变革。从最初的语音识别到如今的“声学世界模型”,AI正在以惊人的速度理解和模拟人类的听觉能力。未来,随着技术的不断进步,AI语音将会在人机交互、智能家居、医疗健康等领域发挥更大的作用。