在人工智能领域,大型语言模型(LLM)的创新层出不穷。近日,月之暗面(Moonshot AI)开源了其Kimi系列的新成员——K2模型,再次引发了业界的广泛关注。这款模型不仅拥有强大的代码和Agent能力,更采用了混合专家(MoE)架构,总参数高达1T,激活参数为32B,在通用知识推理、编程、数学和Agent等多个基准测试中表现出色,超越了其他主流开源模型。K2的上下文长度达到128k,支持ToolCalls、JSON Mode、Partial Mode以及联网搜索等功能,为开发者和研究者提供了强大的工具。值得一提的是,K2模型分为两个版本:Kimi-K2-Base基础模型,适合后续研究和定制化开发;Kimi-K2-Instruct指令微调模型,能直接用于通用聊天和智能体场景。

K2的核心功能剖析

K2模型在多个关键领域展现出卓越的性能,这得益于其独特的设计和训练方法。

首先,在代码能力方面,K2经过专门优化,能够胜任复杂的代码生成、调试、解释和跨语言转换任务。无论是快速生成代码片段,还是理解和修改现有代码库,K2都能提供强大的支持。这意味着开发者可以更高效地完成编程任务,将更多精力投入到创新和解决实际问题上。

其次,K2的Agent能力同样不容小觑。它支持多步骤工具调用(ToolCalls),能够自主规划并执行任务链,例如数据查询、API调用和文件操作等。这种能力使得K2可以作为一个智能代理,自动完成各种复杂的任务,极大地提高了工作效率。

此外,K2在数学和逻辑推理方面也表现出色。在数学竞赛题(如AIME)、逻辑谜题和科学计算中,K2的性能优于主流开源模型。这意味着K2不仅可以用于日常的编程和Agent任务,还可以应用于更高级的科学研究和工程计算领域。

K2的技术特性深度解读

K2模型的技术特性是其卓越性能的基础。MoE架构、超长上下文长度和专注文本处理的特性,共同塑造了K2的独特优势。

MoE架构是K2的核心技术之一。该架构的总参数达到1万亿,但激活参数仅为320亿,实现了性能与效率的平衡。MoE架构通过将模型分解为多个专家子模型,并根据输入选择合适的专家进行处理,从而在保证性能的同时,降低了计算成本。这意味着K2可以在各种硬件平台上高效运行,为更广泛的应用场景提供了可能性。

上下文长度是衡量语言模型处理长文本能力的重要指标。K2的上下文长度为128K tokens(约25万汉字),使其能够处理长文档分析或长对话。这意味着K2可以一次性处理大量的文本信息,从而更好地理解上下文关系,生成更准确、更连贯的回复。

此外,K2是一个非视觉模型,专注于文本处理。这意味着K2在处理文本任务时具有更高的效率和准确性。虽然K2不支持图片理解,但在需要处理图像的场景中,可以使用Kimi-latest-vision模型进行替代。

K2的性能表现与市场定位

在自主编程(Agentic Coding)、工具调用(Tool Use)和数学推理(Math & Reasoning)三项关键能力上,Kimi K2已超越DeepSeek-V3-0324与Qwen-235B-A22B等知名模型,但与Claude 4 Opus和GPT-4.1等顶级闭源模型相比,仍存在一定的差距。尽管如此,K2的开源策略无疑为广大开发者和研究者提供了一个强大的工具,有助于推动人工智能技术的普及和发展。

K2的开源,不仅降低了使用先进语言模型的门槛,也为模型的进一步优化和改进提供了机会。通过社区的共同努力,K2有望在未来赶超甚至超越顶级闭源模型,成为人工智能领域的领导者。

如何高效使用K2模型

要充分利用K2模型的强大功能,可以采取以下步骤:

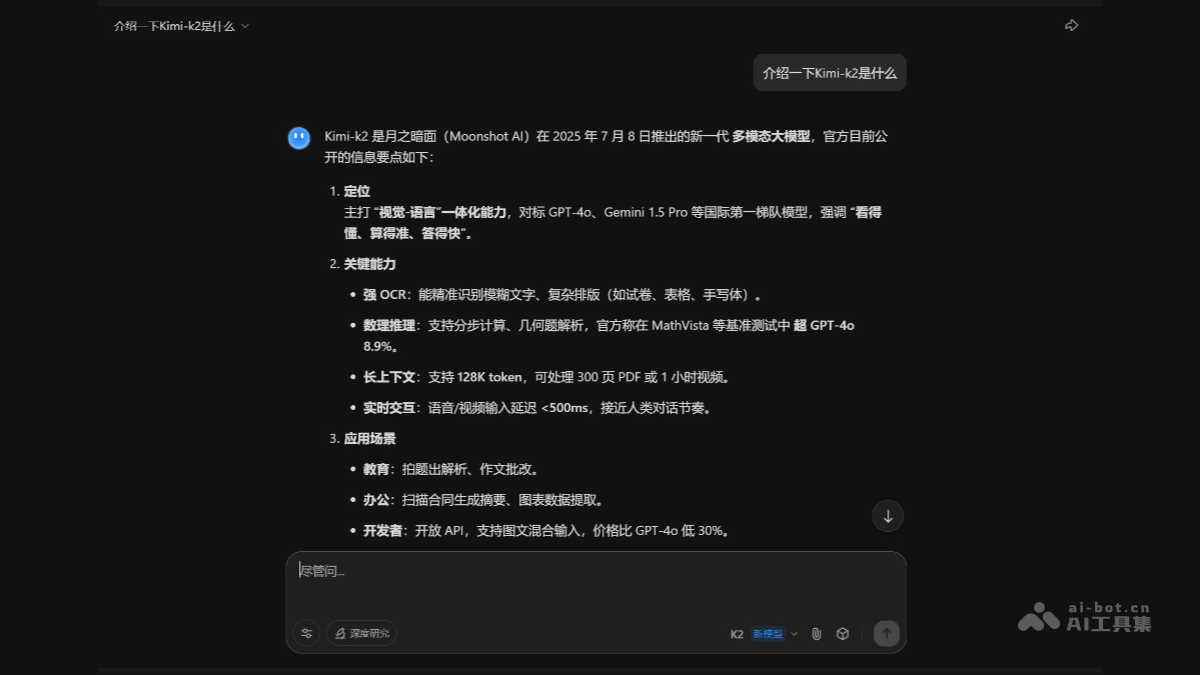

首先,访问Kimi智能助手的官方网站。Kimi智能助手默认选择使用K2模型,用户可以直接在网站上体验K2的各项功能。通过与Kimi智能助手进行交互,用户可以了解K2在不同场景下的表现,并探索其潜在的应用价值。

其次,获取API密钥。用户需要在Moonshot AI开放平台注册并登录,然后进入“API密钥”页面,创建并复制密钥。API密钥是访问K2模型的重要凭证,用户需要妥善保管,避免泄露。

K2的应用场景展望

K2模型的应用场景非常广泛,几乎涵盖了所有需要处理文本信息的领域。

在代码与软件开发方面,K2专为复杂代码任务设计,支持一次性阅读上万行源码或整份需求文档,生成完整项目骨架。这意味着开发者可以利用K2快速搭建项目框架,减少重复性工作,提高开发效率。

在智能Agent与流程自动化方面,K2支持理解自然语言指令,自主调用数据库、文件系统、邮件或内部API,完成多步骤业务闭环。这意味着企业可以利用K2实现各种业务流程的自动化,例如自动处理订单、自动回复邮件等,从而降低运营成本,提高服务质量。

在数学推理与科研辅助方面,K2在AIME、MATH等基准上领先主流开源模型。用户可一次性输入整篇论文、竞赛题或复杂公式,模型会给出分步推导、可复现的Python/JAX/PyTorch实验脚本,输出可直接插入论文的LaTeX推导过程。这意味着科研人员可以利用K2加速研究进程,发现新的科学规律。

此外,K2还可以应用于文本洞察领域。法务、审计、运维团队可以用K2模型快速完成协议对比、合规检查或故障定位。这意味着企业可以利用K2提高风险管理能力,保障业务合规运营。

K2的测试案例分析

为了更好地展示K2的功能,月之暗面提供了多个测试案例。

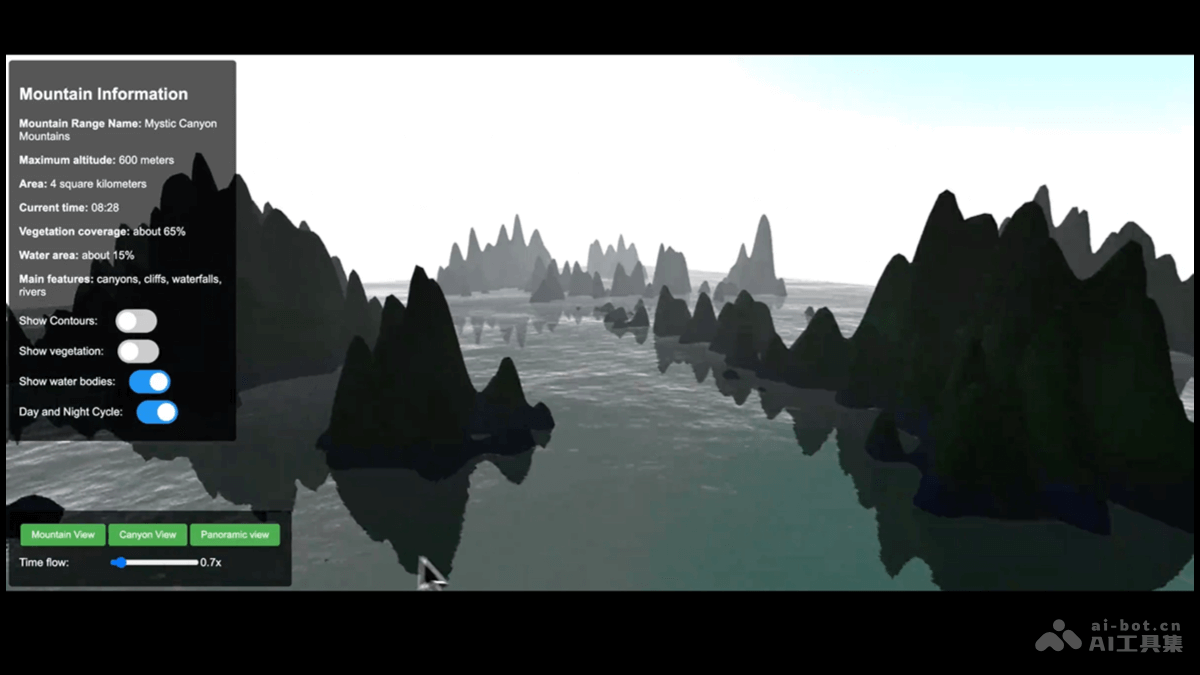

案例一:3D HTML山脉场景

用户可以使用以下Prompt:

"Create a 3D HTML mountain scene with cliffs, rivers, and day-night lighting. Supports drag/zoom, animated transitions, realistic gradients, and toggleable contour lines… (创建一个3D HTML山脉场景,包含悬崖、河流和昼夜光照变化。支持拖动和缩放、动画过渡、真实感渐变色,并可切换等高线显示…)"

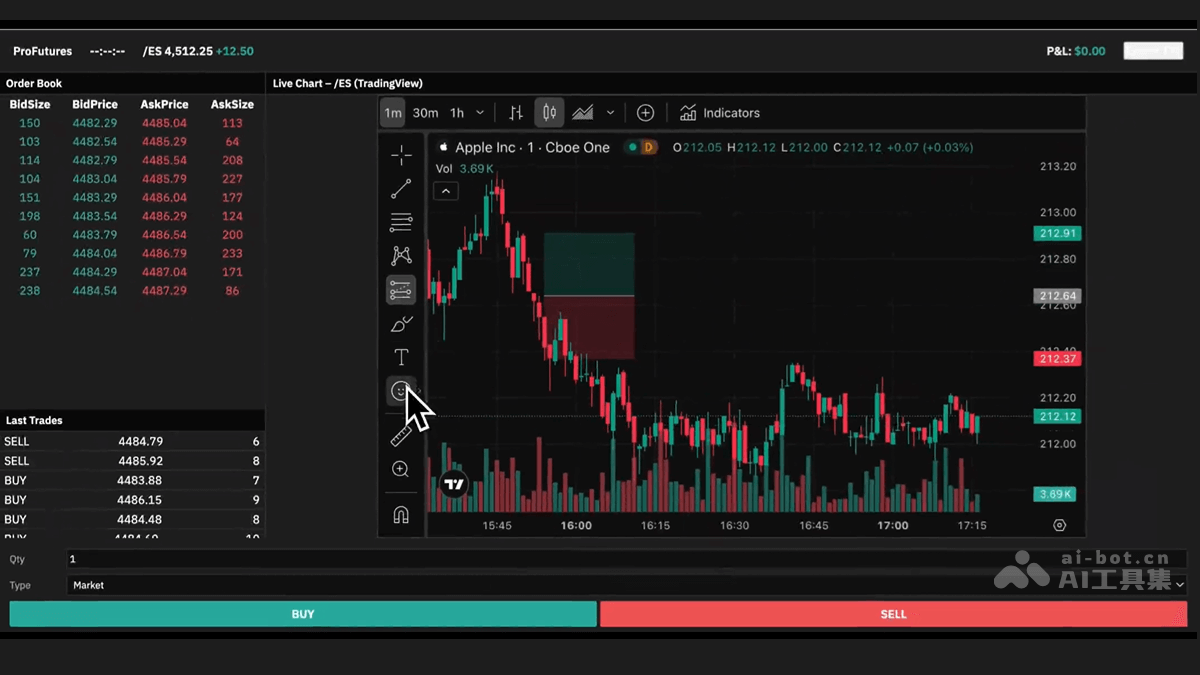

案例二:期货交易模拟器

用户可以使用以下Prompt:

"Create a HTML!! an immersive browser-based futures trading simulator with professional-grade UI/UX using modern JavaScript libraries. Focus on real-time visualizations and interactive trading mechanics.(创建一个基于HTML的沉浸式浏览器期货交易模拟器,使用现代JavaScript库,具备专业级UI/UX设计。重点实现实时可视化和交互式交易机制。)"

K2的模型定价策略

K2模型的定价策略如下:

| 模型版本 | 上下文长度 | 输入价格(缓存命中) | 输入价格(缓存未命中) | 输出价格 |

|---|---|---|---|---|

| kimi-k2-0711-preview | 128 K tokens | ¥1.00 / 百万 tokens | ¥4.00 / 百万 tokens | ¥16.00 / 百万 tokens |

计费说明:

- 1M tokens = 1,000,000 tokens

- 缓存命中:如果请求内容在系统缓存中已有,输入部分按**¥1.00/百万 tokens**计费

- 缓存未命中:全新或未被缓存的内容,输入部分按**¥4.00/百万 tokens**计费

- 输出部分:无论是否缓存,统一按**¥16.00/百万 tokens**计费

- 上下文长度:单次请求最大支持131,072 tokens(≈25万汉字)

如何获取K2模型资源

用户可以通过以下途径获取K2模型资源:

- 项目官网:Kimi智能助手

- HuggingFace模型库:https://huggingface.co/moonshotai/Kimi-K2-Instruct

- 技术论文:https://moonshotai.github.io/Kimi-K2/