在国产 AI 领域,DeepSeek 绝对是一个独特的存在。它不像 Kimi 和豆包那样铺天盖地地打广告,但却凭借强大的基座模型,在用户中赢得了极佳的口碑。DeepSeek 专注于 AI 模型底层技术的研究,低调务实,甚至被海外用户誉为 “来自东方的神秘力量”。最近,DeepSeek 又推出了最新通用模型 DeepSeek V3,再次引发了广泛关注。

DeepSeek:低调务实的 AI 力量

DeepSeek 是一家专注于 AI 模型底层技术的公司,它几乎没有任何广告宣传,完全依靠口口相传。DeepSeek 的产品也十分简洁,甚至有些简陋,但其在模型方面的实力却不容小觑。

DeepSeek 不仅打响了国内大模型价格战的第一枪,还陆续发布了通用模型 DeepSeek V2、DeepSeek V2.5 以及最新的 DeepSeek V3。此外,DeepSeek 还发布了一系列视觉模型和一个推理模型 DeepSeek-R1-Lite,后者被认为是国内首个对标 o1 的推理模型。

DeepSeek V3:性能卓越的通用模型

DeepSeek V3 是昨天刚刚正式发布并开源的通用模型,它在技术指标和基准测试中都展现出了卓越的性能。

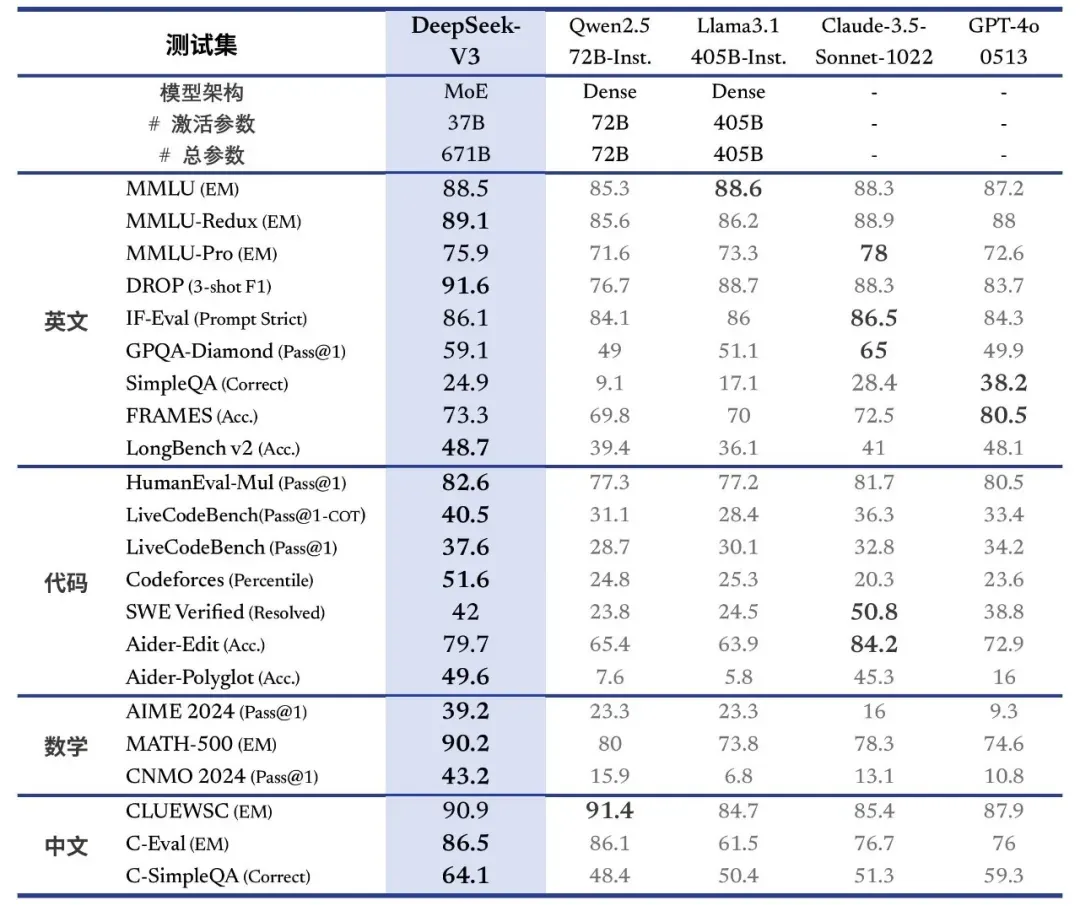

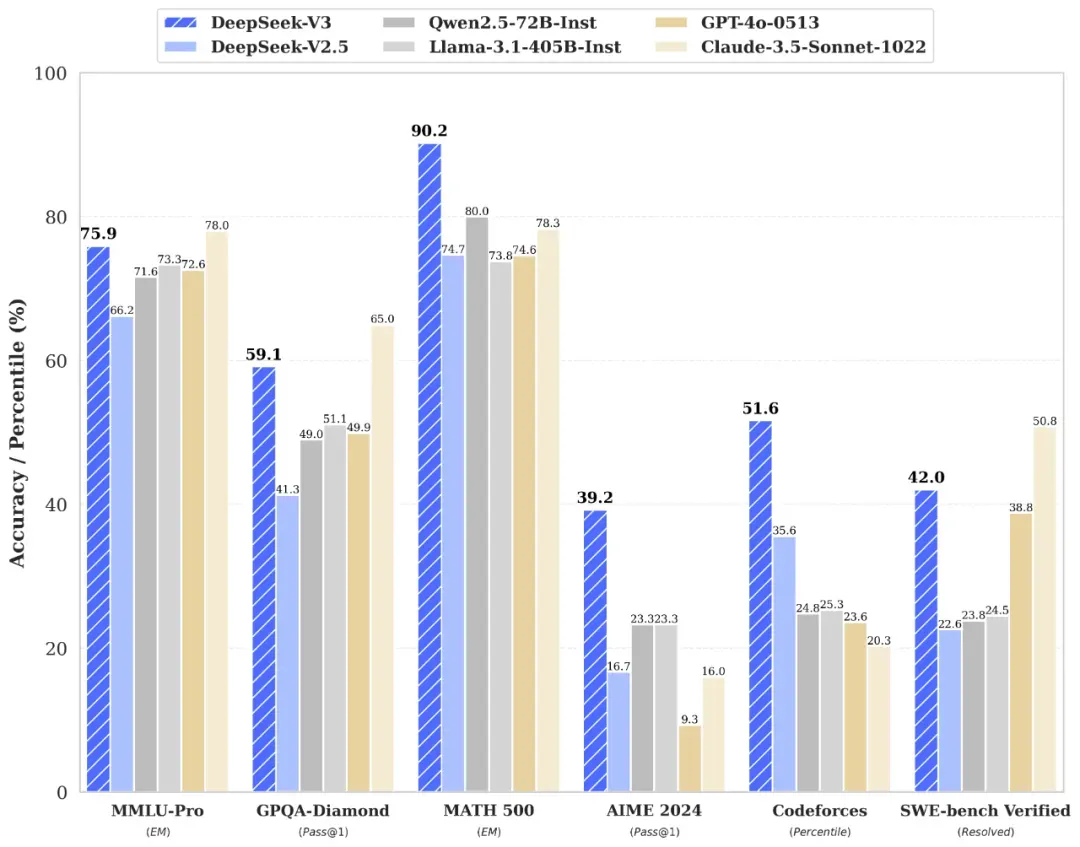

- MoE 架构: DeepSeek V3 采用了自主研发的 MoE (Mixture-of-Experts) 架构,模型参数高达 671B,激活参数为 37B。这意味着在实际推理过程中,每个 token 仅激活其中的 37B 参数,在保证性能的同时提升了推理效率。

- 超大规模参数: DeepSeek V3 的 671B 参数量远超开源模型中的王者 Llama 3.1 的 405B。

- FP8 混合精度训练: DeepSeek V3 在训练过程中使用了 FP8 混合精度训练,并在如此超大规模的模型上验证了 FP8 训练的可行性和有效性。

- 高效训练: 通过算法、框架和硬件层面的协同设计,DeepSeek V3 克服了跨节点 MoE 训练中的通信瓶颈,实现了近乎完全的计算与通信重叠,从而提高训练效率的同时,大幅降低了训练成本。DeepSeek V3 最终在 14.8 万亿 tokens 的数据集上完成了预训练,仅消耗 266 万 H800 GPU 小时。

基准测试表现:实力不俗

DeepSeek V3 在基准测试中的表现也十分亮眼:

- 超越开源模型: DeepSeek V3 成功超越了 Qwen2.5-72B 和 Llama-3.1-405B 这两个开源模型。

- 媲美闭源模型: 在闭源模型方面,DeepSeek V3 与 GPT-4o (0513 版本) 以及 Claude-3.5-Sonnet 打得有来有回。

- 代码能力突出: DeepSeek V3 的代码能力几乎可以和以代码能力著称的 Claude-3.5-Sonnet 相媲美。

- 推理速度提升: DeepSeek V3 的生成速度从 20TPS 大幅提高至 60TPS,相较前代模型 2.5 实现了 3 倍提升。

如何使用 DeepSeek V3

您可以通过以下方式体验 DeepSeek V3 模型:

- DeepSeek 官网: https://chat.deepseek.com/ (在线体验,支持联网搜索和推理模式)

- DeepSeek 开发者平台: https://platform.deepseek.com/ (API 调用,适合有定制化需求的用户)

- DeepSeek V3 GitHub 仓库: https://github.com/deepseek-ai/DeepSeek-V3 (本地部署,适合对性能、安全性和隐私有高要求的用户)

- DeepSeek V3 抱抱脸链接: https://huggingface.co/deepseek-ai/DeepSeek-V3-Base

DeepSeek V3 的 API 价格为每百万输入 tokens 2 元(缓存未命中),每百万输出 tokens 8 元,单位均为人民币,明年 2 月 8 日前有优惠。

结语

DeepSeek V3 的发布再次证明了国产 AI 的实力。DeepSeek 凭借其低调务实的作风和强大的技术实力,成为了国内 AI 领域的一股清流。DeepSeek V3 的卓越表现使其成为名副其实的国产 AI 之光。