大模型时代的“真假美猴王”

随着人工智能技术的飞速发展,大语言模型(LLM)已经深入到我们日常工作和生活的方方面面。它们能写文章、做翻译、解答问题,仿佛无所不能。然而,这些“智能”的背后,却隐藏着一个令人头疼的问题——“幻觉”。

所谓“幻觉”,指的是大模型在生成文本时,会无中生有、胡编乱造,输出一些看似合理但实则虚假的内容。这就像《西游记》里的真假美猴王,让用户难以分辨真伪,给实际应用带来了巨大的风险。尤其是在一些专业领域,如果模型输出错误信息,可能会造成严重的后果。

为了解决这一问题,谷歌DeepMind推出了全新的基准测试——FACTS Grounding。这个基准旨在评估AI模型在特定上下文中生成准确文本的能力,力求让“幻觉”无处遁形。

FACTS Grounding:为大模型打造“照妖镜”

FACTS Grounding的核心思想是:在给定上下文的情况下,评估模型输出是否完全基于输入的内容,且满足用户需求。简单来说,就是给模型一个“剧本”(上下文文档),让它根据“剧本”进行表演(生成文本),看看它是不是在“照本宣科”,还是在“自由发挥”。

该基准测试的数据集包含用户请求和完整的文档,文档长度最长可达32k个token(约2万个单词),覆盖金融、技术、零售、医学和法律等多个领域。为了确保输入的多样性,数据集避免了那些需要创造力、数学或复杂推理的样本。

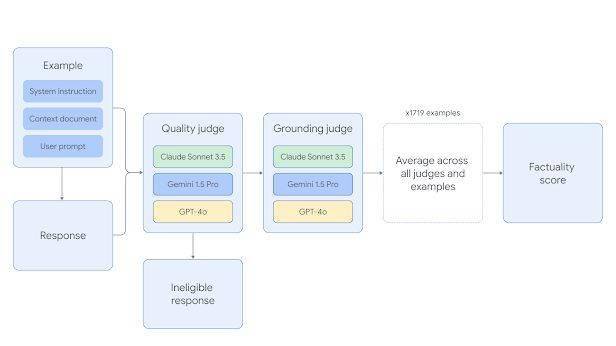

FACTS Grounding的评估分为两个维度:

- 有效性评估:如果模型的回复没有满足用户需求,则直接判定为无效。

- 准确性评估:如果模型的回复完全基于给定的文档,则被判定为准确。

为了减少模型偏见,研究人员使用三个不同的大模型(Gemini 1.5 Pro, GPT-4o和Claude 3.5 Sonnet)进行评估,并采用多种提示模板,最终选择与人工判断一致性最高的模板。

这种严格的评估机制,就像一面“照妖镜”,能够有效地识别模型是否存在“幻觉”问题,确保其输出的文本是真实可靠的。

评估指标:多维度衡量模型能力

FACTS Grounding的评估指标主要分为以下几个方面:

- 未调整的事实性得分(Unadjusted Factuality Score):使用语言模型智能体来判断模型回复是否基于给定的上下文文档,并给出二元分类标签(准确/不准确)。该得分是所有智能体模型得分的平均值。

- 排除无效回复:如果模型回复没有满足用户需求,则被视为无效,并从评估中排除。

- 最终事实性得分:在排除无效回复后,重新计算的事实性得分。

通过这些指标,研究人员能够全面衡量模型在事实准确性方面的表现,并对不同模型进行排名比较。

Gemini家族:实力霸榜,引领AI新方向

FACTS Grounding基准测试的在线排行榜(Kaggle)实时维护,目前Gemini系列模型以较大优势领先,展现了其在事实准确性方面的强大实力。这不仅证明了Gemini模型的优异性能,也为人工智能的未来发展指明了方向:在追求模型智能化的同时,更要注重模型的可靠性和安全性。

Gemini系列模型的突出表现,离不开谷歌在人工智能领域的长期投入和技术积累。Gemini不仅在模型架构上进行了创新,还采用了先进的训练方法,使其能够在理解上下文信息的基础上,生成准确且符合用户需求的文本。

挑战与机遇:大模型“幻觉”的攻坚战

尽管FACTS Grounding为解决大模型“幻觉”问题迈出了重要一步,但我们仍然面临着许多挑战:

- 数据污染:由于用户文档是从互联网上公开下载的,可能包含在其他模型的预训练语料库中,这可能会影响评估的公正性。

- 评估标准:如何设计更全面、更准确的评估标准,仍然是一个值得深入探讨的问题。

- 模型泛化能力:如何在不同场景下,确保模型输出的文本都是准确可靠的,也是一个需要解决的难题。

然而,挑战也意味着机遇。随着人工智能技术的不断进步,我们有理由相信,未来一定能够彻底解决大模型的“幻觉”问题,让人工智能真正成为人类可靠的助手。

行业影响与展望:走向可信赖的AI

FACTS Grounding的推出,对于整个AI领域都具有重要的意义:

- 提高模型可靠性:FACTS Grounding的评估机制能够有效识别模型中的“幻觉”问题,提高模型输出的可靠性,增强用户对AI的信任。

- 促进模型优化:通过FACTS Grounding的评估结果,研究人员能够更好地了解模型的不足之处,并有针对性地进行优化,提高模型的整体性能。

- 推动行业发展:FACTS Grounding的推出,将促使整个行业更加重视AI模型的可靠性和安全性,推动AI技术朝着更加健康、可持续的方向发展。

可以预见,随着FACTS Grounding等基准测试的不断完善,以及相关技术的不断突破,未来的AI模型将更加可信赖,能够更好地服务于人类社会。

AI的未来,值得期待

大语言模型是人工智能发展的重要里程碑,它们在为我们带来便利的同时,也带来了新的挑战。FACTS Grounding的推出,正是为了应对这些挑战,让AI模型更加真实可靠。

随着技术的进步,我们有理由相信,未来的AI将不再是“胡说八道”的代名词,而是真正值得信赖的智能伙伴。让我们一起期待一个更加美好的AI未来!