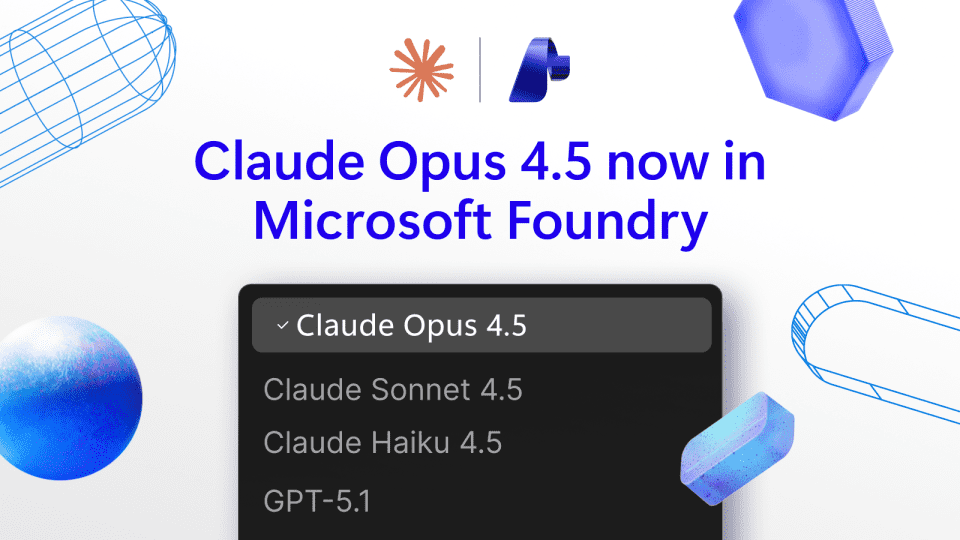

人工智能领域再次迎来重大突破,Anthropic最新研发的Claude Opus 4.5模型正式登陆Microsoft Foundry平台,标志着两大科技巨头在AI领域的深度合作迈入新阶段。这款先进模型现已通过公共预览形式在Microsoft Foundry、GitHub Copilot付费计划以及Microsoft Copilot Studio三大核心平台同步上线,为全球开发者和企业用户提供前所未有的AI体验。

Opus 4.5:AI技术的全新里程碑

Claude Opus 4.5的发布不仅是Anthropic技术实力的集中体现,更是AI行业发展的一个重要转折点。作为Anthropic最新的旗舰模型,Opus 4.5在多个关键领域实现了显著突破:

- 理解能力:Opus 4.5拥有前所未有的上下文理解能力,能够处理更复杂的指令和多轮对话

- 生成质量:在文本创作、代码生成和问题解答等方面表现出色,输出质量大幅提升

- 效率优化:在保持高性能的同时,显著降低了计算资源消耗,提高了运行效率

- 安全性:内置更强大的安全机制,减少有害输出,提高AI使用的可靠性

三大平台同步上线,构建全方位AI生态

Microsoft Foundry作为微软AI创新的核心平台,成为Opus 4.5首次亮相的舞台。这一选择充分体现了微软对Anthropic技术的高度认可,也展示了两大公司在AI领域的战略协同。

Microsoft Foundry:AI创新的核心枢纽

Microsoft Foundry一直是微软AI技术展示和创新的重要平台。Opus 4.5的加入将进一步丰富Foundry的AI模型阵容,为开发者提供更多样化的选择。通过Foundry,开发者可以:

- 直接体验Opus 4.5的强大功能

- 获取专业的技术支持和开发资源

- 参与前沿AI技术的测试和反馈

GitHub Copilot:编程体验的革命性升级

对于广大开发者而言,GitHub Copilot付费计划集成Opus 4.5意味着编程体验将迎来质的飞跃。这一整合将带来:

- 更智能的代码补全和生成

- 更精准的问题诊断和解决方案

- 更高效的编程学习和技能提升

- 更强大的多语言支持能力

Microsoft Copilot Studio:打造个性化AI助手

Microsoft Copilot Studio作为企业级AI应用开发平台,Opus 4.5的加入将使其功能更加完善。企业用户现在可以:

- 基于Opus 4.5构建更智能的AI助手

- 开发更复杂的业务流程自动化解决方案

- 提供更自然、更人性化的客户服务体验

- 实现更精准的数据分析和决策支持

技术突破与行业影响

Claude Opus 4.5的发布不仅是技术层面的进步,更将对整个AI行业产生深远影响。从技术角度看,Opus 4.5代表了当前大语言模型的最新发展方向;从行业角度看,这一合作模式可能成为AI领域企业合作的典范。

技术创新点解析

Opus 4.5之所以能够在众多AI模型中脱颖而出,主要归功于以下几个技术创新:

- 架构优化:采用了全新的神经网络架构,在保持模型规模的同时提高了计算效率

- 训练方法:引入了更先进的训练方法,使模型能够更好地理解和执行复杂指令

- 安全机制:开发了全新的安全过滤系统,有效减少有害输出

- 多模态能力:增强了处理多种数据类型的能力,为未来的多模态应用奠定基础

行业变革与机遇

Opus 4.5的发布将为AI行业带来多方面的变革:

- 应用场景扩展:从简单的问答助手向更复杂的业务应用拓展

- 开发门槛降低:使更多企业能够利用先进AI技术开发自己的应用

- 行业标准提升:推动整个行业向更高标准发展

- 合作模式创新:展示科技巨头间深度合作的新模式

开发者体验与实际应用

对于开发者而言,Claude Opus 4.5不仅仅是一个技术产品,更是一个强大的开发伙伴。在实际应用中,Opus 4.5能够为开发者提供全方位的支持:

代码开发与优化

在软件开发领域,Opus 4.5可以:

- 生成高质量代码,支持多种编程语言

- 提供代码审查和优化建议

- 帮助调试复杂问题

- 自动生成测试用例

内容创作与编辑

在内容创作领域,Opus 4.5展现出卓越能力:

- 撰写各类高质量文章、报告和营销文案

- 进行文本润色和风格调整

- 生成创意内容,如故事、诗歌等

- 多语言翻译和文化适应

数据分析与决策支持

在商业智能领域,Opus 4.5可以:

- 处理和分析大量数据

- 生成数据可视化和报告

- 提供业务洞察和建议

- 辅助制定战略决策

未来展望与发展方向

Claude Opus 4.5的发布只是一个开始,未来AI技术的发展仍有许多可能性。基于Opus 4.5的基础,我们可以期待以下发展方向:

技术演进路径

- 模型小型化:在保持性能的同时,开发更轻量级的模型版本

- 多模态融合:进一步增强图像、音频等多模态处理能力

- 个性化定制:提供更多模型定制和微调选项

- 边缘计算:优化模型以适应边缘设备部署

应用场景拓展

Opus 4.5将为更多行业带来变革:

- 医疗健康:辅助诊断、药物研发、健康管理

- 教育培训:个性化学习、智能辅导、内容生成

- 金融服务:风险评估、投资建议、客户服务

- 制造业:智能生产、质量控制、供应链优化

结语:AI协作的新时代

Claude Opus 4.5在Microsoft Foundry的发布,标志着AI技术进入了一个新的发展阶段。这一合作不仅展示了Anthropic和微软的技术实力,更为整个行业树立了新的标杆。随着Opus 4.5在各个平台的广泛应用,我们可以期待AI技术在更多领域发挥重要作用,为人类社会带来更多价值。

对于开发者和企业而言,Opus 4.5提供了前所未有的机遇,能够帮助他们更高效地开发AI应用,提升业务效率。同时,这一合作也为AI行业的健康发展提供了有益的参考,展示了科技企业如何在竞争中寻求合作,共同推动技术进步。

在AI技术快速发展的今天,Claude Opus 4.5的发布只是众多突破中的一个起点。未来,随着技术的不断进步和应用场景的持续拓展,AI将深刻改变我们的工作方式和生活方式,开创一个更加智能、高效的未来。