人工智能产业正经历前所未有的变革与挑战,从OpenAI的巨额亏损到北京AI产业的蓬勃发展,从特斯拉在印度市场的困境到中国创新实力的全面提升,全球科技格局正在重新洗牌。本文将深入剖析这些热点事件背后的深层含义,揭示AI产业发展的真实图景。

OpenAI:史上'烧钱最快'的科技公司

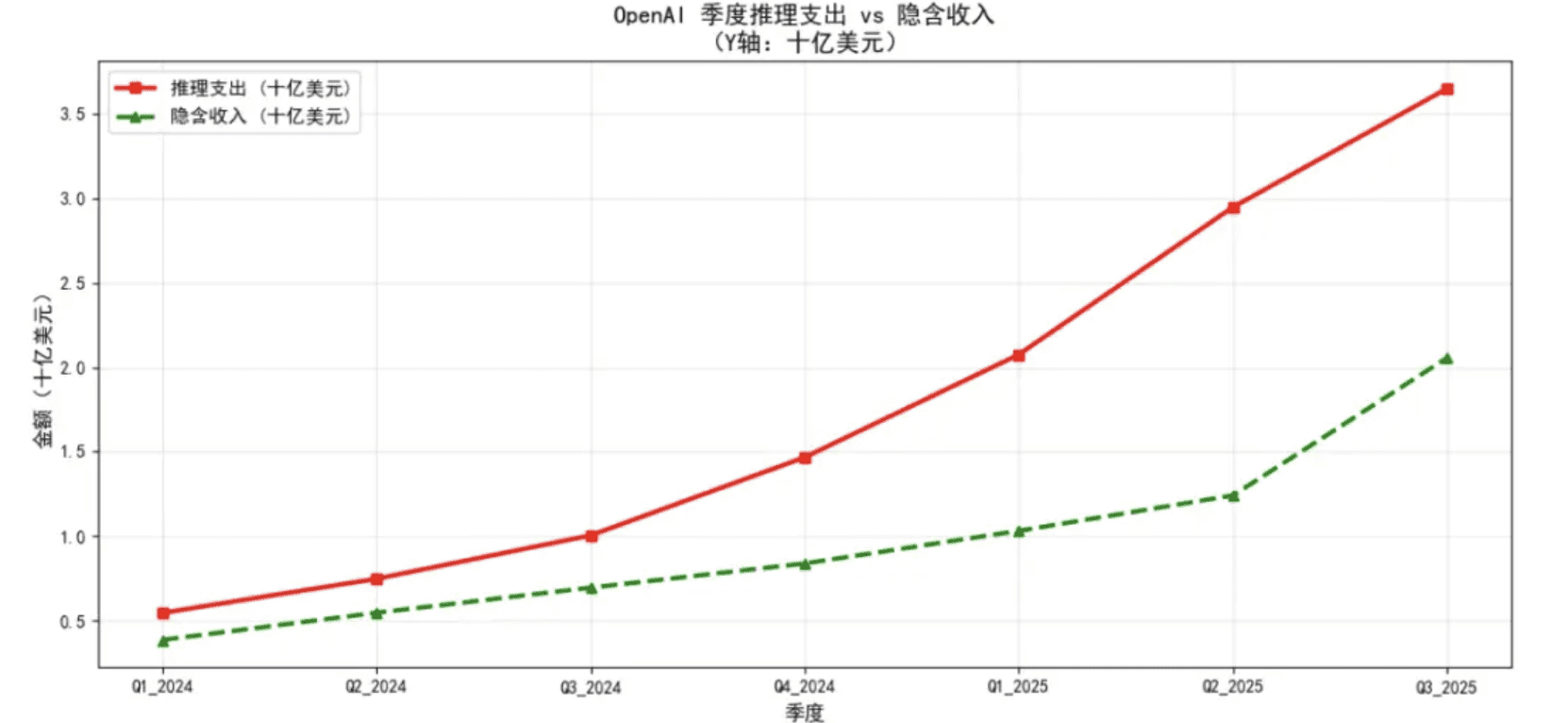

根据微软财报数据揭示,OpenAI正面临严峻的财务挑战,可能成为历史上'烧钱最快'的科技公司。2024 Q1至2025 Q3的数据显示,OpenAI的推理成本(即运行模型生成回答的成本)呈爆炸式增长:2025年Q3支出飙升至36.5亿美元,而同期隐含收入仅20.6亿美元。

这一数据意味着每赚1美元,OpenAI要花1.8美元用于推理;2025年Q1的比值甚至一度突破2.0,陷入'越卖越亏'的恶性循环。从年度层面看,问题更为突出:2025年前9个月的推理支出达86.7亿美元,是2024全年的2.3倍;同期收入仅增长75%,导致前9个月亏损已达43.4亿美元,远超上一年。

更令人担忧的是,媒体长期高估了OpenAI的营收。2024年,微软财报反推收入为24.7亿美元,而媒体普遍报道为37~40亿美元;2025年差距进一步拉大,仅上半年误差就达到20亿美元。这表明外界对OpenAI的成长速度和商业化能力可能存在系统性高估。

Sora2监管漏洞:AI内容生成的新挑战

随着AI生成技术的快速发展,内容监管问题日益凸显。消费者监督组织Ekō发布的《OpenAI Sora2:危害的新边界》报告揭示,研究人员使用以13岁和14岁青少年身份注册的账号,轻易生成了包括青少年吸食违禁品和在公共区域或学校走廊持枪等画面。

报告指出,Sora2生成暴力与令人不安内容的难度极低,这种内容很容易病毒式传播,从而进一步加剧风险。更值得关注的是,即使账号不主动生成内容,Sora2的'For You'和'Latest'推荐页面也会推送令人震惊的视频,包括刻板化描绘犹太人或黑人、枪战场面以及性暴力等画面。

这些内容全部违反了OpenAI的使用政策和Sora的分发准则,凸显了AI内容生成技术面临的监管挑战。如何在技术创新与内容安全之间找到平衡点,成为AI企业必须面对的难题。

中国AI产业蓬勃发展:北京规模将超4500亿元

与OpenAI的困境形成鲜明对比的是中国AI产业的强劲增长。2025年中国人工智能大会暨全国人工智能学院院长(系主任)年会上,北京市科委、中关村管委会发布的《北京人工智能产业白皮书(2025)》显示,初步估算今年全年北京市人工智能产业规模有望超过4500亿元。

数据显示,2025年上半年,北京人工智能核心产业规模达2152.2亿元,同比增长25.3%。AI企业超2500家,已备案大模型183款,持续保持全国第一。产业链日趋完整,形成了具有全球竞争力的产业生态。同时商业化路径也逐渐清晰,百度、抖音等公司的营收和产品活跃用户数均创新高。

中国创新实力提升:专利数量全球领先

国家知识产权局11月例行新闻发布会透露,中国已成为世界上首个国内有效发明专利拥有量超过500万件的国家,PCT国际专利申请量连续6年位居全球第一。专利密集型产业增加值达到16.87万亿元,占GDP的比重提升到13.04%;全球前5000个品牌中我国品牌价值达1.81万亿美元,位居全球第二。

世界知识产权组织发布的《2025年全球创新指数报告》中,中国排名提升至第10位,首次跻身全球前十,拥有的全球百强创新集群数量达到24个,连续三年位居各国之首,其中'深圳—香港—广州'集群首次登顶全球首位。

科技巨头市场表现:iPhone17创新高,特斯拉印度遇冷

在消费电子市场,iPhone17系列表现强劲。在iPhone17系列的助力下,苹果手机10月份额创下了历史新纪录。调研机构CounterPoint Research报告显示,得益于iPhone17系列(尤其是标准版)在中国、美国等市场的强劲表现,苹果2025年10月iPhone销量同比增长12%,终端销量份额飙升至24.2%。

中国成为苹果10月增长最快的市场,数据显示,在首发后的六周时间里,iPhone系列在中国市场的销量同比激增47%,远超美国(+11%)和日本(+8%)。特殊的市场节点助推了这一增长,包括新冠时期的换机潮达到顶峰,加上'双11'大促提前开启,以及中秋国庆假期的销售热度延续到10月。

然而,特斯拉在印度市场的表现却不尽如人意。作为全球第四大汽车市场,特斯拉今年7月终于在印度开出首家展厅,但根据经销商提供的数据,特斯拉在当地运营两个多月,仅卖出100多辆车。截至9月中旬,印度市场的Model Y(目前在当地唯一正式销售的特斯拉车型)刚刚收到600多份订单,但真正转化为交付的只有极少部分。

印度市场的Model Y售价高达70000美元(现汇率约合49.6万元人民币),已进入豪华车区间。同时,全国范围内只有两座Supercharger直流快充站,分别位于孟买和新德里,基础设施不足也成为制约因素。

新兴消费趋势:宠物经济与AI创新应用

智联招聘集团董事长郭盛在'第三届全国人力资源服务业发展大会'的论坛上分享的数据显示,2025年前三季度招聘增速最高的十个岗位中,与宠物经济相关的职位排在第二,增速为30.4%,仅次于机器学习工程师。这表明宠物经济正成为拉动就业的重要力量。

在创新应用方面,日本Science株式会社推出的AI自动洗澡机展现了科技与生活的融合。这款采用纳米气泡技术的洗澡机,用户只需平躺于2.3米长的胶囊舱内,机器将自动向舱内注入热水并释放数百万微气泡进行全身清洁,并在15分钟内完成清洗与烘干流程。

沐浴过程中,位于用户背部的传感器可实时监测健康状态,通过AI算法调节水温并识别情绪状态,同时在透明舱盖投射影像,并播放音乐。这款机器已在日本开售,零售价达6000万日元(现汇率约合272万元人民币),计划仅生产50台左右,目前已售出8台。

虚拟货币监管与贾跃亭债务问题

中国人民银行近日召开打击虚拟货币交易炒作工作协调机制会议,强调虚拟货币不具有与法定货币等同的法律地位,不具有法偿性,不应且不能作为货币在市场上流通使用,虚拟货币相关业务活动属于非法金融活动。

会议指出,稳定币是虚拟货币的一种形式,目前无法有效满足客户身份识别、反洗钱等方面的要求,存在被用于洗钱、集资诈骗、违规跨境转移资金等非法活动的风险。

与此同时,贾跃亭通过其个人社交平台宣布成立第二个债权人信托,旨在'加速偿还国内担保债务尽责到底早日回国'。他表示,'还债回国是我生命中最重要的两件事之一。'对此,资本市场人士多持怀疑态度,认为贾跃亭此举更多的是博眼球、追流量。

面对外界质疑,贾跃亭称,不论外界怎么评价,其生命中只有两件事:'一个是打造EAI生态,给社会带来变革性的驱动作用,另一个是还清国内债务,早日回到祖国。'据悉,法拉第未来(Faraday Future)管理层已批准了FF和FX品牌的五年商业计划,未来五年累计产量目标为40万至50万辆。

文化娱乐市场:《疯狂动物城2》创票房纪录

在文化娱乐领域,迪士尼动画电影《疯狂动物城2》表现抢眼。截至11月29日下午,据猫眼专业版数据,电影《疯狂动物城2》上映4天,总票房破13亿。同日,单日票房超5.58亿,刷新中国影史进口电影单日票房纪录。

结语:科技发展的双面性

从OpenAI的巨额亏损到中国AI产业的蓬勃发展,从特斯拉在印度市场的困境到宠物经济的快速增长,全球科技产业呈现出复杂多元的发展态势。一方面,AI技术正以前所未有的速度推动产业变革;另一方面,技术发展也带来了新的挑战和问题。

在AI内容生成领域,如何在技术创新与内容安全之间找到平衡点成为关键;在商业应用层面,如何实现技术与商业的可持续发展是每个企业必须思考的问题;在监管方面,如何制定既鼓励创新又防范风险的规则体系,考验着各国政府的智慧。

未来,随着技术的不断进步和应用的深入拓展,全球科技产业将迎来更多机遇与挑战。只有那些能够准确把握技术趋势、有效管理风险、持续创新的企业,才能在这场科技变革中脱颖而出,引领行业发展方向。