近年来,人工智能技术的飞速发展深刻地改变了各行各业的运作模式。OpenAI作为该领域的领军者,其此前发布的GPT系列模型多以云端API的形式提供服务,虽然功能强大,但在数据隐私、定制化需求和延迟方面,仍有部分企业和个人用户期待更灵活的解决方案。正是在这样的背景下,OpenAI近期推出了一系列开放权重(open-weight)的AI模型——gpt-oss-120b和gpt-oss-20b,这标志着自2019年GPT-2发布以来,OpenAI再次向开源社区迈出了重要一步。这些模型的设计宗旨是可在用户本地硬件上运行,从而开启了AI部署的新范式,尤其对于那些对数据主权和实时性有严格要求的场景而言,意义非凡。

gpt-oss系列模型的技术架构与性能解析

gpt-oss系列模型包含了两个主要版本:gpt-oss-120b和gpt-oss-20b,它们在参数规模和硬件需求上有所区分,以适应不同级别的计算能力。gpt-oss-120b拥有高达1170亿的原始参数,而gpt-oss-20b则包含210亿参数。值得注意的是,这两个模型均采用了混合专家(Mixture-of-Experts, MoE)架构,这项技术使得模型在推理时仅激活部分专家网络,从而有效降低了每个token所需的实际活跃参数量。具体来说,gpt-oss-120b在MoE的作用下,每处理一个token仅需激活约51亿参数,而gpt-oss-20b则仅需约36亿参数。这种设计显著提升了模型的运行效率,并降低了对即时计算资源的需求。在硬件要求方面,gpt-oss-20b模型在配备16GB或更多内存的消费级设备上即可流畅运行,这使得普通用户也能体验到大型语言模型的强大功能。而gpt-oss-120b则需要至少80GB内存,通常需要专业的AI加速卡如Nvidia H100等才能充分发挥其性能。

这些模型还支持可配置的“链式思考”(Chain of Thought, CoT)功能,用户可以通过简单的系统提示设置低、中、高三种CoT级别。较低的CoT设置可以带来更快的推理速度和更低的资源消耗,而较高的CoT设置则能显著提升输出内容的质量和逻辑性。此外,两者均具备128,000个token的超大上下文窗口,这意味着它们能够处理和理解极长的文本输入,为复杂的任务和深入的对话提供了可能。

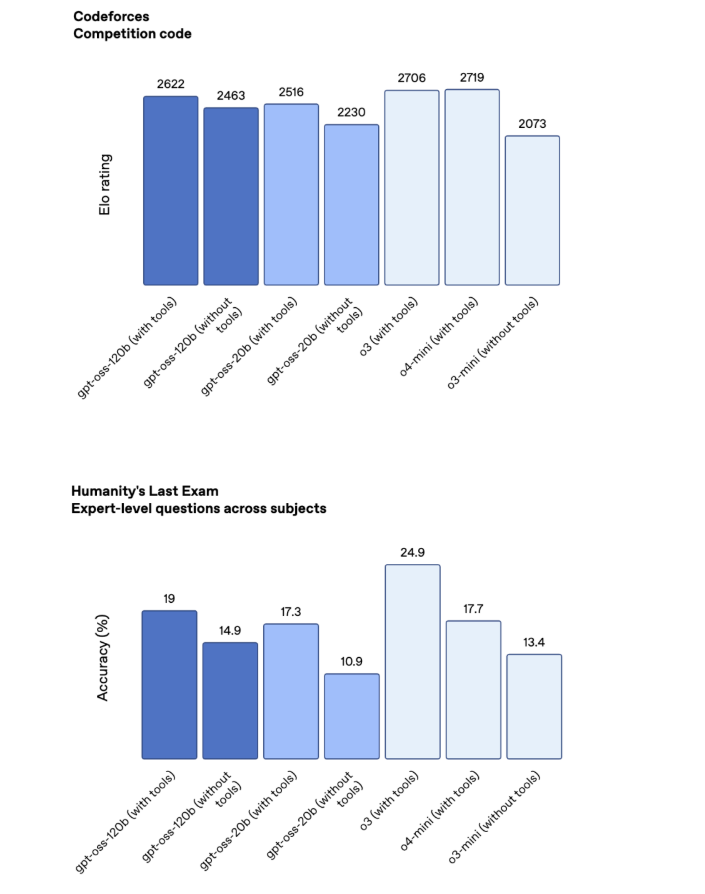

OpenAI团队对gpt-oss系列的性能进行了严谨的基准测试,结果显示其表现堪比公司领先的云端专有模型。大型的gpt-oss-120b在大多数测试中性能介于o3和o4-mini之间,而gpt-oss-20b则稍逊一筹。特别是在数学和编程任务上,gpt-oss系列展现出强大的能力。然而,在知识密集型的“人类终极考试”(Humanity's Last Exam)中,gpt-oss-120b的得分(19%)仍与顶级模型如Google的Gemini Deep Think(34.8%)存在一定差距,这表明在需要深层次知识整合和推理的场景中,仍有提升空间。尽管如此,作为可在本地运行的开放模型,其综合性能已足以满足广泛的企业和个人应用需求。

本地化部署的战略价值与应用前景

OpenAI明确表示,发布gpt-oss系列并非旨在完全取代其云端专有模型,而是为了满足特定场景下的独特需求。本地化部署的AI模型具有云端服务无法比拟的优势:

- 数据主权与隐私保护:对于处理敏感数据(如医疗记录、金融交易信息或企业内部机密文档)的机构而言,将AI模型部署在本地意味着数据无需离开企业防火墙,极大地增强了数据安全性,并能有效遵循GDPR、HIPAA等严格的数据合规性要求。

- 低延迟与实时响应:在边缘计算或需要即时反馈的应用中,本地模型避免了网络传输带来的延迟,实现了毫秒级的响应速度。这对于实时交互式AI应用、自动驾驶系统或工业自动化等领域至关重要。

- 高度定制与深度集成:开放权重模型允许开发者对其进行深度微调(fine-tuning),以适应特定的业务语料和任务需求。企业可以根据自身数据训练出高度专业化的AI模型,使其更好地理解行业术语和业务逻辑,并无缝集成到现有工作流程中。

- 成本效益与自主控制:虽然初期可能存在硬件投入,但长期来看,通过消除持续的API调用费用,本地部署能够为高频使用AI的企业带来显著的运营成本节约。同时,企业对模型的运行环境和资源分配拥有完全的控制权。

OpenAI此举也体现了其在市场策略上的深谋远虑。通过提供本地化解决方案,OpenAI能够覆盖更广阔的市场,尤其吸引那些因数据安全顾虑而未完全采用云端AI服务的企业。此外,gpt-oss模型被设计为可与OpenAI的专有GPT模型协同工作,这意味着客户可以构建端到端的OpenAI产品生态系统,在本地处理敏感数据,同时利用云端模型进行更复杂的通用任务,从而实现混合AI部署的灵活性。

模型安全性、开放性与未来生态建设

随着AI模型能力的日益增强,其潜在的滥用风险也引发了广泛关注。OpenAI深知这一点,在gpt-oss系列的开发过程中,高度重视模型安全性。公司披露,他们通过“刻意对齐”(deliberative alignment)和“指令层级”(instruction hierarchy)等机制,内建了防止恶意行为的控制措施。为了验证这些防护措施的有效性,OpenAI甚至尝试对gpt-oss模型进行“邪恶化”调优测试,结果表明,即使在尝试诱导其生成有害内容后,模型也未能达到高水平的恶意行为能力。OpenAI认为,这验证了其安全框架在防止开源模型被严重滥用方面的有效性,这为开放模型的发展提供了重要的安全基石。

gpt-oss模型采用Apache 2.0开源许可证发布,这意味着开发者和研究人员可以自由地下载、使用、修改和分发这些模型。这种开放性将极大地促进AI技术的普及和创新。开发者社区可以基于这些模型进行二次开发、性能优化或创建新的应用,加速垂直领域的AI解决方案落地。OpenAI还提供了GitHub代码库和官方托管版本供测试使用,以及详细的模型卡片和研究博客文章,以确保技术细节的透明度和可访问性。这种开放、透明的态度,有助于建立一个更协作、更负责任的AI生态系统。

总而言之,OpenAI的gpt-oss系列模型的发布,是其在AI发展道路上的又一重要里程碑。它不仅代表了技术能力的进步,更预示着AI部署模式的多元化和普及化。通过拥抱开放与本地化,OpenAI正在重新定义企业和个人如何利用人工智能,推动AI技术从云端走向边缘,赋能更广泛的创新应用,共同构建一个更加智能、安全且普惠的未来世界。