ChatGPT隐私风波:敏感对话惊现搜索,AI伦理边界再受拷问

近日,人工智能领域巨头OpenAI遭遇了一场突如其来的隐私信任危机,旗下广受欢迎的生成式AI产品ChatGPT被曝出数千条用户私密对话意外泄露,并被谷歌等搜索引擎索引。这一事件迅速引发了全球范围内的广泛关注与热议,不仅暴露出AI产品在数据隐私处理上的潜在漏洞,更深刻地拷问了人工智能伦理的边界,以及技术公司在用户数据安全方面的责任担当。

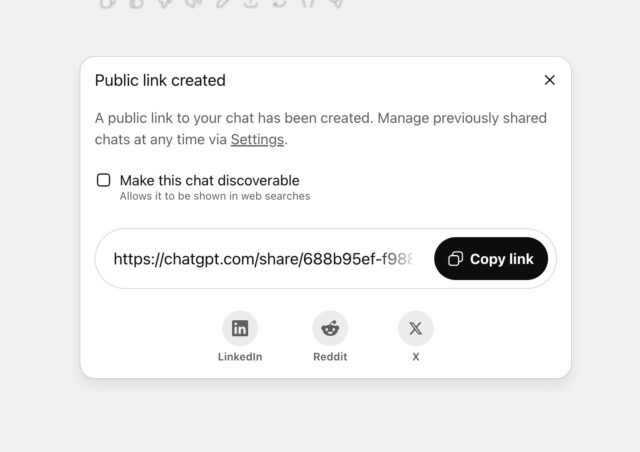

最初由Fast Company披露的这一隐私问题揭示,大量原被认为是私密的ChatGPT用户对话内容,竟可在谷歌搜索结果中被轻易检索。尽管OpenAI首席信息安全官戴恩·斯塔基(Dane Stuckey)解释称,这些被曝光的对话是由于用户在分享时,勾选了“使此对话可被发现”(Make this chat discoverable)的选项。然而,设计上的隐晦性使得许多用户并未充分理解此选项的真实含义及其带来的隐私风险。

隐私泄露的深层原因与用户困境

此次事件的核心在于用户体验设计与隐私保护之间的张力。据报道,当用户选择“分享”ChatGPT对话时,会弹出一个选项框,其中包含“使此对话可被发现”的勾选框。在其下方,用更小、更浅的字体标注着“该对话可能会出现在搜索引擎结果中”的提示。这种层级分明但重要信息次要化的设计,极易导致用户在匆忙或不经意间勾选,从而无意中将高度个人化甚至敏感的对话公之于众。

受影响的对话内容包含了从人际关系描述、个人心理健康状态、药物使用习惯到创伤经历等一系列极其私密的细节。即便搜索引擎索引结果未直接披露用户身份信息,但这些高度具体的内容,在特定语境下仍可能使相关个体被识别。用户在使用AI时,往往会基于对“私人聊天”的固有认知,倾向于倾吐心声或探讨敏感话题,这种心理预期与实际数据处理方式之间的巨大落差,正是此次信任危机爆发的根源。对许多用户而言,与AI的交流被视为一个安全的、无评判的空间,因此他们会毫无保留地分享信息。当这些“秘密”公之于众时,所带来的冲击和心理困扰是巨大的。

OpenAI的应对与行业反思

面对舆论压力,OpenAI的态度经历了转变。最初,他们认为其标签提示“足够清晰”,但随着问题的严重性凸显,最终承认该功能“带来了太多用户意外分享他们不打算分享内容的机会”。OpenAI迅速采取行动,移除了这项争议性功能,并承诺将通过技术手段从相关搜索引擎中移除已索引的内容。这一举动,虽然及时,但也暴露了在产品设计初期对用户隐私考量不足的问题。

谷歌方面则明确表示,搜索引擎本身并不控制网页的公开性,页面的发布者拥有完全的索引控制权。这进一步强调了AI平台作为数据收集和处理方,在隐私保护方面不可推卸的主体责任。如何有效利用搜索引擎提供的工具(如robots.txt、noindex标签或移除工具)来管理和控制内容的可见性,是所有大型在线服务提供商必须精通的技能。

AI伦理的持续拷问:技术公司应如何自我约束?

此次事件再度引出了AI伦理领域的深层次讨论。牛津大学AI伦理学家卡丽莎·维利兹(Carissa Veliz)将此形容为“令人震惊”,并尖锐地指出,科技公司常常将大众当作“小白鼠”,通过推出新产品吸引海量用户,然后坐等观察其侵入性设计可能带来的后果。这种“先试错,再改正”的模式,在涉及到用户核心隐私时,无疑是极其不负责任的。

AI公司在追求技术创新和用户增长的同时,必须将隐私保护置于产品设计的核心地位,奉行“隐私设计(Privacy by Design)”的原则。这意味着在产品开发周期的每个阶段,从概念形成到部署,都应积极预见和规避隐私风险。用户同意机制需要更加透明、易懂和明确,避免使用“黑暗模式”诱导用户做出不利于自身隐私的决定。同时,对于用户数据的收集、存储、使用和共享,必须有清晰、可操作且符合法律法规的政策指引。

数据保留争议与法律挑战:隐私保护的复杂博弈

值得注意的是,此次事件并非OpenAI首次面临数据隐私方面的挑战。此前,OpenAI曾就一项法院命令提起上诉,该命令要求其“无限期”保存所有已删除的ChatGPT聊天记录。这一举动当时就引发了用户对于其“临时性和已删除聊天记录不被保存”承诺的担忧。尽管OpenAI首席执行官萨姆·奥特曼(Sam Altman)曾对用户最私密聊天可能被搜索感到“搞砸了”,但Fast Company指出,他对OpenAI自身操作可能暴露用户私人聊天一事似乎并未表现出同等的透明批评。

这反映出在快速发展的AI领域,数据治理和隐私合规面临着前所未有的复杂性。一方面,AI模型的训练和改进通常需要大量数据,这与用户对数据最小化和及时删除的期望存在潜在冲突。另一方面,法律和监管机构对数据保留的要求(例如出于司法调查目的)也可能与用户隐私权产生龃龉。如何在技术发展、商业利益、用户隐私和法律责任之间取得平衡,是AI公司和监管机构共同面临的艰巨任务。

构建负责任AI的路径:多方协作与持续演进

此次ChatGPT隐私泄露事件,是一次深刻的警示,它促使我们必须重新审视人工智能时代的隐私边界与用户权益。构建一个负责任、值得信赖的AI生态系统,需要多方力量的共同协作:

AI平台的主体责任:AI公司应建立健全的内部隐私保护制度,确保从产品设计到运营的每一个环节都严格遵循隐私最小化、目的限制和数据安全原则。这包括但不限于:提供清晰易懂的隐私政策,确保用户充分知情同意;采用先进的加密技术和访问控制机制保护用户数据;定期进行安全审计和漏洞扫描;以及建立快速响应机制,及时处理隐私泄露事件。

监管机构的积极作为:各国政府和监管机构应加快制定和完善针对人工智能的专项数据保护法规,明确AI企业的数据处理边界、责任和罚则。例如,借鉴欧盟《通用数据保护条例》(GDPR)的严格要求,并结合AI的独特性质,出台更具前瞻性和执行力的规范,如要求算法透明度、可解释性以及数据使用目的的明确性。通过设立专门的AI伦理审查委员会或引入第三方审计机制,强化对AI产品隐私合规性的监督。

用户隐私意识的提升:作为AI使用者,公众应提高自身的数字素养和隐私保护意识。在与AI互动时,应审慎评估所分享信息的敏感程度,仔细阅读并理解相关服务条款和隐私政策。利用平台提供的隐私设置,主动管理个人数据权限。对于那些涉及个人健康、财务、情感等高度敏感信息的问题,应格外警惕,避免过度披露。同时,当发现潜在的隐私风险时,积极向平台或监管机构反馈,共同推动行业的健康发展。

行业自律与技术创新:AI行业应加强自律,形成一套普遍认可的伦理准则和最佳实践。鼓励技术创新向“隐私增强技术”(Privacy-Enhancing Technologies, PETs)方向发展,例如差分隐私、联邦学习、同态加密等,在不牺牲模型性能的前提下,从技术层面保障用户数据的隐私性。通过开放共享隐私保护技术和经验,共同提升整个行业的隐私保护水平。

此次ChatGPT隐私风波虽然短期内对OpenAI的声誉造成影响,但从长远看,它为整个AI行业敲响了警钟。只有真正将用户隐私视为核心竞争力,持续投入资源建立强大的隐私保护体系,并在透明、负责任的框架下推进技术创新,人工智能才能赢得更广泛的社会信任,最终实现其造福人类的巨大潜力。未来的AI发展,必将是技术进步与伦理责任深度融合的进程,隐私将成为其中不可或缺的基石。