人工智能“时间胶囊”:小型模型如何意外揭示19世纪伦敦史实?

一名计算机科学专业的学生Hayk Grigorian,凭借其在业余时间开发的“时间胶囊LLM”(TimeCapsuleLLM)项目,意外地为人工智能领域带来了一项引人深思的发现。他原本旨在训练一个能以维多利亚时代英语进行交流的AI语言模型,却在一次简单的测试中,发现其模型竟然精准地“回忆”出1834年伦敦真实发生过的抗议活动。这一事件不仅令Grigorian本人感到震惊,也促使他对AI从海量历史文本中提取并重构历史信息的能力进行了深入探索。

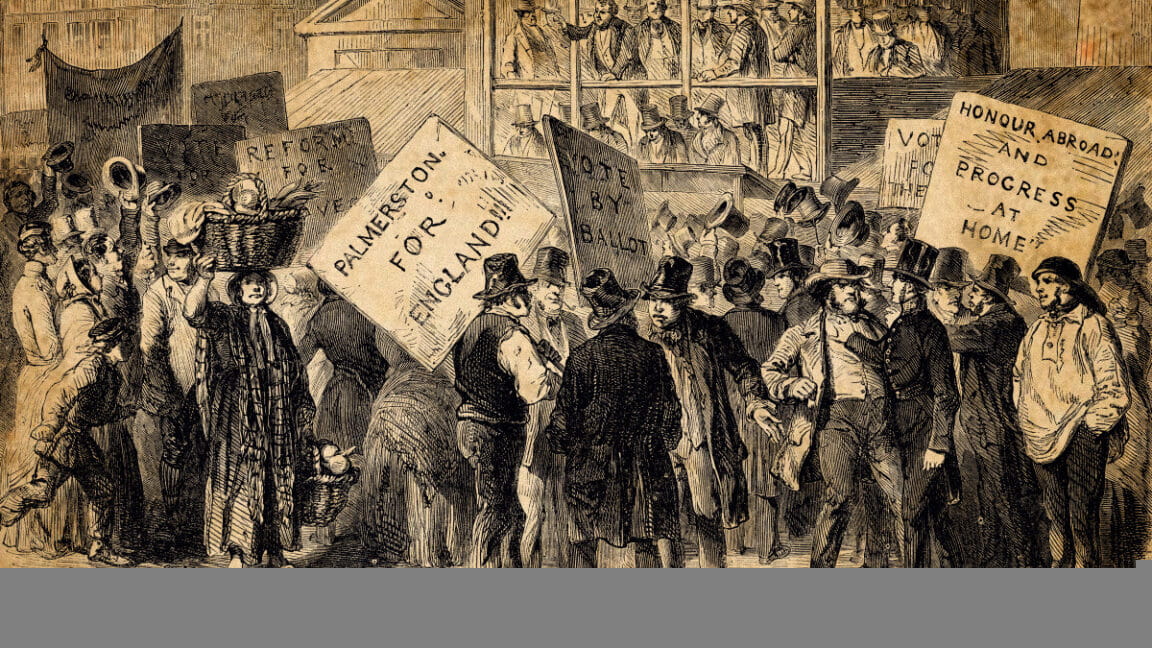

Grigorian的“时间胶囊LLM”是一个小型的AI语言模型,其独特之处在于完全基于1800年至1875年间伦敦出版的文本进行训练。他的目标是让AI能够掌握地道的维多利亚时代语言风格,包括其特有的修辞手法和宗教引用。当他用“那是我们主1834年”这一短语作为模型的起始提示时,AI的回复中不仅提到了伦敦街头的抗议与请愿,还明确提及了时任外交大臣帕默斯顿子爵。通过后续查证,Grigorian证实1834年英国确实因《济贫法修正案》引发了大规模的社会动荡,而帕默斯顿子爵在此期间扮演了重要角色。AI的输出与历史事实高度吻合,令人不禁思考小型AI模型在历史信息重构方面的潜在能力。

历史大语言模型(HLLMs)的崛起与“选择性时间训练”

Grigorian的项目并非孤例,它代表了“历史大语言模型”(Historical Large Language Models, HLLMs)这一新兴研究领域的重要进展。HLLMs旨在通过特定历史时期的文本数据训练AI模型,使其能够理解并生成符合该时代语言、知识体系和思维框架的内容。例如,MonadGPT模型便能使用17世纪的知识框架讨论议题,而荀子ALLM则专注于生成遵循古代格律的古典中文诗歌。这些模型为研究人员提供了一个前所未有的机会,能够以交互式的方式深入探索过去时代的语言模式与文化精髓。

Grigorian将他的训练方法命名为“选择性时间训练”(Selective Temporal Training, STT)。与现代大语言模型通常采用的“微调”(fine-tuning)策略不同,STT强调从零开始构建模型,并严格限制训练数据的年代范围。他解释道,如果在一个已经用现代文本预训练过的模型上进行微调,现代语言的痕迹将难以完全消除,从而影响模型输出的时代真实性。为了实现纯粹的维多利亚时代语言风格,Grigorian甚至开发了定制的词元分析器(tokenizer),专门排除现代词汇,将词语拆解成更易于处理的简化形式。这种从根本上塑造AI语言骨骼的方式,确保了模型能够真正“成为”旧时代的语言载体,而非仅仅“模仿”。

数据规模与智能涌现:从乱码到历史记忆

Grigorian的实验还清晰地展示了数据规模对AI模型能力提升的关键作用。他使用了基于“小型语言模型”架构(如nanoGPT和微软的Phi 1.5)构建了三个不同版本的AI模型:

- 版本0:仅使用187MB数据训练,结果是充满维多利亚时代风格的“乱码”,语法和语义上都难以理解。

- 版本0.5:在语法和句法层面实现了更正规的时代散文风格,但仍旧“幻觉”出大量不符合历史事实的信息。

- 当前7亿参数版本:通过租用A100 GPU,利用高达6.25GB的维多利亚时代文本进行训练。正是这个版本开始生成诸如1834年抗议活动这样的连贯历史引用。

这种现象在AI研究领域被称为“涌现效应”或“智能涌现”(Emergent Properties),特别是在小型模型上,高质量训练数据的规模化增长能够显著减少模型的“幻觉”倾向。早期的模型虽然能模仿文风,但在事件、人物和事实方面往往语无伦次。随着数据集的扩大,模型开始表现出从数据集中“记忆”特定信息的能力,这表明它正在从分散的语料中构建出更深层次的关联性知识。这并非简单的信息检索,而是在没有被明确告知历史关系的情况下,AI模型自主地从语言模式中推断出事件、人物和年份之间的复杂联系。

Grigorian感叹道:“这仅仅是基于5-6GB的数据。想象一下如果数据量达到30GB或更多会是怎样的结果。我不确定仅仅扩大数据规模是否会产生真正的‘推理’能力,但即使是现在,这已经感觉像是数字时间旅行了。”

“事实意外”:AI在历史研究与数字人文中的深远意义

Grigorian的发现为我们提供了一个有趣的视角:当AI模型意外地揭示了历史真相,我们称之为“事实意外”(factcident),这与常见的“幻觉”(confabulation)现象恰好相反。在一个AI频繁生成虚假信息的时代,这种意外的真实性显得尤为珍贵,它凸显了AI模型在特定、高质量数据训练下,能够超越简单的模式匹配,开始构建对世界(或特定历史时期)的内在表征。

对于历史学家和数字人文领域的研究人员而言,这类实验具有不可估量的价值。通过在特定历史文本上训练AI语言模型,研究者或许能够创建出交互式的语言模拟器,从而有机会“对话”已逝的语言或方言。尽管此类模型的输出在事实严谨性上可能仍面临“幻觉”的挑战,但它们无疑能在风格、语法和词汇使用方面提供极具启发性的洞察,帮助研究者更直观地理解古老语言的运作机制。

想象一下,如果能够训练出针对不同城市、不同文化背景的“时间胶囊”模型,比如一个中国古代城市模型、一个俄罗斯沙皇时代模型或一个印度莫卧儿帝国模型,那么我们便能构建起一个庞大的数字历史档案库,通过AI的视角重访人类文明的各个角落。Grigorian本人也表达了尝试训练针对其他城市的模型的意愿,并已将他的代码、模型权重和项目文档公开发布在GitHub上,鼓励全球的开发者和研究者共同参与到这项富有前瞻性的研究中。

未来,这类“时间胶囊”AI不仅可能成为历史教学与研究的强大辅助工具,甚至有可能帮助我们重新审视和解读那些尘封已久的古籍与档案,从中发掘出人类智慧的全新维度。这不仅仅是技术上的创新,更是一场关于人类文明记忆的深刻探索。