在人工智能领域,过去几年技术巨头们竞相推出参数量庞大、算力需求惊人的AI模型,这些模型通常部署在云端,依赖昂贵的GPU集群提供服务。然而,谷歌近期发布的一款迷你型AI模型——Gemma 3 270M,却反其道而行之,旨在将强大的人工智能能力带到边缘设备,预示着AI应用新范式的兴起。

这款Gemma 3 270M模型,顾名思义,仅拥有2.7亿参数。与动辄数十亿乃至数千亿参数的主流模型相比,它的体积显得微不足道。但正是这种“小而精”的设计,使其能够在智能手机、平板电脑乃至完全基于网络浏览器的环境中高效运行,为本地设备AI化提供了前所未有的可能性。

本地化部署:隐私与效率的双重优势

将AI模型部署在本地设备而非云端,具有多重显著优势。首先,也是最关键的一点,是用户隐私的极大增强。数据不再需要上传至远程服务器进行处理,所有计算都在设备本地完成,从而有效避免了数据泄露的风险。其次,本地运行显著降低了响应延迟,用户可以体验到近乎实时的AI交互,极大地提升了用户体验。这些正是Gemma 3 270M在设计之初便着重考量的核心价值。

在实际测试中,Gemma 3 270M展现了令人惊叹的能效表现。例如,在一款Pixel 9 Pro智能手机上,该模型能够在Tensor G4芯片上进行25次连续对话,而电池消耗仅为0.75%。这使得它成为目前Gemma系列模型中效率最高、对设备资源占用最小的版本,为移动设备上的持续AI应用提供了可行性。其卓越的性能与低功耗特性,无疑将加速AI在个人终端的普及。

性能突破:小模型亦能大作为

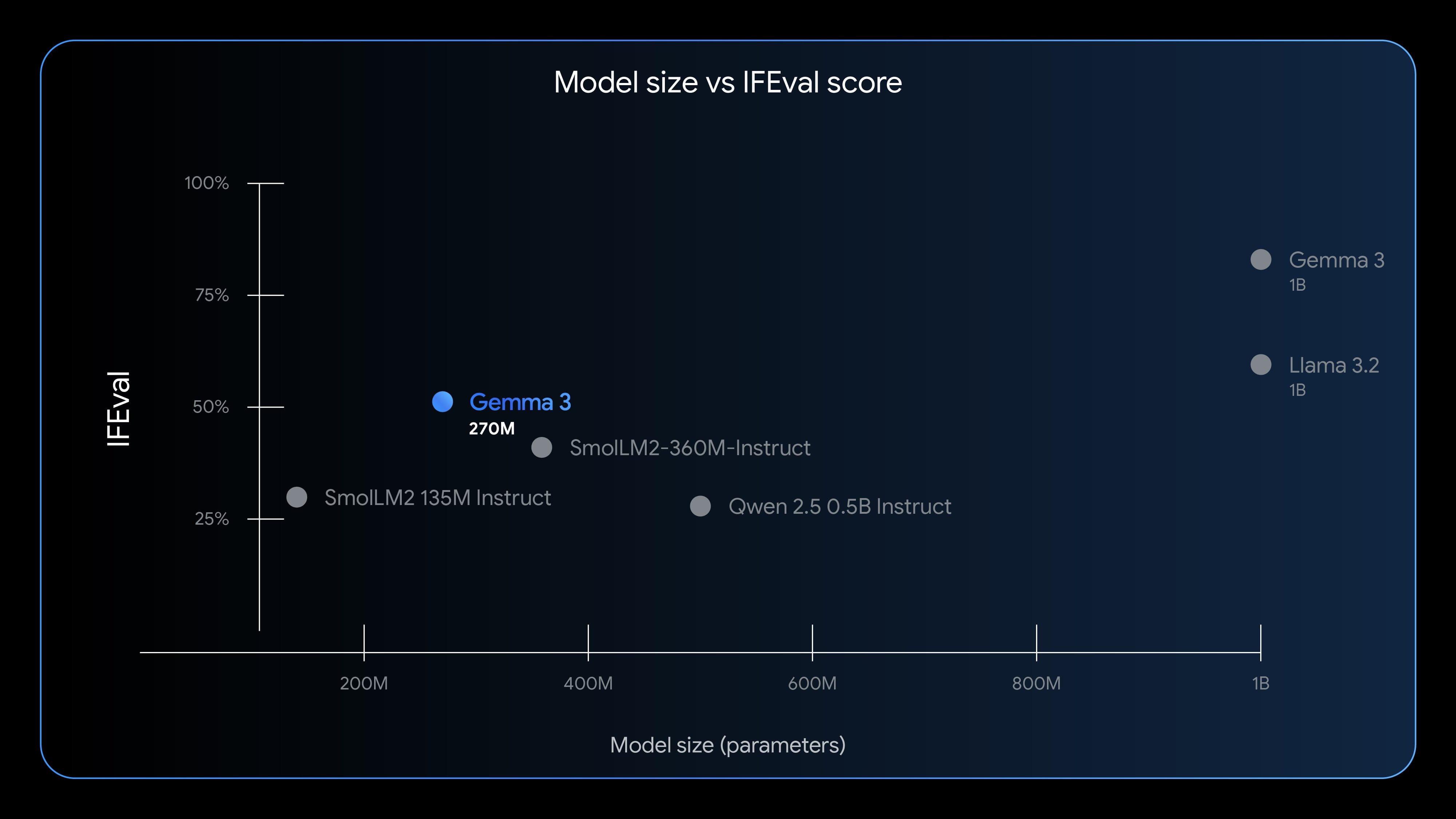

尽管参数量远小于大型模型,开发者不应期望Gemma 3 270M能达到与数十亿参数模型相同的性能水平。然而,谷歌通过IFEval基准测试表明,这款小型模型在指令遵循能力上展现出“以小博大”的潜力。Gemma 3 270M在该测试中获得了51.2%的评分,这一成绩超越了其他参数量更大的轻量级模型,令人印象深刻。虽然它与Llama 3.2等十亿级以上参数的模型仍有差距,但考虑到其极小的体量,这种接近程度已经令人瞩目。

这种强大的指令遵循能力,意味着Gemma 3 270M能够准确理解并执行用户的复杂指令,即使在资源受限的环境下也能提供可靠的AI服务。这为各类本地智能应用奠定了坚实基础。

灵活易用:低成本快速微调的理想选择

谷歌明确指出,Gemma 3 270M开箱即用,在指令遵循方面表现出色,但更期望开发者能够针对其特定应用场景进行微调。得益于其精简的参数规模,微调过程变得异常迅速且成本低廉。这大大降低了AI技术采纳的门槛,使得更多中小开发者和企业能够根据自身需求,定制化地优化AI模型,而无需投入巨额的计算资源和时间。

谷歌预见,这款新型Gemma模型将在文本分类、数据分析等领域发挥重要作用。由于其无需繁重的计算资源即可快速完成这些任务,它将成为边缘智能设备处理日常数据、提供即时洞察力的理想工具。这种灵活性和高效性,无疑将推动AI技术向更广泛的垂直行业渗透。

“开放”而非“开源”:独特的合作生态

谷歌将Gemma模型系列定义为“开放”而非严格意义上的“开源”。尽管如此,对于大多数开发者而言,这两种模式在使用上并无实质区别。Gemma 3 270M模型可供免费下载,并且其模型权重也完全开放。更重要的是,它不涉及独立的商业许可协议,这意味着开发者可以自由地修改、发布和部署基于Gemma 3 270M的衍生工具和应用,而无需支付额外的商业许可费用。

然而,所有Gemma模型的使用者都必须遵守其使用条款。这些条款明确禁止将模型微调以产生有害输出,或故意违反隐私法规。此外,开发者有责任详细说明其对模型的修改,并确保所有衍生版本都附带谷歌的使用条款,这些条款将继承谷歌的定制许可。这种平衡了开放性与责任约束的模式,旨在鼓励创新,同时维护AI技术的伦理边界。

目前,Gemma 3 270M已在Hugging Face和Kaggle等主流AI开发平台上推出,提供了预训练版本和指令微调版本,方便开发者根据需求选择。同时,谷歌的Vertex AI平台也支持对该模型进行测试。为进一步展示其潜力,谷歌还利用Transformer.js构建了一个完全基于浏览器的故事生成器,即使不从事模型开发的用户,也能亲身体验这款轻量级AI模型带来的创新能力。这无疑将加速Gemma 3 270M在实际应用中的普及和发展,为未来的AI生态注入新的活力和可能性。

Gemma 3 270M的出现,标志着AI发展的一个重要里程碑,它证明了强大的AI能力并非只能存在于庞大的数据中心,同样可以在我们身边的智能设备上高效运行。这种“小而美”的AI模型,正逐步改变我们与智能技术互动的方式,开启一个更加个性化、私密化和高效化的智能未来。