在AI泡沫论甚嚣尘上的当下,Google却向员工透露惊人计划:每6个月需翻倍AI服务能力,未来4-5年内实现算力千倍增长。这一矛盾现象揭示了科技巨头面临的真实困境——尽管存在对过度投资的担忧,但实际需求正以惊人速度增长。Google基础设施负责人Amin Vahdat强调,这一增长需在成本和能耗基本不变的情况下实现,挑战空前。与此同时,OpenAI等竞争对手也在斥巨资建设数据中心,AI基础设施竞赛已成为这场科技马拉松中最关键也最昂贵的赛道。

算力需求的指数级增长

在最近一次全员大会上,Google云副总裁、AI基础设施负责人Amin Vahdat向员工展示了一份令人震撼的路线图:公司需要在未来4-5年内将计算能力提升1000倍。更令人惊讶的是,Vahdat指出,这一增长周期实际上被压缩到了每6个月翻一次倍的速度。

"我们必须每六个月将服务能力翻倍,以满足人工智能服务的需求,"Vahdat在会议上表示。这一内部数据罕见地揭示了Google高管对AI市场前景的真实判断,与外界对AI泡沫的担忧形成了鲜明对比。

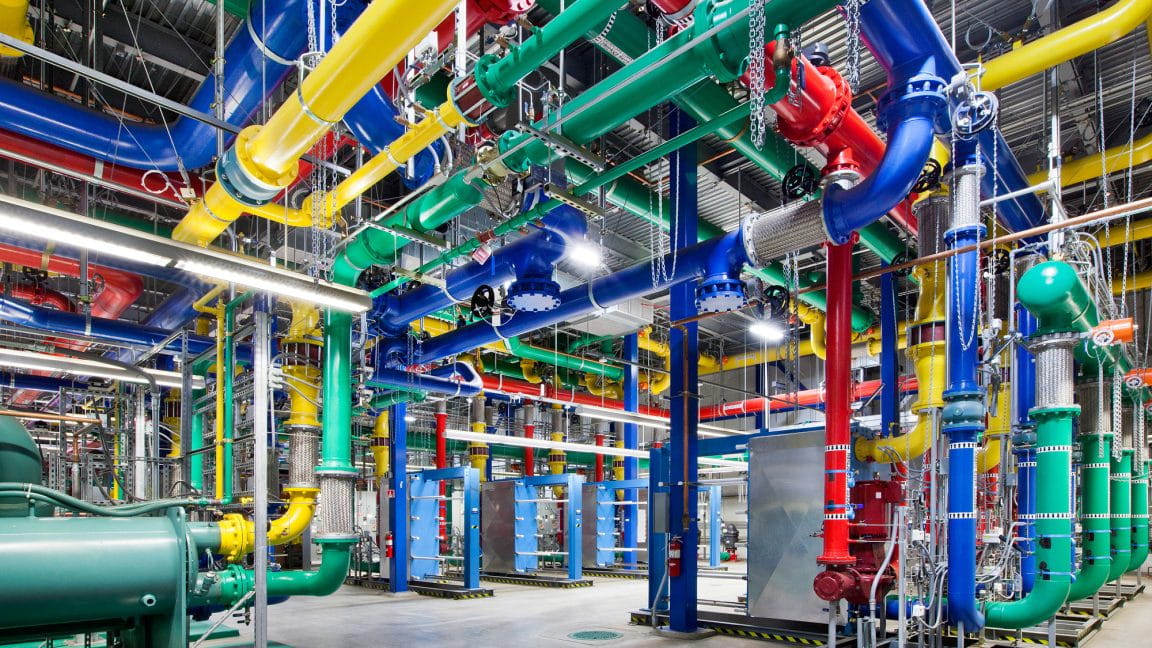

Google俄勒冈数据中心的冷却管道系统

Vahdat进一步强调,这一千倍增长并非简单的算力堆砌,而是在"基本相同的成本和日益相同的能耗水平"下实现的能力、计算和存储网络的全面提升。"这不容易,但通过协作和协同设计,我们将实现这一目标,"他向员工保证。

这一计划背后的驱动力是什么?一方面,可能是用户对AI功能的真实需求激增;另一方面,Google也在将AI功能整合到搜索、Gmail和Workspace等现有服务中,无论用户是否主动使用,这些功能都需要大量算力支持。

行业巨头的数据中心军备竞赛

Google并非唯一面临算力压力的科技巨头。其竞争对手OpenAI正通过其与软银和Oracle的Stargate合作项目,计划在美国建设六个大型数据中心,承诺在未来三年内投入超过4000亿美元,以达到近7吉瓦的容量。

OpenAI面临着类似的挑战——服务其8亿周活跃用户,即使是付费用户也经常在视频合成和模拟推理模型等功能上达到使用限制。Sam Altman领导的这家公司正迅速意识到,没有足够的算力,再先进的AI模型也无法转化为实际产品。

"AI基础设施的竞争是AI竞赛中最关键也是最昂贵的部分,"Vahdat在会议上表示。他解释说,Google的挑战不仅仅是比竞争对手花更多的钱。"我们将投入大量资金,"他说,但真正的目标是构建比任何地方都更可靠、性能更高、可扩展性更强的基础设施。

算力瓶颈:芯片短缺的现实困境

满足AI需求的一个主要瓶颈一直是Nvidia无法生产足够的加速AI计算的GPU。就在几天前的季度财报中,Nvidia表示其AI芯片"已售罄",因为它努力满足需求,仅在一个季度就使其数据中心收入增长了100亿美元。

NVIDIA数据中心级AI芯片

芯片短缺和其他基础设施限制影响了Google部署新AI功能的能力。在11月6日的全员大会上,Google首席执行官Sundar Pichai以Veo为例——Google上月获得升级的视频生成工具。"当Veo推出时,多么令人兴奋,"Pichai说。"如果我们能在Gemini应用中提供给更多人,我认为我们会获得更多用户,但我们做不到,因为我们正处于计算限制中。"

这一困境不仅限于Google。整个AI行业都在经历着芯片短缺的阵痛,而Nvidia作为GPU领域的领导者,其产能扩张速度似乎永远跟不上市场的需求增长。

Google的三管齐下战略

面对这一挑战,Google并非简单地通过增加支出来解决问题。在全员大会上,Vahdat的概述了公司如何计划实现其大规模扩展目标,主要依靠三种策略:建设物理基础设施、开发更高效的AI模型以及设计定制硅芯片。

自研芯片的突破

使用自己的芯片意味着Google不需要完全依赖Nvidia硬件来构建其AI能力。本月早些时候,Google宣布其第七代Tensor处理单元(TPU)Ironwood已全面上市。Google称其"比2018年的第一代Cloud TPU能效提高近30倍"。

Google Ironwood TPU芯片示意图

自研芯片不仅提高了能效,还增强了Google对供应链的控制,减少了对外部供应商的依赖。这种垂直整合战略在当前芯片供应紧张的环境下显得尤为重要。

模型效率的提升

除了硬件方面的努力,Google也在积极开发更高效的AI模型。通过算法优化和模型压缩技术,Google希望用更少的计算资源实现相同甚至更好的性能表现。这种软件层面的优化与硬件改进相辅相成,共同构成了Google应对算力挑战的综合方案。

数据中心的规模化建设

当然,物理基础设施的扩展仍然是Google战略的核心。公司正在全球范围内加速数据中心的建设和升级,特别是在气候条件适宜、能源成本较低的地区。这些新数据中心不仅需要容纳更多的服务器,还需要采用更先进的冷却技术和可再生能源,以应对能耗挑战。

泡沫论与现实的碰撞

在广泛认可潜在AI行业泡沫的背景下,包括Pichai最近在BBC采访中的 extended 评论,AI数据中心扩张的激进计划反映了Google的一项计算:投资不足的风险超过产能过剩的风险。

"2026年将是'激烈'的,"Pichai在全员大会上告诉员工,他提到了AI竞争以及满足云和计算需求的压力。Pichai直接回应了员工对潜在AI泡沫的担忧,承认这一话题" definitely 在时代精神中"。

这种看似矛盾的现象——一边是泡沫论的喧嚣,一边是实实在在的扩容需求——反映了当前AI产业发展的复杂性。一方面,投资者和分析师担心过度投资可能导致市场崩溃;另一方面,科技巨头们正面临着真实而紧迫的算力需求,这些需求来自于已经上亿的用户和不断扩展的应用场景。

成本与可持续性的双重挑战

Google的扩容计划面临的最大挑战之一是如何在成本和可持续性之间取得平衡。Vahdat明确表示,公司需要在"基本相同的成本和日益相同的能耗水平"下实现算力的千倍增长。

这一目标看似不可能,但Google并非没有先例。过去十年,公司通过技术创新和规模效应,已经成功将数据中心能效提高了数倍。然而,这次的目标更为宏大——在保持成本和能耗不变的情况下实现算力千倍增长,这需要技术上的突破性创新。

可再生能源的采用是Google应对这一挑战的关键策略之一。公司承诺到2030年实现所有数据中心使用无碳能源,并已经在多个数据中心实现了这一目标。这不仅有助于减少碳足迹,还能在长期内降低能源成本。

行业竞争格局的重塑

随着Google、OpenAI等科技巨头在AI基础设施上投入巨资,整个行业竞争格局正在发生深刻变化。传统云计算提供商如AWS和Azure也在加大AI基础设施投资,试图在这一新兴领域保持竞争力。

与此同时,一些专注于AI芯片的新兴公司如Graphcore、Cerebras等也在崛起,试图挑战Nvidia在AI芯片领域的霸主地位。这种多元化的竞争格局有望加速技术创新,降低AI基础设施的成本。

未来展望:算力竞赛的赢家与输家

在这场前所未有的算力竞赛中,谁将成为最终的赢家?答案可能不止一个。不同的公司可能会在不同的细分领域建立竞争优势:有的可能在芯片设计上领先,有的可能在数据中心规模上占优,还有的可能在AI模型效率上取得突破。

然而,可以肯定的是,这场竞赛将推动整个AI产业向前发展,加速AI技术的普及和应用。从长远来看,算力的提升将使更复杂的AI模型成为可能,催生新的应用场景和商业模式,最终造福整个社会。

结论:泡沫与现实的辩证关系

AI泡沫论与Google扩容计划之间的矛盾,实际上反映了任何新兴技术发展初期的典型特征:一方面是过度乐观的预期和投资,另一方面是真实的技术挑战和需求。

历史告诉我们,每一次技术革命都会经历泡沫期,但泡沫破裂后留下的往往是真正的技术进步和产业变革。AI的发展可能也不例外——当前的算力竞赛看似疯狂,但它正在推动人类向更强大的AI能力迈进,这种进步最终将转化为实实在在的社会价值和经济价值。

对于Google和其他科技巨头而言,这场算力竞赛是一场豪赌,但他们赌的不是短期内的市场炒作,而是AI技术的长期发展前景。正如Vahdat所说:"这不容易,但通过协作和协同设计,我们将实现这一目标。"这或许正是科技巨头们在泡沫论声中依然坚定扩容的底气所在。