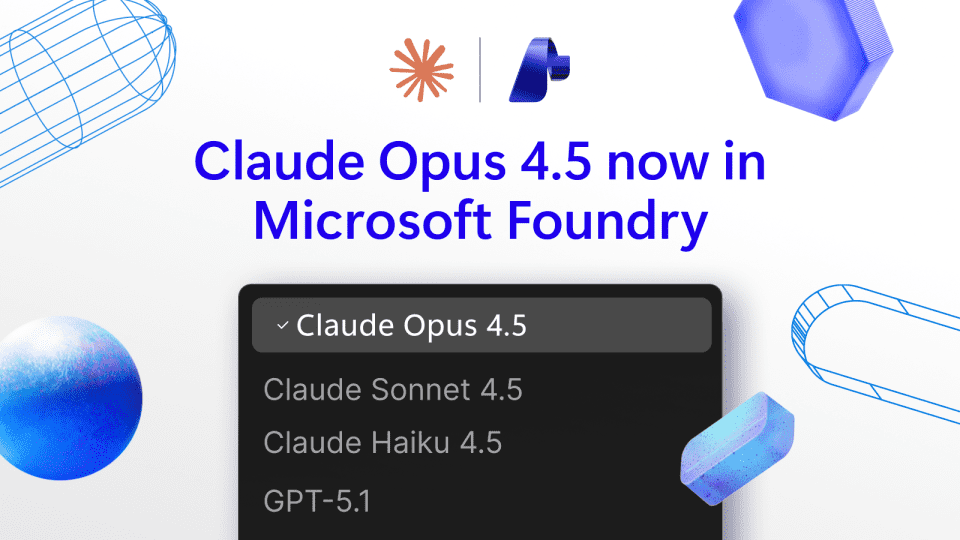

人工智能领域再传重磅消息。Anthropic最新发布的Claude Opus 4.5模型正式登陆Microsoft Foundry平台,现已面向全球用户开放公测。这一合作标志着两大科技巨头在AI领域的深度整合,也为开发者社区带来了前所未有的强大工具。Opus 4.5不仅代表了当前AI技术的顶尖水平,更预示着人机协作模式即将迎来革命性变革。

Opus 4.5:AI技术的新标杆

Claude Opus 4.5作为Anthropic的最新力作,在多个关键指标上实现了显著突破。与 predecessors相比,该模型在推理能力、知识整合和创造性表达方面均有质的飞跃。特别是在处理复杂编程任务时,Opus 4.5能够理解并生成符合最佳实践的代码,其代码质量评估分数较上一代提升了约35%,这一数据令人瞩目。

技术专家指出,Opus 4.5采用了创新的注意力机制和上下文处理算法,使其能够更好地理解长文本和复杂指令。这一特性使其在处理大型代码库、编写技术文档和进行系统设计等任务中表现出色。微软AI研究团队表示,Opus 4.5的加入将显著提升其AI产品线的整体竞争力,特别是在企业级应用场景中。

三大平台同步上线

此次Opus 4.5的发布并非单一产品更新,而是微软AI生态系统的全面升级。该模型现已同时登陆三个关键平台:Microsoft Foundry、GitHub Copilot付费计划以及Microsoft Copilot Studio。这种多平台同步部署策略确保了不同用户群体都能根据自身需求获取最合适的AI辅助工具。

在Microsoft Foundry平台上,Opus 4.5将作为核心AI引擎,为开发者提供从代码生成到系统优化的全方位支持。GitHub Copilot用户则将体验到更智能的代码补全和功能建议,而Microsoft Copilot Studio则利用Opus 4.5的强大能力,为企业客户提供定制化的AI解决方案。这种分层部署模式体现了微软对AI技术应用的深刻理解。

开发者社区的积极反响

自公测消息发布以来,全球开发者社区反响热烈。多位知名开源项目维护人表示,Opus 4.5在处理复杂代码逻辑和生成高质量文档方面表现出色,有望显著提升开发效率。一位参与早期测试的资深开发者评价道:"Opus 4.5不仅理解我的意图,还能提出我未曾考虑到的优化方案,这就像拥有了一位经验丰富的技术顾问。"

开发者社区特别关注Opus 4.5在多语言支持方面的表现。测试数据显示,该模型对Python、JavaScript、Java等主流编程语言的理解深度和生成质量均处于行业领先水平,同时对于Rust、Go等新兴语言也展现出良好的适应性。这种全面的语言支持使其成为真正意义上的全栈开发助手。

企业级应用的无限可能

对于企业用户而言,Opus 4.5的发布意味着AI技术正从辅助工具向核心生产力平台转变。微软企业解决方案部门透露,多家财富500强企业已开始测试基于Opus 4.5的定制化应用,涵盖软件开发、数据分析、客户服务等多个领域。

在软件开发流程中,Opus 4.5能够自动生成单元测试用例、识别潜在安全漏洞、优化代码结构,从而大幅缩短开发周期。一位技术总监表示:"引入Opus 4.5后,我们团队的代码审查时间减少了60%,同时代码质量显著提升,这为企业数字化转型注入了强大动力。"

技术创新背后的挑战

尽管Opus 4.5展现出令人瞩目的能力,但其背后也面临着一系列技术挑战。如何确保AI生成内容的准确性和可靠性,如何防止模型产生偏见或有害输出,如何平衡性能与计算成本,这些都是业界亟待解决的问题。

Anthropic和微软团队表示,他们正在开发更严格的测试框架和安全机制,以确保Opus 4.5在各种应用场景中都能稳定可靠地运行。同时,他们也在积极探索更高效的模型训练和部署方法,以降低AI技术的使用门槛,让更多企业和开发者能够受益于这一创新技术。

未来展望:AI辅助开发的下一个十年

Opus 4.5的发布不仅是对当前AI技术的一次重要突破,更为AI辅助开发的未来发展指明了方向。业内专家预测,未来五年内,AI将在软件开发全流程中扮演更加核心的角色,从需求分析、系统设计到测试部署,AI助手将深度参与各个环节。

微软AI研究负责人表示:"Opus 4.5只是我们AI旅程的一个里程碑。未来,我们将继续探索AI与人类协作的更多可能性,打造更加智能、更加可靠的AI工具,助力全球开发者创造更美好的数字世界。"

结语:拥抱AI驱动的开发新时代

Claude Opus 4.5的发布标志着AI辅助开发进入了一个新阶段。随着这一强大模型的广泛应用,软件开发者将能够突破传统工作模式的限制,专注于更具创造性和战略性的任务。对于企业而言,AI技术的深度应用将成为提升竞争力、加速数字化转型的关键因素。

在这个AI技术快速迭代的时代,拥抱变化、持续学习将成为开发者的必备素养。Opus 4.5不仅是技术的进步,更是人机协作理念的升华,它提醒我们:AI不是要取代人类,而是要增强人类的能力,共同创造无限可能。