在人工智能快速发展的今天,大型语言模型(LLMs)已成为我们日常生活和工作中的重要工具。然而,这些强大系统背后隐藏的安全漏洞和局限性正逐渐浮出水面。最新研究揭示了AI语言模型处理指令时存在的一个关键弱点:过度依赖句法结构而非实际意义。这一发现不仅解释了某些提示注入和越狱攻击为何能成功,更为我们理解AI如何工作以及何时失效提供了重要视角。

研究发现:语法优先于语义

MIT、东北大学和Meta的研究人员最近发表了一篇论文,指出类似ChatGPT的大型语言模型在回答问题时,有时会优先考虑句子结构而非实际含义。这项研究由Chantal Shaib和Vinith M. Suriyakumar领导,揭示了这些模型处理指令时存在的一个弱点,这可能解释了为什么某些提示注入或越狱方法能够奏效。

研究团队通过设计实验测试了这一假设。他们向模型提出的问题保留了语法模式,但使用了无意义的词汇。例如,当被提示"Quickly sit Paris clouded?"(模仿"Where is Paris located?"的结构)时,模型仍然回答"France"。这表明模型同时吸收了意义和句法模式,但当这些模式与训练数据中的特定领域高度相关时,模型可能会过度依赖结构捷径,在某些边缘情况下允许模式覆盖语义理解。

图1:"Where is Paris located? France"短语的模板设置示例,其中(Paris, France)表示领域国家的实体对。每个模板设置修改语法、领域或语义。如果模型在反义词或不流畅设置中回答"France",可能是由于过度依赖语法。

语法与语义的区分

为了更好地理解这一现象,我们需要区分语法和语义这两个概念。语法描述句子结构——词语如何语法排列以及它们使用什么词性。语义描述词语传达的实际含义,即使语法结构保持不变,语义也可能变化。

语义高度依赖于上下文,而理解上下文正是LLM工作的核心。将输入(提示)转换为输出(LLM回答)的过程,涉及与编码训练数据进行复杂模式匹配的连锁反应。

研究团队通过设计受控实验来调查这种模式匹配何时以及如何出错。他们创建了一个合成数据集,为每个学科领域设计了基于词性模式的独特语法模板。例如,地理问题遵循一种结构模式,而关于创意作品的问题遵循另一种模式。然后,他们使用这些数据训练了Allen AI的OLMo模型,并测试模型能否区分语法和语义。

模式匹配的陷阱

分析揭示了一种"虚假相关性",即模型在这些边缘情况下将语法视为领域的代理。当模式和语义冲突时,研究表明,AI对特定语法"形状"的记忆可能会覆盖语义解析,导致基于结构线索而非实际意义的错误回答。

用通俗的话来说,这项研究表明AI语言模型可能会过度关注问题的风格而非其实际含义。想象一下,如果有人学到以"Where is..."开头的问题总是关于地理,那么当你问"Where is the best pizza in Chicago?"时,他们会回答"Illinois",而不是基于其他标准推荐餐厅。他们是对语法模式("Where is...")做出反应,而不是理解你是在询问食物。

这带来了两种风险:模型在不熟悉的情境下给出错误答案(一种虚构形式),以及恶意行为者利用这些模式将有害请求包装在"安全"的语法风格中以绕过安全限制。这是一种领域切换的形式,可以重新构建输入,将其链接到不同的上下文以获得不同的结果。

实验结果:语法主导语义理解

为了衡量这种模式匹配的僵化程度,研究团队对模型进行了一系列语言压力测试,揭示语法常常主导语义理解。

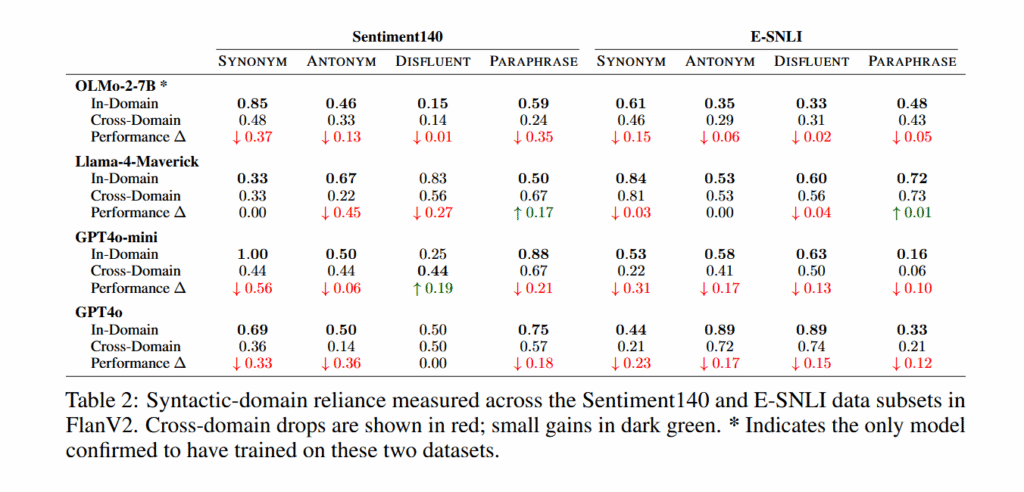

团队的实验显示,当OLMo模型在其训练领域内遇到同义词替换甚至反义词时,仍能保持高准确性。OLMo-2-13B-Instruct在用反义词替换原始单词的提示上达到了93%的准确率,几乎与其在精确训练短语上的94%准确率相匹配。然而,当相同的语法模板应用于不同学科领域时,不同模型大小的准确率下降了37到54个百分点。

表2:在FlanV2的Sentiment140和E-SNLI数据子集中测量的语法-领域依赖性。跨领域下降以红色显示;小幅增长以深绿色显示。 表示唯一确认训练过这两个数据集的模型。*

研究人员测试了五种类型的提示修改:训练中的精确短语、同义词、反义词、改变句子结构的改写,以及插入随机单词的"不流畅"(语法正确但无意义)版本。当问题保持在训练领域内时,模型在所有变体(包括改写,特别是在大型模型上)上都表现良好,但不流畅提示除外,其性能始终较差。跨领域性能在大多数情况下崩溃,而不流畅提示无论领域如何准确率仍然较低。

安全漏洞:语法黑客

研究团队还记录了由此行为引发的安全漏洞,可以称之为一种语法黑客形式。通过将有害请求前面加上良性训练领域的语法模式,他们绕过了OLMo-2-7B-Instruct的安全过滤器。当他们将思维链模板添加到WildJailbreak数据集中的1000个有害请求中时,拒绝率从40%下降到2.5%。

研究人员提供了使用此技术生成非法活动详细说明的示例。一个越狱提示产生了器官走私的分步指南。另一个描述了哥伦比亚和美国之间的贩毒方法。

研究局限性与不确定性

这些发现有几个需要注意的地方。研究人员无法确认GPT-4o或其他闭源模型是否实际使用了他们用于测试的FlanV2数据集进行训练。在没有访问训练数据的情况下,这些模型中的跨领域性能下降可能有其他解释。

基准测试方法也面临潜在的循环性问题。研究人员将"领域内"模板定义为模型回答正确的模板,然后测试模型在"跨领域"模板上是否会失败。这意味着他们基本上根据模型性能将示例分为"简单"和"困难",然后得出结论认为困难源于语法-领域相关性。性能差距可能反映其他因素,如记忆模式或语言复杂性,而非研究人员提出的特定相关性。

该研究专注于从10亿到130亿参数的OLMo模型。研究人员没有检查更大的模型或使用思维链输出训练的模型,这些模型可能表现出不同的行为。他们的合成实验有意创建了强模板-领域关联,以便孤立地研究这种现象,但现实世界的训练数据可能包含更复杂的模式,其中多个学科领域共享语法结构。

未来研究方向

尽管存在这些局限性,这项研究似乎为AI语言模型作为模式匹配机器的观点增加了更多证据,这些机器可能会被错误的上下文所干扰。LLM有许多故障模式,我们还没有完整的图景,但像这样的持续研究揭示了其中一些发生的原因。

研究人员计划在本月底的NeurIPS会议上展示这些发现,这可能会引发更多关于如何减轻这些风险的研究。未来的工作可能包括开发更强大的语义理解技术,创建能够更好区分语法和语义的模型,以及设计更强大的安全措施来防止语法黑客攻击。

对AI安全的影响

这项研究对AI安全领域有着深远的影响。首先,它强调了当前AI系统在理解语义方面的局限性,这可能导致意想不到的安全漏洞。其次,它为开发更安全的AI系统提供了方向,特别是在提示工程和安全协议设计方面。

企业和组织在部署AI系统时需要考虑这些发现,并采取措施减轻潜在风险。这可能包括实施更严格的提示过滤系统、开发能够更好理解语义的模型,以及持续监控和评估AI系统的行为。

结论

大型语言模型作为现代AI的核心组件,其工作原理和局限性正逐渐被我们理解。这项关于语法模式如何影响AI决策的研究,为我们提供了宝贵的见解,揭示了AI系统可能被操纵的方式。随着AI技术的不断发展,这样的研究将帮助我们构建更安全、更可靠的AI系统,确保它们能够按照预期工作,同时最小化潜在的风险和滥用可能性。

在AI安全这条漫长的道路上,每一步研究都至关重要。通过不断探索和改进,我们有望创造一个AI与人类和谐共存的未来,AI能够增强我们的能力,同时尊重我们的价值观和边界。