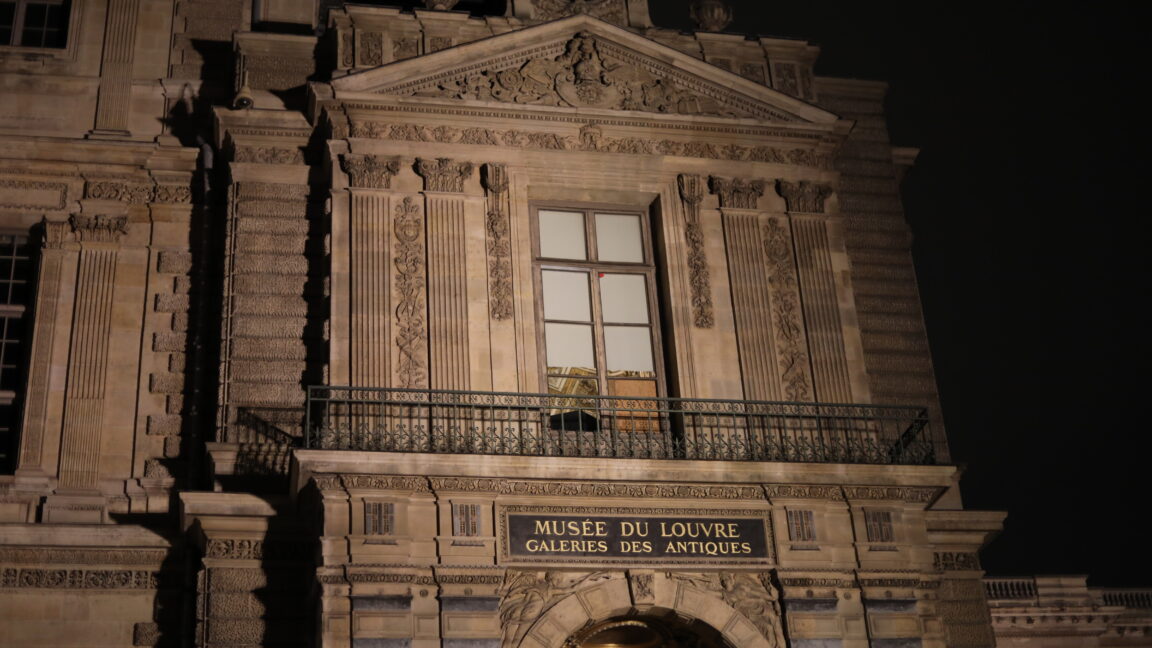

在2025年10月19日一个阳光明媚的早晨,四名男子走进世界上参观人数最多的博物馆,几分钟后带着价值8800万欧元(约合1.01亿美元)的皇冠珠宝离开。这次发生在巴黎卢浮宫——全球监控最严密的文化机构之一——的盗窃案仅用了不到八分钟。

游客们继续浏览展品,安全人员没有反应(直到警报被触发)。这些人在任何人意识到发生了什么之前,就消失在城市交通中。

调查人员后来揭示,窃贼穿着高可见度背心,将自己伪装成建筑工人。他们带来了一台升降梯,这在巴黎狭窄街道上很常见,并用它到达了俯瞰塞纳河的阳台。穿着工人的服装,他们看起来就像是属于那里的人。

社会表演与认知盲点

这种策略之所以奏效,是因为我们并非客观地看待世界。我们通过类别——通过我们期望看到的事物——来看待世界。窃贼理解了我们视为'正常'的社会类别,并利用它们来避免引起怀疑。许多人工智能(AI)系统以同样的方式运作,因此也容易犯同样的错误。

社会学家欧文·戈夫曼(Erving Goffman)会使用他的'自我呈现'概念来描述卢浮宫发生的事情:人们通过 adopting 他人期望的线索来'表演'社会角色。在这里,正常性的表演成为了完美的伪装。

视觉的社会学

人类不断进行心理分类,以理解人和事。当某事物符合'普通'类别时,它就会从视线中消失。

用于面部识别和在公共区域检测可疑活动的AI系统以类似方式运作。对人类来说,分类是文化性的;对AI而言,分类是数学性的。

但两种系统都依赖于'学习到的模式而非客观现实'。因为AI从关于谁看起来'正常'和谁看起来'可疑'的数据中学习,它吸收了嵌入其训练数据中的类别。这使它容易受到偏见的影响。

卢浮宫的窃贼不被视为危险,因为他们属于受信任的类别。在AI中,同样的过程可能产生相反的效果:不符合统计规范的人变得更显眼,受到过度审查。

这可能意味着面部识别系统不成比例地将某些种族或性别群体标记为潜在威胁,而让其他人轻易通过。

从博物馆大厅到机器学习

这种感知与分类之间的联系揭示了关于我们日益算法化的世界的重要信息。无论是保安决定谁看起来可疑,还是AI决定谁看起来像'小偷',基本过程都是相同的:根据看似客观但实则文化习得的线索将人分配到不同类别。

当AI系统被描述为'有偏见'时,这通常意味着它过于忠实地反映了这些社会类别。卢浮宫盗窃案提醒我们,这些类别不仅塑造我们的态度,还塑造了什么会被注意到。

盗窃发生后,法国文化部长承诺安装新摄像头并加强安全措施。但无论这些系统变得多么先进,它们仍然依赖于分类。无论是什么人或物,都必须决定什么算作'可疑行为'。如果这一决定基于假设,同样的盲点将持续存在。

类别思维的双刃剑

卢浮宫抢劫案将被铭记为欧洲最引人注目的博物馆盗窃案之一。窃贼之所以成功,是因为他们掌握了外表的社会学:他们理解正常性的类别并将其作为工具。

通过这样做,他们展示了人类和机器如何可能将一致性误认为是安全。他们在光天化日之下的成功不仅是计划的胜利,更是类别思维的胜利,这种逻辑同样支撑着人类感知和人工智能。

AI系统中的偏见与认知陷阱

AI系统在训练过程中吸收了人类社会的偏见和分类方式。当计算机视觉系统在安全监控录像上训练时,如果'正常'被特定的身体、服装或行为定义,它会重现这些假设。

正如博物馆的保安因为窃贼看起来属于那里而忽视了他们,AI可能会忽视某些模式,同时对其他模式过度反应。

分类,无论是人类还是算法性的,都是一把双刃剑。它帮助我们快速处理信息,但也编码了我们的文化假设。人类和机器都依赖于模式识别,这是一种高效但不完美的策略。

社会学视角下的AI

AI的社会学观点将算法视为镜子:它们反映我们的社会类别和等级制度。在卢浮宫案例中,这面镜子转向了我们。窃贼成功不是因为他们隐形了,而是因为他们通过正常性的视角被看待。用AI术语来说,他们通过了分类测试。

超越技术解决方案

卢浮宫文化部长承诺的新技术和更严格的安全措施虽然必要,但不足以解决根本问题。任何监控系统,无论多么先进,都依赖于对'正常'和'异常'的定义。如果这些定义基于有偏见的社会类别,那么同样的盲点将持续存在。

真正的解决方案需要超越纯粹的技术方法,包括:

- 多元化训练数据:确保AI系统接受多样化的训练数据,避免复制现有偏见

- 持续审计与调整:定期审查AI系统的决策模式,识别并纠正潜在偏见

- 人类监督机制:建立人类监督机制,在关键决策点进行干预

- 透明度与问责制:提高AI系统决策过程的透明度,明确责任归属

认知革命的前景

卢浮宫盗窃案提供了一个独特的机会,让我们重新思考人类认知和人工智能之间的关系。这个案例表明,在教机器'看'得更好之前,我们必须首先学会质疑我们自己的视觉方式。

认知科学和人工智能研究的交叉领域正在兴起,专注于理解人类和机器如何共同构建对世界的理解。这种跨学科方法可能帮助我们开发出更公平、更准确的AI系统,同时减少人类认知偏差的影响。

未来安全系统的设计原则

基于卢浮宫案例的教训,未来的安全系统设计应考虑以下原则:

- 情境感知:系统应考虑情境因素,而不仅仅是表面特征

- 不确定性表达:AI系统应能够表达其决策的不确定性

- 反偏见训练:专门设计训练数据以减少对特定群体的偏见

- 多模态验证:结合多种输入方式(视觉、音频、行为等)提高准确性

- 持续学习:系统能够从新数据中学习并适应变化的环境

结语:超越表面的思考

卢浮宫窃贼的成功提醒我们,表面现象往往具有欺骗性。无论是人类观察者还是AI系统,都可能陷入'看起来正常'的陷阱。真正的安全不仅依赖于技术,更依赖于对复杂性的理解和批判性思维。

在人工智能日益融入我们生活的今天,卢浮宫案例提供了一个重要的警示:在追求更智能的系统时,我们不应忽视对人类认知和社会结构的深入理解。只有将技术进步与社会洞察相结合,我们才能构建真正安全和公平的未来。

这一教训不仅适用于安全领域,也适用于所有依赖AI决策的领域——从医疗诊断到金融评估,从招聘系统到司法判决。通过认识到人类和AI共享的认知局限,我们可以开始设计更加包容和准确的系统,减少偏见,提高公平性。