探索Google AI Edge Gallery:设备端AI的新纪元

在人工智能技术日新月异的今天,谷歌推出了一款名为“Google AI Edge Gallery”的实验性应用,旨在让用户能够在本地设备上体验和使用机器学习(ML)及生成式人工智能(GenAI)模型。这款应用目前支持在Android设备上运行,最大的亮点在于无需联网即可使用,为开发者和AI爱好者提供了一个探索设备端AI强大功能的平台。

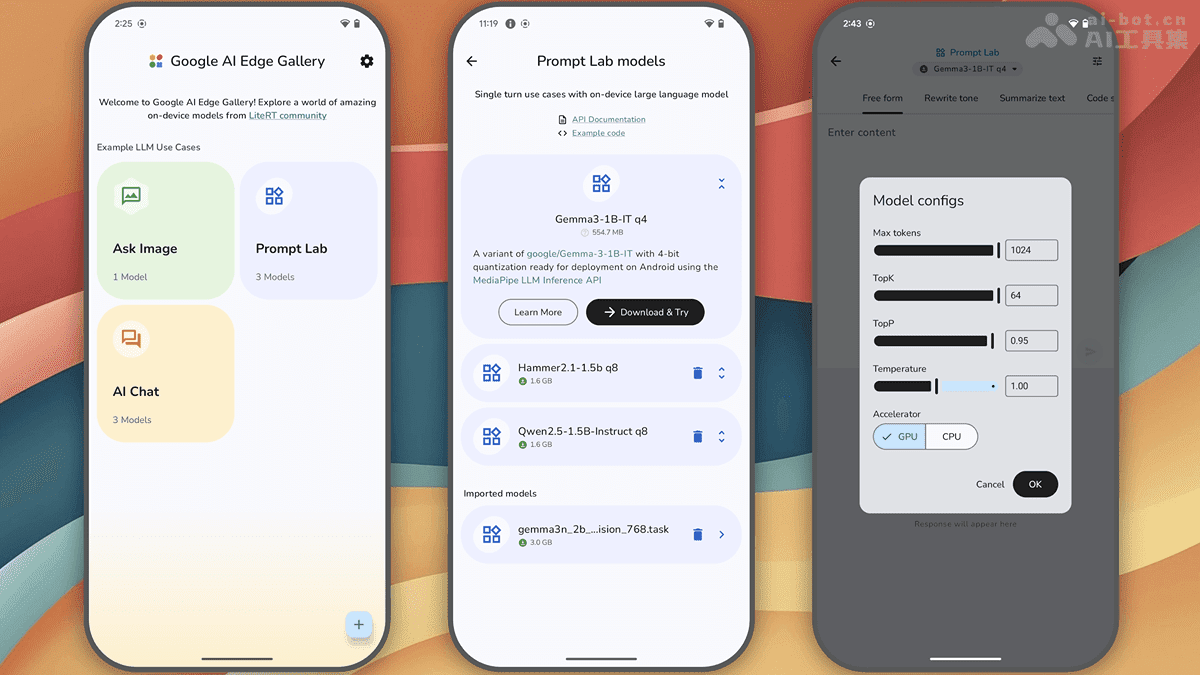

核心功能解析

Google AI Edge Gallery的核心功能主要体现在以下几个方面:

本地离线运行:这是该应用最吸引人的特性之一。所有的数据处理和计算都在用户的设备上完成,无需依赖云端服务器。这意味着用户可以在没有网络连接的情况下,依然能够体验到AI的强大功能,极大地提高了使用的便捷性和隐私性。

模型选择与性能比较:用户可以轻松地在Hugging Face上切换不同的模型,并对它们的性能进行比较。这为开发者提供了一个快速测试和评估不同模型的平台,有助于选择最适合自己应用场景的模型。

图像问答:用户可以上传图像,并向AI提出问题,获取对图像的描述、问题的解答或物体的识别结果。这项功能在图像识别、智能助手等领域有着广泛的应用前景。

提示词实验室:通过总结、改写、生成代码或使用自由形式的提示词,用户可以探索单轮对话的LLM(大型语言模型)用例。这为用户提供了一个试验和创新AI应用的平台,有助于发现新的应用场景。

AI聊天:支持多轮对话功能,用户可以与AI进行深入的交流,获取更个性化的服务。这项功能在智能客服、聊天机器人等领域有着广泛的应用。

性能洞察:提供实时的性能基准测试数据,包括首次响应时间、解码速度和延迟等。这为开发者优化模型性能提供了重要参考。

自带模型测试:支持测试本地LiteRT .task模型,方便开发者对自己的模型进行评估和优化。

开发者资源:提供快速链接到模型卡和源代码的入口,方便开发者获取更多关于模型的信息,加速开发流程。

技术原理剖析

Google AI Edge Gallery之所以能够实现强大的设备端AI功能,离不开以下几项关键技术的支持:

Google AI Edge:作为设备端机器学习的核心框架,Google AI Edge提供了一系列API和工具,使得机器学习模型能够在移动设备上高效运行。它通过优化计算和内存管理,降低了模型运行的资源消耗,提高了运行效率。

LiteRT:LiteRT是一种轻量级的运行时环境,专门用于优化模型的执行效率。它基于高效的内存管理和计算优化,确保模型在移动设备上快速运行,减少对设备资源的占用。LiteRT支持多种模型格式,包括但不限于TensorFlow Lite和ONNX,具有良好的兼容性。

LLM Inference API:LLM Inference API支持设备端大型语言模型(LLM)推理。这意味着用户可以在本地设备上运行复杂的语言模型,如GPT或其他基于Transformer架构的模型,而无需依赖云端服务。这大大提高了数据隐私和安全性。

Hugging Face 集成:通过集成Hugging Face的模型库,用户可以轻松地发现和下载各种预训练模型。Hugging Face提供丰富的模型资源,涵盖从自然语言处理到计算机视觉等多个领域。基于集成,用户可以直接在Gallery中使用模型,无需手动下载和配置,极大地简化了使用流程。

应用场景展望

Google AI Edge Gallery的应用场景非常广泛,几乎涵盖了个人、教育、专业开发、企业和日常生活等各个领域:

个人娱乐与创意:用户可以上传图片进行问答、生成创意文本或与AI进行多轮对话,满足娱乐和创意需求。例如,用户可以上传一张风景照,询问AI这是什么地方,或者让AI根据照片生成一段描述性的文字。

教育与学习:该应用可以作为语言学习、科学实验辅助和编程教育工具,提升学习效果。例如,学生可以使用AI进行语言翻译、语法检查,或者在科学实验中利用AI进行数据分析和模拟。

专业开发与研究:开发者可以利用该应用测试优化模型、快速搭建原型比较不同模型性能,助力开发流程。例如,开发者可以利用该应用测试自己训练的图像识别模型,或者比较不同模型的识别精度和速度。

企业与商业:企业可以利用该应用开发本地化客户支持工具,技术人员在无网环境下解决问题,同时保障数据隐私。例如,企业可以开发一个智能客服应用,利用AI自动回答客户的常见问题,或者在没有网络连接的情况下,利用AI进行故障诊断和修复。

日常生活:该应用可以辅助旅行规划、控制智能家居和获取健康建议,提升生活便利性。例如,用户可以利用AI进行旅行线路规划,或者通过AI控制智能家居设备,或者获取个性化的健康建议。

技术前沿与未来展望

Google AI Edge Gallery的推出,不仅为开发者和AI爱好者提供了一个探索设备端AI的平台,也预示着人工智能技术发展的新趋势。随着硬件性能的不断提升和算法的不断优化,设备端AI将在未来发挥越来越重要的作用。它可以更好地保护用户隐私,降低对网络连接的依赖,并提供更快速、更个性化的服务。

然而,设备端AI的发展也面临着一些挑战。例如,如何在有限的计算资源下运行复杂的模型,如何保证模型的安全性和可靠性,以及如何平衡性能和功耗等。这些问题需要开发者和研究者共同努力,不断探索和创新。

总的来说,Google AI Edge Gallery是一个具有创新性和实用性的应用。它为设备端AI的发展开辟了新的道路,也为我们展示了人工智能技术在未来的无限可能。随着技术的不断进步,我们有理由相信,设备端AI将在未来改变我们的生活,并为我们带来更多的便利和惊喜。

设备端AI:隐私与效率的双赢

Google AI Edge Gallery的出现,也标志着设备端AI技术进入了一个新的阶段。相较于传统的云计算模式,设备端AI具有以下显著优势:

- 更强的隐私保护:所有数据都在本地设备上处理,无需上传到云端,从而避免了数据泄露的风险。这对于注重隐私的用户来说,无疑是一个巨大的吸引力。

- 更低的延迟:由于数据处理在本地进行,避免了网络传输的延迟,响应速度更快,用户体验更流畅。

- 更高的可靠性:即使在没有网络连接的情况下,依然可以正常使用AI功能,提高了应用的可靠性和可用性。

- 更低的成本:减少了对云端服务器的依赖,降低了运营成本。

然而,设备端AI也面临着一些挑战:

- 计算资源限制:移动设备的计算能力相对较弱,难以运行复杂的AI模型。

- 存储空间限制:AI模型通常比较大,占用较多的存储空间。

- 功耗问题:运行AI模型会消耗大量的电量,影响设备的续航能力。

为了克服这些挑战,开发者需要不断优化模型,提高算法效率,并充分利用硬件加速技术。同时,也需要探索新的模型压缩和量化方法,以降低模型的大小和计算复杂度。

结语

Google AI Edge Gallery的推出,是人工智能技术发展的一个重要里程碑。它不仅为开发者提供了一个强大的工具,也为我们展示了设备端AI的巨大潜力。随着技术的不断进步,我们有理由相信,设备端AI将在未来发挥越来越重要的作用,并为我们的生活带来更多的便利和惊喜。