在当今快速发展的技术领域,空间音频技术正逐渐崭露头角,为虚拟现实、沉浸式娱乐等领域带来前所未有的体验。阿里巴巴通义实验室语音团队推出的OmniAudio,正是这一领域的创新成果。它是一种能够从360°视频生成空间音频(FOA)的模型,旨在为用户提供更加真实、沉浸的音频体验。本文将深入探讨OmniAudio的技术原理、主要功能、应用场景及其在行业中的价值。

OmniAudio:空间音频生成的新突破

随着虚拟现实(VR)和增强现实(AR)技术的日益成熟,用户对于沉浸式体验的需求也越来越高。传统的音频技术往往难以满足这种需求,因为它们无法捕捉声音的方向性和空间感。OmniAudio的出现,正是为了解决这一问题。它通过对360°视频进行分析,能够生成具有空间感的音频,让用户在虚拟环境中感受到声音的真实方位和移动,从而增强沉浸感。

为了训练OmniAudio模型,阿里巴巴通义实验室构建了一个大规模数据集Sphere360。该数据集包含超过10.3万个视频片段,涵盖288种不同的音频事件,总时长达到288小时。Sphere360数据集的丰富性和多样性,为OmniAudio模型的训练提供了坚实的基础。

OmniAudio的训练过程分为两个阶段:自监督的coarse-to-fine流匹配预训练和基于双分支视频表示的有监督微调。这两个阶段的训练相互补充,共同提升了OmniAudio模型的性能。

OmniAudio的主要功能与特点

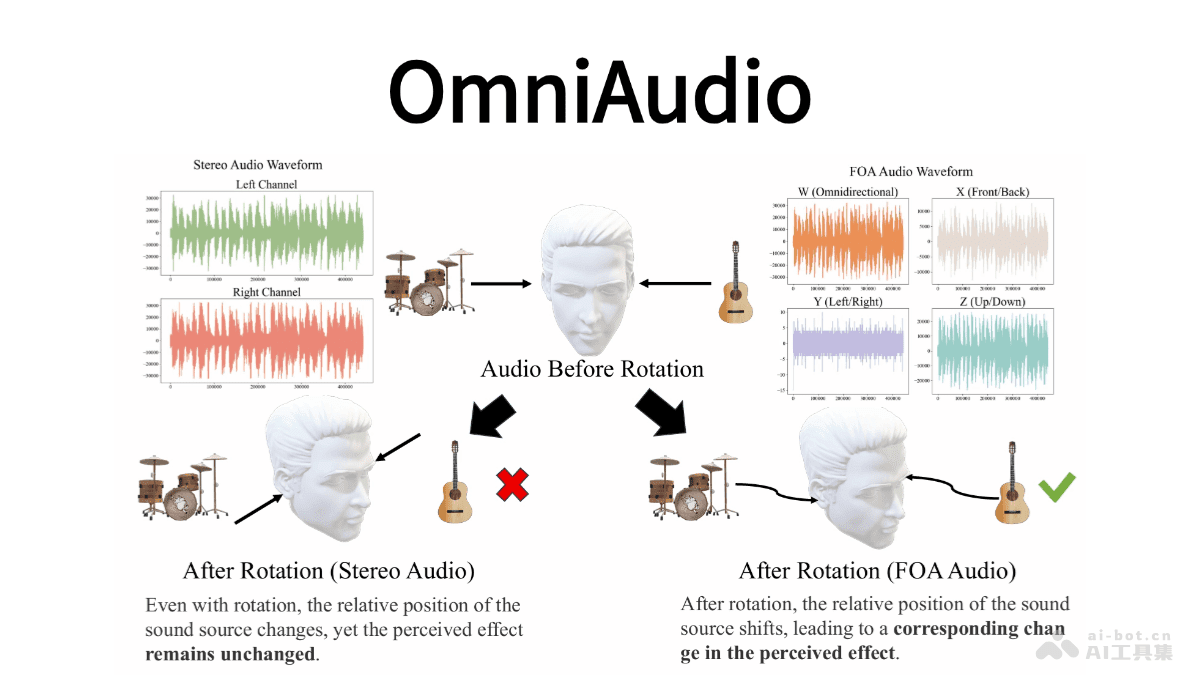

OmniAudio的核心功能是从360°视频生成空间音频。与传统的音频生成技术不同,OmniAudio生成的音频是FOA(First-Order Ambisonics)格式,这是一种标准的3D空间音频格式。FOA音频能够捕捉声音的方向性,从而实现真实的3D音频再现。

FOA音频使用四个通道(W、X、Y、Z)来表示声音。其中,W通道负责捕捉整体声压,X、Y、Z通道则分别捕捉前后、左右以及垂直方向的声音信息。这种表示方式使得FOA音频能够准确地还原声音在三维空间中的位置和移动。

OmniAudio的另一个重要特点是其能够提升沉浸式体验。通过生成具有空间感的音频,OmniAudio能够让用户在虚拟现实和沉浸式娱乐中获得更加真实的感受。例如,在观看VR电影时,如果场景中有一辆汽车从左向右驶过,OmniAudio能够生成相应的音频,让用户听到汽车从左边传来,然后逐渐移动到右边的声音,从而增强用户的沉浸感。

OmniAudio的技术原理:深度学习与空间音频的结合

OmniAudio的技术原理主要包括两个方面:自监督的coarse-to-fine流匹配预训练和基于双分支视频表示的有监督微调。

自监督的coarse-to-fine流匹配预训练

由于真实的FOA数据相对稀缺,研究团队首先利用大规模的非空间音频资源(如FreeSound、AudioSet、VGGSound等)进行自监督学习。为了利用这些非空间音频数据,研究团队将立体声转换为“伪FOA”格式。具体来说,W通道为左右声道之和,X通道为左右声道之差,Y、Z通道置零。这种转换方法虽然简单,但能够有效地提取音频的时序和结构信息。

在模型训练过程中,研究团队将转换后的“伪FOA”音频送入四通道VAE(Variational Autoencoder)编码器,获得潜在表示。然后,以一定的概率对潜在表示进行随机时间窗掩码,并将掩码后的潜在序列与完整序列一同作为条件输入至流匹配模型。流匹配模型通过最小化掩码前后潜在状态的速度场差异,实现对音频时序和结构的自监督学习。通过这个阶段的训练,模型能够掌握通用的音频特征和宏观时域规律,为后续空间音频的精细化提供了基础。

基于双分支视频表示的有监督微调

在完成自监督预训练后,研究团队使用真实的FOA音频数据对模型进行有监督微调。在这个阶段,模型主要关注四通道的空间特性。

为了强化模型对声源方向的表征能力,研究团队对真实的FOA潜在序列进行更高概率的掩码,从而迫使模型更加关注W/X/Y/Z四个通道之间的互补关系。通过这种方式,模型在解码端能够提升对高保真空间音频细节的重建效果。

在微调过程中,研究团队还将模型与双分支视频编码器结合。对于输入的360°全景视频,使用冻结的MetaCLIP-Huge图像编码器提取全局特征。同时,从同一视频中裁取FOV(Field of View)局部视角,同样通过该编码器获取局部细节表征。全局特征经最大池化后作为Transformer的全局条件,局部特征经时间上采样后与音频潜在序列逐元素相加,作为逐步生成过程中的局部条件。

通过这种双分支结合的方式,模型能够同时利用全局和局部视频信息,从而更加准确地生成与视频内容相匹配的空间音频。在微调完成后,在推理阶段只需采样学得的速度场,再经VAE解码器恢复波形,就能输出与360°视频高度对齐、具备精确方向感的四通道空间音频。

OmniAudio的应用场景:从VR到智能家居

OmniAudio的应用场景非常广泛,涵盖了虚拟现实、沉浸式娱乐、智能语音助手、机器人和自动驾驶等多个领域。

虚拟现实(VR)和沉浸式体验

OmniAudio最直接的应用场景是虚拟现实(VR)和沉浸式体验。通过为VR内容生成与视觉场景高度匹配的空间音频,OmniAudio能够显著增强用户的沉浸感。例如,在VR游戏中,如果玩家听到敌人的脚步声从身后传来,他们会立即意识到危险,并迅速做出反应。这种真实的听觉体验能够极大地提升游戏的乐趣。

360°视频配乐

OmniAudio还可以用于为360°全景视频自动生成沉浸式音效。传统的视频配乐往往只能提供简单的背景音乐,而无法提供与视频内容相匹配的空间音频。OmniAudio能够根据视频内容自动生成具有方向感和空间感的音效,使观众在观看视频时能获得更真实的听觉体验。例如,在观看一段在森林中拍摄的360°视频时,OmniAudio能够生成鸟鸣、树叶沙沙作响等声音,让观众仿佛身临其境。

智能语音助手

OmniAudio还可以集成到智能家居设备中,如智能音箱、智能家电等,实现语音控制和交互。通过结合语音识别和空间音频技术,智能语音助手能够更加准确地理解用户的指令,并提供更加个性化的服务。例如,用户可以通过语音指令控制家电的开关、调节温度、查询信息等。

机器人和自动驾驶领域

OmniAudio还可以应用于机器人和自动驾驶领域,为这些系统提供更准确的声音定位和环境感知。在机器人领域,OmniAudio可以帮助机器人识别声音的来源,从而更好地理解周围环境。在自动驾驶领域,OmniAudio可以帮助车辆识别警笛声、喇叭声等,从而提高驾驶安全性。

OmniAudio的行业价值与未来展望

OmniAudio的推出,不仅为空间音频技术带来了新的突破,也为相关行业带来了巨大的价值。通过提供更加真实、沉浸的音频体验,OmniAudio能够提升虚拟现实、沉浸式娱乐等领域的用户体验,推动这些领域的发展。

随着技术的不断进步,OmniAudio的未来发展前景广阔。一方面,可以通过改进模型结构、优化训练方法等方式,进一步提升OmniAudio的性能。另一方面,可以将OmniAudio与其他技术相结合,如人工智能、云计算等,拓展其应用场景。

例如,可以将OmniAudio与人工智能技术相结合,实现更加智能化的音频生成。通过分析视频内容,自动识别其中的物体、场景等,并生成与之相匹配的空间音频。此外,还可以将OmniAudio与云计算技术相结合,实现大规模的音频生成和处理。通过将计算任务分布到云端,可以大大提高音频生成的效率。

总而言之,OmniAudio作为阿里巴巴通义实验室语音团队推出的一项创新技术,为空间音频领域带来了新的突破。它不仅能够从360°视频生成高质量的空间音频,还能够提升虚拟现实、沉浸式娱乐等领域的用户体验。随着技术的不断进步和应用场景的不断拓展,OmniAudio有望在未来发挥更大的作用,为人们的生活带来更多的便利和乐趣。