在人工智能技术日新月异的今天,AI 模型的“幻觉”现象——即生成看似合理实则虚假的信息——已经引起了广泛关注。近日,音乐平台 Soundslice 就遭遇了一起由 ChatGPT 造成的“乌龙”事件,但他们却巧妙地将危机转化为机遇,走出了一条意想不到的创新之路。

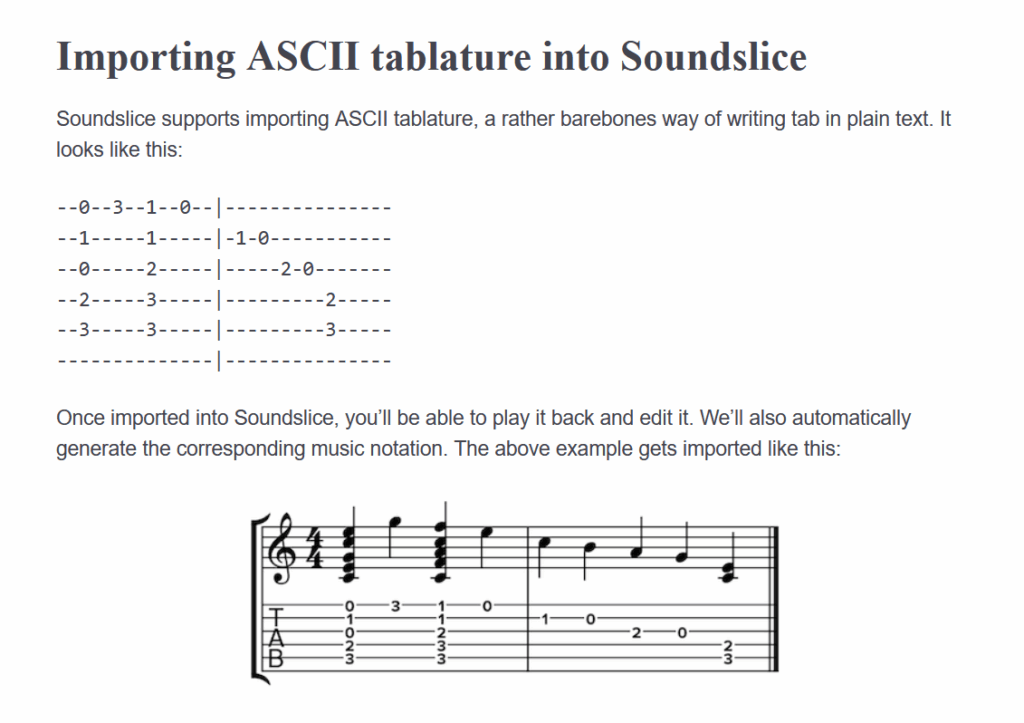

事情的起因是这样的:ChatGPT 在与用户的对话中,错误地声称 Soundslice 平台支持导入 ASCII Tab(一种文本格式的吉他谱)。然而,Soundslice 实际上从未提供过此项功能。这一虚假信息的传播,导致大量用户涌入 Soundslice,试图上传 ASCII Tab 文件,使得该公司的错误日志中充斥着此类无效请求。

Soundslice 的联合创始人 Adrian Holovaty 在其博客中分享了这一事件的始末。起初,他对这些异常的活动感到困惑不解。直到他亲自测试了 ChatGPT,才真相大白:AI 模型在“一本正经地胡说八道”,误导用户,给 Soundslice 带来了负面的影响。

面对这一突如其来的挑战,Soundslice 并没有选择置之不理,而是积极地应对。他们没有发布声明来澄清 ChatGPT 的错误信息,而是逆向思维,决定满足这一“虚假的市场需求”。于是,Soundslice 的团队着手开发了 ASCII Tab 导入功能,并更新了用户界面,正式支持该功能。

这一举措无疑是成功的。Soundslice 不仅解决了用户的问题,还赢得了用户的赞赏。更重要的是,他们将一次潜在的危机转化为了创新动力,为平台增添了一项实用的新功能。

AI 的“幻觉”:机遇还是挑战?

Soundslice 的案例引发了我们对于 AI 模型“幻觉”现象的深入思考。一方面,AI 的“幻觉”可能会导致信息混乱,误导用户,甚至造成严重的损失。例如,在法律领域,律师使用 ChatGPT 生成的虚假案例,可能会面临法律制裁;在客户服务领域,AI 聊天机器人提供错误的政策信息,可能会损害企业的声誉。

另一方面,AI 的“幻觉”也可能成为创新的催化剂。Soundslice 的案例就是一个很好的例证。通过认真对待 AI 产生的“幻觉”,企业可以发现潜在的市场需求,并以此为契机,开发出新的产品或服务。

如何应对 AI 的“幻觉”?

那么,企业应该如何应对 AI 的“幻觉”呢?以下是一些建议:

建立完善的错误监测机制:企业需要密切关注 AI 模型的输出结果,及时发现并纠正错误信息。这可以通过人工审核、用户反馈等方式来实现。

加强 AI 模型的训练:企业需要不断地优化 AI 模型的训练数据,提高其准确性和可靠性。这可以通过增加训练数据的数量、提高训练数据的质量等方式来实现。

制定清晰的风险应对策略:企业需要预先制定应对 AI “幻觉”的风险应对策略,明确责任分工,确保在出现问题时能够迅速有效地解决。

保持开放的心态:企业需要以开放的心态看待 AI 的“幻觉”,将其视为一种潜在的创新机会,而不是一种威胁。通过积极地应对 AI 的“幻觉”,企业可以不断地提升自身的竞争力和创新能力。

案例分析:其他企业如何应对 AI 的“幻觉”

除了 Soundslice 之外,还有一些其他的企业也成功地应对了 AI 的“幻觉”,并从中受益。

Air Canada:2024 年,Air Canada 的一个客户服务聊天机器人错误地向客户承诺,可以追溯申请 90 天内的丧亲折扣。尽管这一政策并不存在,但加拿大民事决议法庭裁定 Air Canada 必须兑现这一承诺,并向客户赔偿损失。Air Canada 随后修改了其政策,正式允许客户追溯申请丧亲折扣。

某在线旅游平台:该平台使用 AI 模型为用户生成旅游攻略。AI 模型有时会生成一些不准确的信息,例如推荐已经关闭的景点。该平台通过建立用户反馈机制,及时发现并纠正这些错误信息。同时,该平台还利用这些错误信息,改进 AI 模型,提高其准确性。

AI 驱动的未来:机遇与挑战并存

人工智能正在深刻地改变着我们的世界。AI 模型在提高效率、降低成本、改善用户体验等方面具有巨大的潜力。然而,AI 的发展也面临着一些挑战,例如数据安全、隐私保护、算法偏见等。AI 的“幻觉”是其中一个重要的挑战。

企业需要正视 AI 的“幻觉”,积极地应对,并将其转化为创新的机遇。只有这样,才能在 AI 驱动的未来中立于不败之地。

技术解析:AI “幻觉”的成因

AI 模型的“幻觉”并非无中生有,而是其内在工作机制的必然结果。理解其成因,有助于我们更好地应对和利用这一现象。

1. 数据偏差与知识盲区

AI 模型,尤其是大型语言模型,依赖于海量数据进行训练。然而,这些数据并非完美无缺,可能存在偏差、噪声或知识覆盖不全的问题。当 AI 模型遇到训练数据中未曾出现或 недостаточно хорошо 描述的情境时,便可能出现“幻觉”,编造信息以填补知识空白。

例如,如果一个 AI 模型接受的吉他谱数据中缺乏对 ASCII Tab 的充分描述,它就可能错误地认为 Soundslice 平台支持该格式,并进一步生成误导性信息。

2. 统计推断与模式匹配

AI 模型本质上是统计推断机器,它们通过学习数据中的模式来预测和生成内容。在缺乏足够信息的情况下,AI 模型会基于已知的模式进行推断,即使这种推断并不符合事实。

ChatGPT 在回答关于 Soundslice 功能的问题时,可能基于其对音乐平台的理解和对 ASCII Tab 的认知,推断出 Soundslice 应该支持该功能。这种推断虽然看似合理,但实际上是错误的。

3. 目标函数与优化策略

AI 模型的训练目标是最小化预测误差,但这并不意味着它必须完全符合事实。在某些情况下,为了更好地完成任务,AI 模型可能会牺牲一定的准确性,生成一些“创造性”的内容。

例如,为了提供更流畅、更自然的对话体验,ChatGPT 可能会在回答问题时加入一些虚构的信息,即使这些信息并不完全真实。

应对策略:从技术到伦理

应对 AI “幻觉”需要从技术和伦理两个层面入手,采取综合性的策略。

1. 技术层面

- 数据增强与清洗:通过增加训练数据的数量和质量,减少数据偏差和噪声,提高 AI 模型的知识覆盖率。

- 知识图谱与外部知识库:将外部知识库(如维基百科、专业领域知识图谱)融入 AI 模型,使其能够访问更准确、更全面的信息。

- 可解释性 AI:开发可解释性 AI 技术,使我们能够理解 AI 模型的决策过程,发现其潜在的错误和偏差。

- 对抗训练:使用对抗训练技术,提高 AI 模型对“幻觉”的抵抗能力。

2. 伦理层面

- 透明度与可追溯性:确保 AI 模型的输出结果具有透明度和可追溯性,使用户能够判断其真实性和可靠性。

- 责任归属:明确 AI 模型的开发者、部署者和使用者的责任,确保在出现问题时能够追究责任。

- 伦理审查:对 AI 模型的开发和部署进行伦理审查,确保其符合伦理规范和社会价值观。

结论:拥抱 AI,谨慎前行

AI 技术的快速发展为我们带来了前所未有的机遇,同时也带来了一些挑战。AI 的“幻觉”是其中一个重要的挑战,但它也可能成为创新的催化剂。企业需要正视 AI 的“幻觉”,积极地应对,并将其转化为创新的机遇。只有这样,才能在 AI 驱动的未来中立于不败之地。同时,我们也需要从技术和伦理两个层面入手,采取综合性的策略,确保 AI 的发展符合伦理规范和社会价值观,造福人类。

总之,AI 是一把双刃剑,我们既要拥抱它,也要谨慎前行。只有这样,才能充分发挥 AI 的潜力,实现人类与 AI 的和谐共生。