在人工智能快速发展的浪潮中,大型语言模型(LLM)如ChatGPT已经渗透到我们生活的方方面面,从撰写邮件到辅助编程,它们的能力令人惊叹。然而,这些模型并非完美无缺,它们有时会“虚构”信息,即产生听起来合理但实际上并不存在的事实,这种现象被称为“幻觉”或“虚构”。本文将深入探讨这一现象,并通过一个独特的案例——Soundslice公司因ChatGPT的虚构而意外开发新功能——来剖析AI的局限性与可能性。

AI的“幻觉”现象:一个值得警惕的问题

大型语言模型通过分析海量文本数据来学习,并根据统计模式生成文本。这种机制使得它们在处理不熟悉或数据稀缺的主题时,容易出现“幻觉”。简单来说,模型会根据已有的知识进行推测和“脑补”,从而产生看似合理但不真实的陈述。这种现象在各个领域都可能发生,例如,在法律领域,律师可能会引用ChatGPT生成的虚假案例,导致严重的法律后果;在客户服务领域,AI 聊天机器人可能会提供错误的政策信息,损害公司声誉。

Soundslice的意外发现:从错误到创新的转变

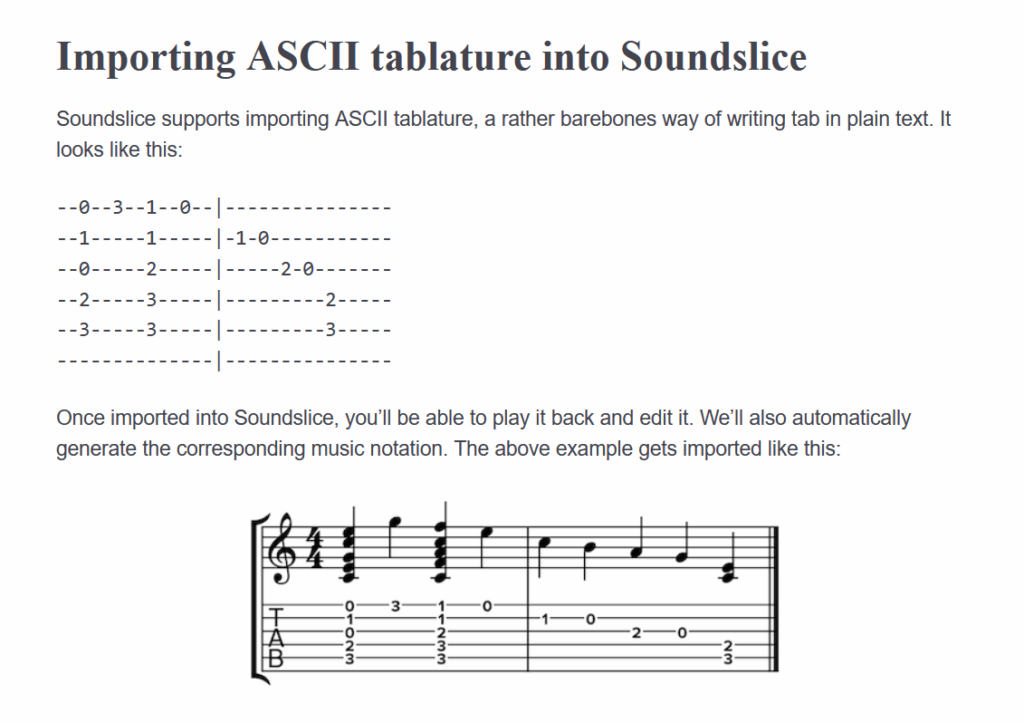

Soundslice是一家致力于将乐谱数字化并与音频或视频同步的平台,旨在帮助音乐家更高效地学习和练习音乐。最近,该公司意外地卷入了一场由ChatGPT引发的“幻觉”事件。事情的起因是,Soundslice的创始人Adrian Holovaty注意到,公司的错误日志中出现大量与ASCII tablature相关的上传尝试。ASCII tablature是一种基于文本的吉他谱格式,Soundslice此前从未支持过。

Holovaty对此感到困惑不解,直到他亲自测试了ChatGPT,才发现了问题的根源。原来,ChatGPT一直在向用户推荐Soundslice,并声称该平台可以导入ASCII tablature并进行音频播放。然而,这是一个彻头彻尾的谎言,Soundslice根本不具备这项功能。ChatGPT的虚假宣传不仅给用户带来了困扰,也损害了Soundslice的声誉。

面对这一突如其来的挑战,Soundslice并没有选择置之不理或发布声明澄清。相反,他们做出了一个大胆而富有创意的决定:开发一个ASCII tablature导入器,满足ChatGPT所“创造”的市场需求。Holovaty坦言,这个功能原本不在他的计划之内,甚至排在“2025年最不可能开发的功能”之列。但最终,Soundslice还是克服了技术难题,成功地推出了这项新功能。

从“幻觉”到现实:Soundslice案例的启示

Soundslice的案例为我们提供了一个独特的视角,让我们重新审视AI的“幻觉”现象。它表明,“幻觉”不仅是一种潜在的风险,也可以成为创新的催化剂。通过积极应对AI的错误,企业可以发现新的市场需求,并开发出意想不到的产品和服务。当然,这并不意味着我们应该鼓励或纵容AI的“幻觉”。相反,我们应该采取措施来减少其发生的频率和影响,例如,改进训练数据、优化模型算法、加强用户教育等。

如何应对AI的“幻觉”:一些建议

1. 提高AI的透明度

让用户了解AI的工作原理和局限性,帮助他们更好地理解AI的输出结果。例如,可以提供AI生成文本的置信度评分,或者解释AI做出决策的依据。

2. 实施严格的审核机制

对于AI生成的关键信息,例如法律建议、医疗诊断等,应由专业人士进行审核,确保其准确性和可靠性。

3. 加强用户反馈机制

鼓励用户积极反馈AI的错误,帮助开发者及时发现和修复问题。同时,也要向用户提供清晰的纠错渠道,方便他们更正AI的错误。

4. 持续改进训练数据

确保训练数据的质量和多样性,避免引入偏差和错误。同时,也要定期更新训练数据,使AI能够及时学习最新的知识和信息。

5. 探索新的模型架构

研究更可靠、更可信的AI模型架构,例如,基于知识图谱的模型、基于因果推理的模型等。这些模型可以更好地理解世界的本质,从而减少“幻觉”的发生。

AI的未来:机遇与挑战并存

人工智能正在深刻地改变着我们的世界,它为我们带来了前所未有的机遇,也带来了前所未有的挑战。大型语言模型作为AI领域的重要组成部分,其发展前景广阔,但也面临着诸多问题,其中“幻觉”现象就是一个亟待解决的难题。只有正视这些问题,并积极寻求解决方案,我们才能充分发挥AI的潜力,造福人类社会。

案例分析:AI“幻觉”在其他领域的应用与影响

1. 医疗健康

AI在医疗健康领域的应用日益广泛,例如,辅助诊断、药物研发、个性化治疗等。然而,AI的“幻觉”也可能对患者的健康造成威胁。例如,AI 诊断系统可能会根据错误的医学知识,给出错误的诊断结果,导致患者延误治疗或接受不必要的治疗。因此,在医疗健康领域,必须对 AI 的输出结果进行严格的审核和验证,确保其准确性和安全性。

2. 金融服务

AI 在金融服务领域的应用包括风险评估、欺诈检测、智能投顾等。如果 AI 出现“幻觉”,可能会导致错误的投资决策、不公正的贷款审批等问题。例如,AI 智能投顾可能会根据虚假的经济数据,向用户推荐高风险的投资产品,导致用户损失惨重。因此,在金融服务领域,需要建立完善的风险管理体系,防范 AI “幻觉”带来的潜在风险。

3. 教育行业

AI 在教育行业的应用包括智能辅导、个性化学习、自动评分等。如果 AI 出现“幻觉”,可能会导致错误的知识传授、不公正的成绩评定等问题。例如,AI 辅导系统可能会根据错误的语法规则,纠正学生的作文,导致学生学习到错误的知识。因此,在教育行业,需要加强对 AI 算法的监督和评估,确保其教育内容的准确性和权威性。

数据佐证:AI“幻觉”的发生频率与影响范围

目前,关于 AI “幻觉”的发生频率和影响范围,还没有全面的统计数据。但是,一些研究表明,AI “幻觉”的发生频率并不低,而且其影响范围也可能非常广泛。例如,一项针对 ChatGPT 的研究发现,ChatGPT 在回答问题时,大约有 20% 的概率会产生“幻觉”。另一项研究表明,AI “幻觉”可能会对人们的决策产生显著的影响,尤其是在信息不对称的情况下。

这些数据表明,AI “幻觉”是一个不容忽视的问题,需要我们采取积极的措施来应对。

未来展望:如何构建更可靠、更可信的 AI 系统

为了构建更可靠、更可信的 AI 系统,我们需要从以下几个方面入手:

1. 提升 AI 的知识水平

通过引入更多的知识图谱、专家系统等,提升 AI 的知识水平,使其能够更好地理解世界的本质。

2. 增强 AI 的推理能力

研究基于因果推理的模型,使 AI 能够更好地理解事物之间的因果关系,从而减少“幻觉”的发生。

3. 改进 AI 的学习方法

探索新的学习方法,例如,主动学习、强化学习等,使 AI 能够更好地从数据中学习知识,并避免引入偏差和错误。

4. 建立完善的评估体系

建立完善的评估体系,对 AI 系统的各个方面进行评估,包括准确性、可靠性、安全性等,及时发现和修复问题。

5. 加强人机协作

加强人机协作,充分发挥人类的智慧和经验,共同解决复杂的问题,避免 AI 单独做出错误的决策。

通过以上努力,我们有望构建更可靠、更可信的 AI 系统,使其更好地服务于人类社会。